Глубокое обучение — различия между версиями

Evaleria (обсуждение | вклад) м |

Evaleria (обсуждение | вклад) м (→История) |

||

| Строка 6: | Строка 6: | ||

Стоит отметить, что первый общий рабочий алгоритм для глубоких многослойных перцептронов прямого распространения был опубликован в книге советских учёных Алексея Григорьевича Ивахненко и Валентина Григорьевича Лапы «Кибернетические предсказывающие устройства». Сам термин «глубокое обучение» появился в научном сообществе машинного обучения в 1986 году в работе израильско-американской ученой Рины Дехтер «Learning While Searching in Constraint-Satisfaction-Problems»<ref>[https://www.researchgate.net/publication/221605378_Learning_While_Searching_in_Constraint-Satisfaction-Problems Learning While Searching in Constraint-Satisfaction-Problems]</ref>. | Стоит отметить, что первый общий рабочий алгоритм для глубоких многослойных перцептронов прямого распространения был опубликован в книге советских учёных Алексея Григорьевича Ивахненко и Валентина Григорьевича Лапы «Кибернетические предсказывающие устройства». Сам термин «глубокое обучение» появился в научном сообществе машинного обучения в 1986 году в работе израильско-американской ученой Рины Дехтер «Learning While Searching in Constraint-Satisfaction-Problems»<ref>[https://www.researchgate.net/publication/221605378_Learning_While_Searching_in_Constraint-Satisfaction-Problems Learning While Searching in Constraint-Satisfaction-Problems]</ref>. | ||

| − | Многие архитектуры глубокого обучения берут своё начало с искусственной нейронной сети Neocognitron<ref>[https://en.wikipedia.org/wiki/Neocognitron Neocognitron, Wikipedia]</ref>, представленной в 1980 году Кунихикой Фукусимой. Особенное влияние данная сеть оказала на архитектуры, использующиеся для компьютерного зрения. В 1989 году Яну Лекуну удалось использовать алгоритм обратного распространения ошибки для обучения глубоких нейросетей для решения задачи распознавания рукописных ZIP-кодов<ref>[https://www.ics.uci.edu/~welling/teaching/273ASpring09/lecun-89e.pdf Backpropagation Applied to Handwritten Zip Code Recognition]</ref>. Хотя алгоритм работал, на его обучение потребовалось 3 дня, что существенно ограничевало применимость данного метода. Из-за низкой | + | Многие архитектуры глубокого обучения берут своё начало с искусственной нейронной сети Neocognitron<ref>[https://en.wikipedia.org/wiki/Neocognitron Neocognitron, Wikipedia]</ref>, представленной в 1980 году Кунихикой Фукусимой. Особенное влияние данная сеть оказала на архитектуры, использующиеся для компьютерного зрения. В 1989 году Яну Лекуну удалось использовать алгоритм обратного распространения ошибки для обучения глубоких нейросетей для решения задачи распознавания рукописных ZIP-кодов<ref>[https://www.ics.uci.edu/~welling/teaching/273ASpring09/lecun-89e.pdf Backpropagation Applied to Handwritten Zip Code Recognition]</ref>. Хотя алгоритм работал, на его обучение потребовалось 3 дня, что существенно ограничевало применимость данного метода. Из-за низкой скорости обучения нейронные сети в 1990-х годах уступили место методу опорных векторов. |

| − | Популярность глубокое обучение приобрело в середине 2000-х годов. Этому | + | Популярность глубокое обучение приобрело в середине 2000-х годов. Этому способствовали несколько факторов: |

* появились более мощные компьютеры, способные обучать большие нейронные сети; | * появились более мощные компьютеры, способные обучать большие нейронные сети; | ||

* появились новые датасеты, достаточные по объёму, чтобы обучение больших сетей имело смысл; | * появились новые датасеты, достаточные по объёму, чтобы обучение больших сетей имело смысл; | ||

| − | * произошли существенные продвижения в теории искусственных нейронных сетей. В | + | * произошли существенные продвижения в теории искусственных нейронных сетей. В появившихся статьях авторы показали, что можно эффективно предобучать многослойную нейронную сеть, если обучать каждый слой отдельно при помощи ограниченной машины Больцмана, а затем дообучать при помощи метода обратного распространения ошибки; |

| − | * технология привлекли внимание крупных медиа, | + | * технология привлекли внимание крупных медиа, {{---}} первым из мировых СМИ об этом написал The New York Times. |

== Определение == | == Определение == | ||

Версия 16:28, 6 декабря 2018

Глубокое обучение (англ. deep learning) — совокупность широкого семейства методов машинного обучения, основанных на обучении представлениям, а не специализированным алгоритмам под конкретные задачи. Глубокое обучение может быть с учителем, с частичным привлечением учителя, без учителя и с подкреплением. Несмотря на то, что данный раздел машинного обучения появился еще в 1980х, до недавнего времени его применение было сильно ограничено из-за недостака вычислительных мощностей существовавших компьютеров. Ситуация изменилась только в середине 2000х.

На создание моделей глубокого обучения оказали влияние некоторые процессы и паттерны, происходящие в биологических нейронных системах. Несмотря на это, данные модели имеют множество различий с биологическим мозгом (и в структуре и в функциях), что делает невозможным использование теорем и доказательств, применяющихся нейробиологии.

Содержание

История

Стоит отметить, что первый общий рабочий алгоритм для глубоких многослойных перцептронов прямого распространения был опубликован в книге советских учёных Алексея Григорьевича Ивахненко и Валентина Григорьевича Лапы «Кибернетические предсказывающие устройства». Сам термин «глубокое обучение» появился в научном сообществе машинного обучения в 1986 году в работе израильско-американской ученой Рины Дехтер «Learning While Searching in Constraint-Satisfaction-Problems»[1].

Многие архитектуры глубокого обучения берут своё начало с искусственной нейронной сети Neocognitron[2], представленной в 1980 году Кунихикой Фукусимой. Особенное влияние данная сеть оказала на архитектуры, использующиеся для компьютерного зрения. В 1989 году Яну Лекуну удалось использовать алгоритм обратного распространения ошибки для обучения глубоких нейросетей для решения задачи распознавания рукописных ZIP-кодов[3]. Хотя алгоритм работал, на его обучение потребовалось 3 дня, что существенно ограничевало применимость данного метода. Из-за низкой скорости обучения нейронные сети в 1990-х годах уступили место методу опорных векторов.

Популярность глубокое обучение приобрело в середине 2000-х годов. Этому способствовали несколько факторов:

- появились более мощные компьютеры, способные обучать большие нейронные сети;

- появились новые датасеты, достаточные по объёму, чтобы обучение больших сетей имело смысл;

- произошли существенные продвижения в теории искусственных нейронных сетей. В появившихся статьях авторы показали, что можно эффективно предобучать многослойную нейронную сеть, если обучать каждый слой отдельно при помощи ограниченной машины Больцмана, а затем дообучать при помощи метода обратного распространения ошибки;

- технология привлекли внимание крупных медиа, — первым из мировых СМИ об этом написал The New York Times.

Определение

Глубокое обучение — это класс алгоритмов машинного обучения, который:

- использует многослойную систему нелинейных фильтров для извлечения признаков с преобразованиями. Каждый последующий слой получает на входе выходные данные предыдущего слоя.

- может сочетать алгоритмы обучения с учителем (пример — классификация) и без учителя (пример — анализ образца).

- формирует в процессе обучения слои выявления признаков на нескольких уровнях представлений, которые соответствуют различным уровням абстракции; при этом признаки организованы иерархически - признаки более высокого уровня являются производными от признаков более низкого уровня.

Нейронные сети

- Искусственные нейронные сети (англ. artificial neural networks (ANN))[4]

- Глубокие нейронные сети (англ. deep neural network (DNN))[5]

Применения

- Распознавание речи

- Компьютерное зрение[6]

- Обработка визуальных изображений

- Обработка естественного языка

- Обнаружение новых лекарственных препаратов

- Рекомендательные системы

- Предсказание генномных онтологий в биоинформатике

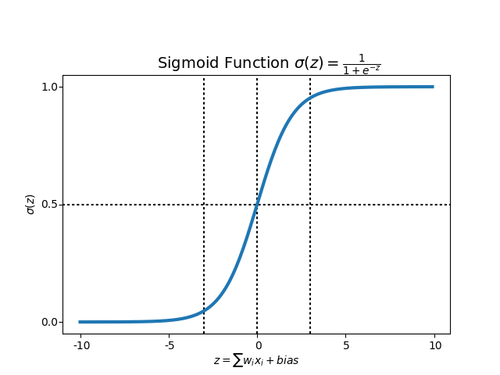

Sigmoid function

У ступенчатых функций есть определенное количество ограничений, связанных с ее линейностью. Если функция активации является линейной, то независимо от количества складываемых скрытых слоев в нейронной сети, конечный результат по-прежнему будет являеться линейной комбинацией исходных входных данных. Эта линейность означает, что она не может реально охватить сложность нелинейных задач, таких как оператор XOR или различные паттерны, разделенные кривыми или кругами. Другой проблемой является то, что перцептрон с ступенчатой функцией не очень «стабилен», то есть может перейти из состояния 0 в 1 и из 0 в 1 при небольших изменениях в любом из весов входного слоя.

Для того, чтобы избежать данных проблем, в нейронных сетях используется sigmoid функция в качестве активационной.

Функция sigmoid, в отличие от ступенчатой функции, вводит нелинейность в выбранную модель нейронной сети. Нелинейность означает, что выход, получаемых из нейрона, который является произведением некоторых входов и весов плюс смещение, а затем помещаемый в sigmoid функцию, не может быть представлен линейной комбинацией входов .

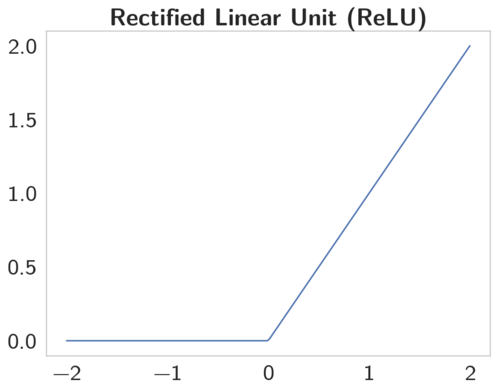

Rectified Linear Units (ReLU)

Несмотря на множество сильных сторон sigmoid функции, у нее есть значительные недостатки. Производная такой функции крайне мала во всех точках, кроме сравнительно небольшого промежутка. Это сильно усложняет процесс улучшения весов с помощью градиентного спуска. Эта проблема усугубляется в случае, если модель содержит больше слоев. Данная проблема называется проблемой исчезающего градиента.[7]

Функция ReLU имеет производную равную 0 для всех отрицательных значениях и 1 для положительных. Таким образом, когда обучение происходит на датасетах разумного размера, обычно находятся точки данных, дающие положительные значения для любого выбранного узла. Таким образом, средняя производная редко бывает близка к 0, что позволяет продолжать градиентный спуск.

Rectified Linear Unit — это наиболее часто используемая активационная функция при глубоком обучении. Данная функция возвращает 0, если принимает отрицательный вход, в случае же положительного входа, функция возвращает само число. Таким образом функция может быть записана как .

Функция ReLU отлично работает в большинстве приложений, в результате чего она получила широкое распространение. Данная функция позволяет правильно учитывать нелинейности и взаимодействия.

Программы для глубокого обучения

- TensorFlow[8]

- Microsoft Cognitive Toolkit[9]

- Wolfram Mathematica[10]

- Keras[11]

- Deeplearning4j[12]

- Caffe[13]

Сопоставление фреймворков, библиотек и отдельных программ для глубокого обучения[14].

См. также

- Нейронные сети, перцептрон[на 06.12.18 не создан]

- Сверточные нейронные сети[на 06.12.18 не создан]

- Рекуррентные нейронные сети [на 06.12.18 не создан]

- Обучение с подкреплением [на 06.12.18 не создан]

Примечания

- ↑ Learning While Searching in Constraint-Satisfaction-Problems

- ↑ Neocognitron, Wikipedia

- ↑ Backpropagation Applied to Handwritten Zip Code Recognition

- ↑ Artificial neural network, Wikipedia

- ↑ Deep neural networks , Wikipedia

- ↑ Задача нахождения объектов на изображении[на 06.12.18 не создан]

- ↑ Vanishing gradient problem, Wikipedia

- ↑ TensorFlow, Wikipedia

- ↑ Microsoft Cognitive Toolkit, Wikipedia

- ↑ Wolfram Mathematica, Wikipedia

- ↑ Keras, Wikipedia

- ↑ Deeplearning4j, Wikipedia

- ↑ Caffe, Wikipedia

- ↑ Comparison of deep learning software, Wikipedia