Векторное представление слов

Статья находится в разработке

Векторное представление слов - набор методов обработки естественного языка (NLP) для представления слов из словаря размера |V| (300k, 1M) в линейное пространство меньшей размерности d (100, 1000).

TODO: tf-idf cosinus measure bag-of-words (BOW) continuous BOW N-gram skip-gram word2vec with skip-grams learning

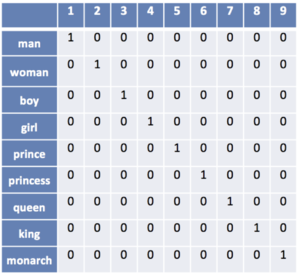

One-hot encoding

Наиболее простой способ представления слов в виде векторов. Пусть число различных слов равно |V|. Сопоставим слову номер i вектор длины |V|, в котором i-тая координата равна 1, а все остальные - нули.

Методы построения пространства слов

Существует несколько способов построения пространства векторов для слов.

word2vec (Google, 2013) использует нейронные сети. GloVe (Standford), обучается на матрице совместной встречаемости. fastText[1](Facebook, 2015) усовершенствование word2vec

См. также

Примечания

Источники информации

- [1] — fastText by Facebook