Автоматы в современном мире — различия между версиями

Ponomarev (обсуждение | вклад) (→См. также) |

м (rollbackEdits.php mass rollback) |

||

| (не показано 9 промежуточных версий 3 участников) | |||

| Строка 17: | Строка 17: | ||

'''state''' out1 | '''state''' out1 | ||

'''int''' lastlist | '''int''' lastlist | ||

| − | Каждый <tex>\mathrm{state}</tex> представляет один из фрагментов НКА, зависящий от символа c. | + | Каждый <tex>\mathrm{state}</tex> представляет один из фрагментов НКА, зависящий от символа <tex>c</tex>. |

Данная реализация будет поддерживать постфиксную нотацию регулярного выражения. Допустим у нас есть функция <tex>\mathrm{re2post}</tex>, которая переписывает инфиксную форму регулярного выражения <tex>``a(bb)+a"</tex> в эквивалентную постфиксную вида <tex>``abb.+.a."</tex> (<tex>.</tex> используется в качестве разделителя). По мере сканирования постфиксного выражения, будем поддерживать стек вычисленных НКА фрагментов. Символы добавляют новый НКА фрагмент в стек, а операторы вынимают фрагменты и добавляют новые. Каждый фрагмент определяется стартовым состояние и исходящей стрелкой: | Данная реализация будет поддерживать постфиксную нотацию регулярного выражения. Допустим у нас есть функция <tex>\mathrm{re2post}</tex>, которая переписывает инфиксную форму регулярного выражения <tex>``a(bb)+a"</tex> в эквивалентную постфиксную вида <tex>``abb.+.a."</tex> (<tex>.</tex> используется в качестве разделителя). По мере сканирования постфиксного выражения, будем поддерживать стек вычисленных НКА фрагментов. Символы добавляют новый НКА фрагмент в стек, а операторы вынимают фрагменты и добавляют новые. Каждый фрагмент определяется стартовым состояние и исходящей стрелкой: | ||

'''struct''' frag: | '''struct''' frag: | ||

| Строка 212: | Строка 212: | ||

== Несколько полезных оптимизаций на примере Haskell == | == Несколько полезных оптимизаций на примере Haskell == | ||

| − | [https://begriffs.com/posts/2016-06-27-fast-haskell-regexes.html Gabriel Gonzalez] реализовал алгоритм Томпсона на языке Haskell. В первоначальном варианте это алгоритм получился в 480 раз медленнее, чем grep на том же тесте, чтобы улучшить результат он предпринял ряд оптимизаций: | + | |

| − | * вместо Set Int использовал Integer, а также использовал битовые операции, в результате производительность выросла в 5 раз | + | Gabriel Gonzalez <ref>[https://begriffs.com/posts/2016-06-27-fast-haskell-regexes.html Gabriel Gonzalez {{---}} Regex in Haskell]</ref> реализовал алгоритм Томпсона на языке Haskell. В первоначальном варианте это алгоритм получился в <tex>480</tex> раз медленнее, чем grep на том же тесте, чтобы улучшить результат он предпринял ряд оптимизаций: |

| − | * использовал Word вместо Integer, ещё в 8 раз быстрее | + | * вместо <tex>\mathrm{Set Int}</tex> использовал <tex>\mathrm{Integer}</tex>, а также использовал битовые операции, в результате производительность выросла в <tex>5</tex> раз |

| − | * а также использовал ByteString оптимизации, что увеличило производительность ещё 3 раза. | + | * использовал <tex>\mathrm{Word}</tex> вместо <tex>\mathrm{Integer}</tex>, ещё в <tex>8</tex> раз быстрее |

| − | В итоге его реализация оказалась всего в 4 раза медленнее grep. Но это не предел, у него получилось реализовать [https://www.microsoft.com/en-us/research/wp-content/uploads/2016/02/asplos302-mytkowicz.pdf | + | * а также использовал <tex>\mathrm{ByteString}</tex> оптимизации, что увеличило производительность ещё <tex>3</tex> раза. |

| + | В итоге его реализация оказалась всего в <tex>4</tex> раза медленнее grep. Но это не предел, у него получилось реализовать параллельный конечный автомат<ref>[https://www.microsoft.com/en-us/research/wp-content/uploads/2016/02/asplos302-mytkowicz.pdf Data-Parallel Finite-State Machines]</ref> и сделать свою реализацию в <tex>1.5</tex> раза быстрее, чем grep. | ||

== ReDoS (regular expression denial of service) == | == ReDoS (regular expression denial of service) == | ||

| Строка 230: | Строка 231: | ||

Все эти выражения чувствительны к входной строке <tex>aaaaaaaaaaaaaaaaaaaaaaaaaa</tex>. | Все эти выражения чувствительны к входной строке <tex>aaaaaaaaaaaaaaaaaaaaaaaaaa</tex>. | ||

Также вредоносные регулярные выражения были обнаружены в онлайн репозиториях. | Также вредоносные регулярные выражения были обнаружены в онлайн репозиториях. | ||

| − | # [http://regexlib.com/REDetails.aspx?regexp_id=1757 | + | # RegExLib, email validation <ref>[http://regexlib.com/REDetails.aspx?regexp_id=1757 RegEx for email validation]</ref> {{---}} '''выделенная''' часть является вредоносной<br /><code>^([a-zA-Z0-9])'''(([\-.]|[_]+)?([a-zA-Z0-9]+))*'''(@){1}[a-z0-9]+[.]{1}(([a-z]{2,3})|([a-z]{2,3}[.]{1}[a-z]{2,3}))$</code> |

| − | # [http://www.owasp.org/index.php/OWASP_Validation_Regex_Repository OWASP Validation Regex Repository], Java Classname - '''выделенная''' часть является вредоносной<br /><code>^'''(([a-z])+.)+'''[A-Z]([a-z])+$</code> | + | # OWASP Validation Regex Repository <ref>[http://www.owasp.org/index.php/OWASP_Validation_Regex_Repository OWASP Validation Regex Repository]</ref>, Java Classname {{---}} '''выделенная''' часть является вредоносной<br /><code>^'''(([a-z])+.)+'''[A-Z]([a-z])+$</code> |

Эти два примера также чувствительны к входной строке <tex>aaaaaaaaaaaaaaaaaaaaaaaa</tex>. | Эти два примера также чувствительны к входной строке <tex>aaaaaaaaaaaaaaaaaaaaaaaa</tex>. | ||

Текущая версия на 19:37, 4 сентября 2022

Содержание

Реализация регулярных выражений в современных языках

В настоящее время используется несколько различных подходов к реализации регулярных выражений. Всегда можно довольно просто построить НКА. Но после построения есть несколько вариантов:

- Можно конвертировать его в детерминированный конечный автомат.

- Можно идти по каждому из возможных путей, а в случае неудачи возвращаться назад и пробовать другой.

- Можно идти по автомату одновременно по всем возможным состояниям.

- Можно конвертировать НКА в ДКА лениво (на лету).

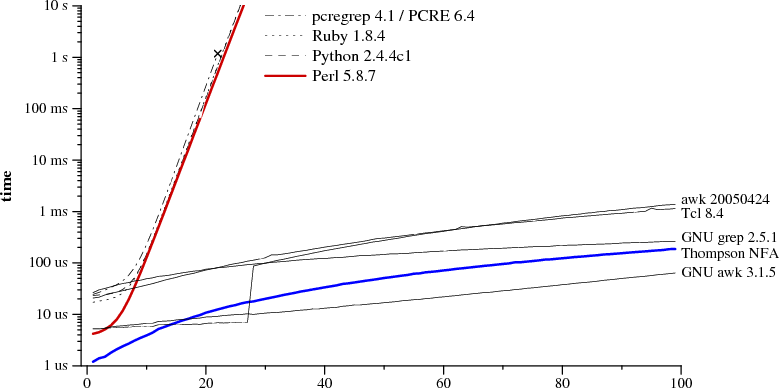

Следующее изображение наглядно показывает, что можно выделить более менее два основных подхода к реализации, давайте же разберемся почему так получилось.

Это произошло из-за того, что обычного функционала регулярных выражений зачастую недостаточно, не хватает выразительной мощности. В языках PCRE, Ruby, Python, Perl добавили поддержку обратных ссылок (англ. back reference). Она позволяет связывать ранее найденное сгруппированное выражение в скобках с числом от до . Например: найдет или , но никак не или . Интересно, что с добавлением обратных ссылок регулярные выражения перестаю относиться к классу регулярных языков. К сожалению, лучшая реализация требует экспоненциального времени работы. Приведенная на графике синяя кривая является реализацией построения НКА по регулярному выражению написанная на C, занимающая чуть меньше, чем строк и описанная в данной статье[1].

Построение НКА

Для построения автомата нам нужно построить отдельно части НКА для каждой части выражения, финальным шагом будет соединение всего автомата вместе. Представим НКА как связанный список структур состояний

struct state:

int c

state out

state out1

int lastlist

Каждый представляет один из фрагментов НКА, зависящий от символа . Данная реализация будет поддерживать постфиксную нотацию регулярного выражения. Допустим у нас есть функция , которая переписывает инфиксную форму регулярного выражения в эквивалентную постфиксную вида ( используется в качестве разделителя). По мере сканирования постфиксного выражения, будем поддерживать стек вычисленных НКА фрагментов. Символы добавляют новый НКА фрагмент в стек, а операторы вынимают фрагменты и добавляют новые. Каждый фрагмент определяется стартовым состояние и исходящей стрелкой:

struct frag:

state start

ptrList out

указывает на стартовое состояние фрагмента, а — лист указателей на указатели, которые ещё не соединены. Некоторые полезные функции для управления списком указателей:

fun list1(state outp): ptrList fun append(ptrList l1, ptrList l2): ptrList fun patch(ptrList l, state s)

создает новый список указателей состоящий из одного указателя . конкатенирует два списка указателей, возвращая результат. связывает повисшую стрелку в списке с состоянием . Используя данные примитивы и стек фрагментов можно реализовать построение НКА.

fun post2nfa(string postfix): state

frag stack[1000], e1, e2, e

state s

for i = 0 to postfix.length - 1

switch(postfix[i])

case '.': // конкатенация

e2 = stack.pop()

e1 = stack.pop()

patch(e1.out, e2.start)

push(frag(e1.start, e2.out))

break

case '|': // альтернатива

e2 = stack.pop()

e1 = stack.pop()

s = state(Split, e1.start, e2.start)

push(frag(s, append(e1.out, e2.out)))

break

case '?': // ноль или один

e = stack.pop()

s = state(Split, e.start, NULL)

push(frag(s, append(e.out, list1(s.out1))))

break

case '*': // ноль или больше

e = stack.pop()

s = state(Split, e.start, NULL)

patch(e.out, s)

push(frag(s, list1(s.out1)))

break

case '+': // один или больше

e = stack.pop()

s = state(Split, e.start, NULL)

patch(e.out, s)

stack.push(frag(e.start, list1(s.out1)))

break

default: // символ

s = state(postfix[i], NULL, NULL)

push(frag(s, list1(s.out))

break

e = stack.pop()

patch(e.out, matchState)

return e.start

Теперь когда мы построили НКА, нужно научиться ходить по нему. Будем сохранять посещенные состояния в массиве.

struct List:

state s

int n

Обход будет использовать два списка: набор состояний, в которых уже находится, и набор состояний в которых НКА будет после обработки текущего символа. Цикл исполнения инициализирует стартовым состоянием и пошагово проходит.

fun match(state start, string s): int

List cList, nList, t

cList = startList(start, l1)

nList = l2

for i = 0 to s.length - 1

step(cList, s[i], nList)

t = cList

cList = nList

nList = t

return isMatch(cList)

Чтобы избежать преаллокаций на каждой итерации цикла, использует два преаллоцированных списка и как и , и меняет их на каждом шаге.

Если список последних вершин содержит терминальную вершину, то строка распознана.

fun isMatch(List l): int

int i

for i = 0 to l.n - 1

if (l.s[i] == matchState)

return 1

return 0

добавляет состояние в список, но только если их ещё не было в нем.

fun addState(List l, state s):

if (s == NULL || s.lastlist == listid)

return

s.lastlist = listid

if(s.c == split)

addState(l, s.out)

addState(l, s.out1)

return

l.s[l.n++] = s

создает начальный список состояний и добавляет туда стартовое состояние.

fun startList(state s, List l): List

listid++

l.n = 0

addState(l, s)

return l

вычисляет по символу, использую список текущих состояний следующий список .

fun step(List client, int c, List nList)

int i

state s

listid++

nList.n = 0

for i = 0 to cList.n - 1

s = cList.s[i]

if (s.c == c)

addState(nList, s.out)

Дополнительные возможности регулярных выражений

Символьные классы

Набор символов в квадратных скобках именуется символьным классом и позволяет указать интерпретатору регулярных выражений, что на данном месте в строке может стоять один из перечисленных символов. Можно указывать диапазоны , а также существуют дополнительные символьные классы .

Квантификация.

Позволяет установить точное соответствие повторов равное числу — — не меньше чем , и не больше чем . — и больше. Можно найти эквиваленты символам . С помощью символов

Позиция внутри строки

Следующие символы позволяют с позиционировать регулярное выражение относительно элементов текста: начала и конца строки, границ слова.

| Представление | Позиция |

|---|---|

| Начало текста | |

| Конец текста | |

| Граница слова | |

| Предыдущий успешный поиск |

Жадная и ленивая квантификация

В некоторых реализациях квантификаторам в регулярных выражениях соответствует максимально длинная строка из возможных (квантификаторы являются жадными, англ. greedy). Это может оказаться значительной проблемой. Например, часто ожидают, что выражение найдёт в тексте теги HTML. Однако если в тексте есть более одного HTML-тега, то этому выражению соответствует целиком строка, содержащая множество тегов.

| Жадный | Ленивый |

|---|---|

Эту проблему можно решить двумя способами.

Учитывать символы, не соответствующие желаемому образцу ( для вышеописанного случая). Определить квантификатор как нежадный (ленивый, англ. lazy) — большинство реализаций позволяют это сделать, добавив после него знак вопроса.

Ревнивая квантификация (Сверхжадная)

В отличие от обычной (жадной) квантификации, ревнивая (англ. possessive) квантификация не только старается найти максимально длинный вариант, но ещё и не позволяет алгоритму возвращаться к предыдущим шагам поиска для того, чтобы найти возможные соответствия для оставшейся части регулярного выражения.

Использование квантификаторов увеличивает скорость поиска, особенно в тех случаях, когда строка не соответствует регулярному выражению. Кроме того, ревнивые квантификаторы могут быть использованы для исключения нежелательных совпадений.

| Жадный | Ревнивый |

|---|---|

Несколько полезных оптимизаций на примере Haskell

Gabriel Gonzalez [2] реализовал алгоритм Томпсона на языке Haskell. В первоначальном варианте это алгоритм получился в раз медленнее, чем grep на том же тесте, чтобы улучшить результат он предпринял ряд оптимизаций:

- вместо использовал , а также использовал битовые операции, в результате производительность выросла в раз

- использовал вместо , ещё в раз быстрее

- а также использовал оптимизации, что увеличило производительность ещё раза.

В итоге его реализация оказалась всего в раза медленнее grep. Но это не предел, у него получилось реализовать параллельный конечный автомат[3] и сделать свою реализацию в раза быстрее, чем grep.

ReDoS (regular expression denial of service)

Интересно, что злоумышленники научились атаковать системы используя то, что некоторые алгоритмы имеют экспоненциальную сложность. В регулярных выражениях использующих обратную связь есть несколько вариантов:

- использовать повторение для достаточно сложных подвыражений;

- сделать так, чтобы повторяющиеся подвыражения были суффиксами валидного совпадения.

Примеры вредоносных регулярных выражений:

Все эти выражения чувствительны к входной строке . Также вредоносные регулярные выражения были обнаружены в онлайн репозиториях.

- RegExLib, email validation [4] — выделенная часть является вредоносной

^([a-zA-Z0-9])(([\-.]|[_]+)?([a-zA-Z0-9]+))*(@){1}[a-z0-9]+[.]{1}(([a-z]{2,3})|([a-z]{2,3}[.]{1}[a-z]{2,3}))$ - OWASP Validation Regex Repository [5], Java Classname — выделенная часть является вредоносной

^(([a-z])+.)+[A-Z]([a-z])+$

Эти два примера также чувствительны к входной строке .

См. также

- Регулярные языки: два определения и их эквивалентность

- Недетерминированные конечные автоматы

- Детерминированные конечные автоматы

- Построение по НКА эквивалентного ДКА, алгоритм Томпсона