Байесовские сети — различия между версиями

(→Виды вероятностного вывода (англ. Reasoning Patterns)) |

|||

| Строка 27: | Строка 27: | ||

Прямой вывод — определение вероятности события при наблюдаемых причинах. | Прямой вывод — определение вероятности события при наблюдаемых причинах. | ||

| + | |||

Пример: вероятность получения хорошего рекомендательного письма, если известно, что студент обладает низким интеллектом, <math>P(l1 | i0) \approx 0.39</math>, если известно, что курс был лёгким, <math>P(l1 | i0, d0) \approx 0.51 </math>. | Пример: вероятность получения хорошего рекомендательного письма, если известно, что студент обладает низким интеллектом, <math>P(l1 | i0) \approx 0.39</math>, если известно, что курс был лёгким, <math>P(l1 | i0, d0) \approx 0.51 </math>. | ||

| Строка 32: | Строка 33: | ||

Обратный вывод — определение вероятности причины при наблюдаемых следствиях. | Обратный вывод — определение вероятности причины при наблюдаемых следствиях. | ||

| + | |||

Пример: <math> P(d1 | g3), P(i1 | g3) </math>. | Пример: <math> P(d1 | g3), P(i1 | g3) </math>. | ||

| Строка 37: | Строка 39: | ||

Межпричинный вывод — определение вероятности одной из причин наступившего события при условии наступления одной или нескольких других причин этого события. | Межпричинный вывод — определение вероятности одной из причин наступившего события при условии наступления одной или нескольких других причин этого события. | ||

| + | |||

Пример: <math> P(i1 | g3, d1) </math>. | Пример: <math> P(i1 | g3, d1) </math>. | ||

== Источники информации == | == Источники информации == | ||

* Andrew D. Gordon, Thomas A. Henzinger, Aditya V. Nori, and Sriram K. Rajamani. 2014. Probabilistic programming. In Proceedings of the on Future of Software Engineering (FOSE 2014). ACM, New York, NY, USA, 167-181. DOI=10.1145/2593882.2593900 doi.acm.org/10.1145/2593882.2593900 | * Andrew D. Gordon, Thomas A. Henzinger, Aditya V. Nori, and Sriram K. Rajamani. 2014. Probabilistic programming. In Proceedings of the on Future of Software Engineering (FOSE 2014). ACM, New York, NY, USA, 167-181. DOI=10.1145/2593882.2593900 doi.acm.org/10.1145/2593882.2593900 | ||

Версия 13:51, 11 марта 2019

| Определение: |

| Байесовская сеть (англ. Bayesian network) — это направленный ациклический граф , в котором каждой вершине поставлена в соответствие случайная переменная и каждое ребро представляет прямую зависимость от . Пусть , тогда в Байесовской сети каждой вершине графа должно быть сопоставлено распределение условных вероятностей от вершин из . |

Цепное правило для Байесовских сетей: Цепное правило позволяет разложить (факторизовать) совместное распределение в произведение условных распределений.

Пример

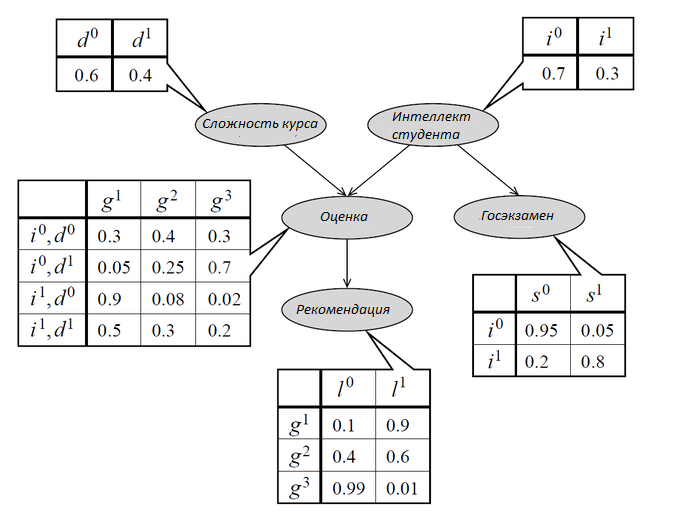

Оценка студента (Grade) зависит от его интеллекта (Intelligence) и сложности курса (Difficulty). Студент просит у преподавателя рекомендательное письмо (Letter), предположим, что преподаватель может написать плохое или хорошее письмо в зависимости от оценки студента. Также студент сдаёт экзамен для поступления в колледж (SAT), результаты экзамена не зависят от письма преподавателя, оценки за его курс и сложности курса. Представление этой модели в Байесовской сети представлено на рисунке ниже.

С помощью цепного правила рассчитаем вероятность того, что умный студент получает B по лёгкому курсу, высокий балл по SAT и плохое рекомендательное письмо:

Байесовская сеть представляет законное распределение:

- Вероятность исхода в Байесовской сети неотрицательна, так как вычисляется как произведение условных вероятностей событий, которые неотрицательны.

- Сумма вероятностей исходов в Байесовской сети равна единице:

Виды вероятностного вывода (англ. Reasoning Patterns)

Прямой вывод, или прогнозирование (англ. Causal Reasoning)

Прямой вывод — определение вероятности события при наблюдаемых причинах.

Пример: вероятность получения хорошего рекомендательного письма, если известно, что студент обладает низким интеллектом, , если известно, что курс был лёгким, .

Обратный вывод, или диагностирование (англ. Evidential Reasoning)

Обратный вывод — определение вероятности причины при наблюдаемых следствиях.

Пример: .

Межпричинный (смешанный) вывод (англ. Intercausal Reasoning)

Межпричинный вывод — определение вероятности одной из причин наступившего события при условии наступления одной или нескольких других причин этого события.

Пример: .

Источники информации

- Andrew D. Gordon, Thomas A. Henzinger, Aditya V. Nori, and Sriram K. Rajamani. 2014. Probabilistic programming. In Proceedings of the on Future of Software Engineering (FOSE 2014). ACM, New York, NY, USA, 167-181. DOI=10.1145/2593882.2593900 doi.acm.org/10.1145/2593882.2593900