Определение

| Определение: |

Корреляция случайных величин: пусть [math]\eta,\xi[/math] — две случайные величины, определённые на одном и том же вероятностном пространстве. Тогда их корреляция определяется следующим образом:

- [math]Corr(\eta,\xi)={Cov(\eta,\xi) \over \sigma_{\eta} \times \sigma_{\xi}}[/math], где [math]\sigma_{\eta}=\sqrt{D(\eta)}[/math] называется среднеквадратичным отклонением и равно квадратному корню из дисперсии, а [math]Cov(\eta,\xi)[/math] - ковариацией случайных величин

|

Вычисление

Заметим, что [math]\sigma_{\xi} = \sqrt{D(\xi)} = E\big((\xi-E(\xi))^2\big)[/math]

- [math]Corr(\eta,\xi)={Cov(\eta,\xi) \over \sigma_{\eta} \times \sigma_{\xi}} = {E\big((\eta-E\eta)(\xi-E\xi)\big) \over {\sqrt{D(\eta)} \times \sqrt{D(\xi)}}} ={E(\xi \times \eta) - E(\xi) \times E(\eta) \over {\sigma_{\eta} \times \sigma_{\xi}}}[/math]

Свойства корреляции

| Утверждение: |

Корреляция симметрична:

- [math]Corr(\eta,\xi) = Corr(\xi,\eta)[/math].

|

| [math]\triangleright[/math] |

- [math]Corr(\eta,\xi) = { E(\eta \times \xi) - E(\eta) \times E(\xi) \over \sqrt{D(\eta)} \times \sqrt{D(\xi)} } = { E(\xi \times \eta) - E(\xi) \times E(\eta) \over \sqrt{D(\xi)} \times \sqrt{D(\eta)} } = Corr(\xi,\eta)[/math]

|

| [math]\triangleleft[/math] |

| Утверждение: |

Корреляция лежит на отрезке [math][-1, 1][/math]: |

| [math]\triangleright[/math] |

|

Для доказательства используем свойства ковариации

[math]Cov^2(\eta, \xi) \le \sigma_\eta ^2\sigma_\xi ^2[/math]

из этого выходит [math] {Cov^2(\eta,\xi)\over(\sigma_\eta ^2\sigma_\xi ^2)} \le 1[/math]

при условии, что знаменатель не обращается в нуль.

[math]Corr^2(\eta,\xi) \le 1[/math]

[math]-1 \le Corr(\eta,\xi) \le 1[/math] |

| [math]\triangleleft[/math] |

| Утверждение: |

Если [math] Corr(\eta, \xi) = \pm 1 [/math], то [math]\eta[/math] и [math]\xi[/math] линейно зависимы |

| [math]\triangleright[/math] |

|

Для доказательства используем доказательство свойства ковариации.

Так как у нас [math] Corr(\eta, \xi) = \pm 1 [/math]

то это означает, что [math]Cov^2(\eta,\xi) = \sigma_\eta ^2\sigma_\xi ^2[/math]

равенство на этом неравенстве [math]\sigma_\xi ^2t^2+2Cov(\eta,\xi)t+\sigma_\eta ^2 \ge 0[/math] выполняется только при условии, что дискриминант равен нулю т.е. имеет один корень [math] t_0 [/math].

Из этого выходит [math] E((\xi-E\xi +t_0 \eta - t_0 E\eta))=E((V + t_0 W)^2) = 0 [/math]

это может произойти только в одном случае, если [math] \xi-E\xi +t_0 \eta - t_0 E\eta = 0[/math];

Ясно, что [math]\eta[/math] и [math]\xi[/math] линейно зависимы. |

| [math]\triangleleft[/math] |

| Утверждение: |

Если [math]\eta[/math] и [math]\xi[/math] линейно зависимы, то [math]Corr(\eta, \xi)= \pm 1 [/math]. |

| [math]\triangleright[/math] |

|

Предположим [math]\xi = k \eta + b[/math].

Следовательно, мы имеем [math]E\xi=kE\eta + b[/math]; и так

[math] Cov(\eta, \xi) = E((\eta - E\eta)(\xi - E\xi))=kE((\eta-E\eta)^2)=k\sigma_\eta ^2 [/math].

Кроме того, по свойствам дисперсии,

[math] \sigma_\xi ^2 = D[\xi] = E((\xi-E\xi)^2)= k^2 E((\eta-E\eta)^2)= k^2 \sigma_\eta ^2 [/math]

Из этого следует

[math]Corr(\eta, \xi)= {Cov(\eta, \xi)\over \sigma_\eta \sigma_\xi}={k\over |k|}[/math],

это равно [math]\pm 1[/math], зависит от знака [math]k[/math]. |

| [math]\triangleleft[/math] |

| Утверждение: |

Если [math]\eta,\xi[/math] независимые случайные величины, то

- [math]Corr(\eta,\xi) = 0[/math].

|

| [math]\triangleright[/math] |

|

Пусть [math]\eta[/math] и [math]\xi[/math] - независимые величины. Тогда [math]E(\eta \times \xi)=E(\eta) \times E(\xi)[/math], где [math]E[/math] - их математическое ожидание. Получаем:

- [math]Corr(\eta, \xi) = {E(\xi) \times E(\eta) - E(\xi) \times E(\eta) \over {E\big((\eta-E(\eta))^2\big) \times E\big((\xi-E(\xi))^2\big)}} = 0[/math]

Но обратное неверно:

Пусть [math]\eta[/math] - случайная величина, распределенная симметрично около 0, а [math]\xi=\eta^2[/math]. [math]Corr(\eta,\xi)=0[/math], но [math]\eta[/math] и [math]\xi[/math] - зависимые величины. |

| [math]\triangleleft[/math] |

Примеры

В общем смысле корреляция - это зависимость между случайными величинами, когда изменение одной влечет изменение распределения другой.

Определение корреляции по диаграмме

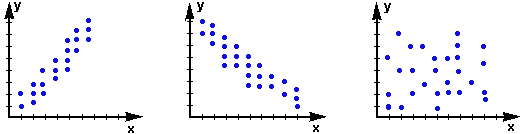

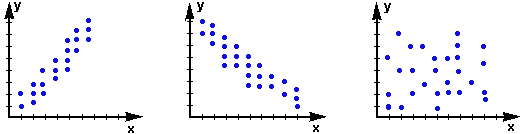

3 диаграммы рассеивания двух случайных величин X и Y

1. Соответственно, на первом графике изображена положительная корреляция, когда увеличение Y ведет к постепенному увеличению X.

2. Второй график отображает отрицательную корреляцию, когда увеличение X воздействует на постепенное уменьшение Y.

3. Третий график показывает, что X и Y связаны слабо, их распределение не зависит от изменения друг друга, поэтому корреляция между ними будет равна 0.

Определение корреляции по таблице

Рассмотрим 2 случайные величины: курс акций нефтедобывающей компании (X) и цены на нефть (Y).

| X |

2003,6 |

2013,2 |

2007,6 |

2007,4 |

2039,9 |

2025 |

2007 |

2017 |

2015,6 |

2011

|

| Y |

108,4 |

107,96 |

108,88 |

110,44 |

110,2 |

108,97 |

109,15 |

108,8 |

111,2 |

110,23

|

Для упрощения вычислений определим X и Y как равновероятные случайные величины. Тогда их математическое ожидание и дисперсию легко посчитать:

[math]E(X) = 2014,73[/math]

[math]E(Y) = 109,42[/math]

[math]D(X) = 104,9361[/math]

[math]D(Y) = 0,959661[/math]

Используя формулу, [math]Corr(\eta,\xi)={E(\xi \times \eta) - E(\xi) \times E(\eta) \over {\sigma_{\eta} \times \sigma_{\xi}}}[/math] определяем, что корреляция между величинами X и Y составляет 0,240935496, т.е. 24%.

Ссылки