Регуляризация — различия между версиями

(→Мотивация) |

(→Мотивация) |

||

| Строка 8: | Строка 8: | ||

В качестве наглядного примера можно рассмотреть линейные регрессионные модели. | В качестве наглядного примера можно рассмотреть линейные регрессионные модели. | ||

| − | Восстановить зависимость для нескольких точек можно пытаться полиномами разной степени. | + | Восстановить зависимость для нескольких точек можно пытаться полиномами разной степени M. |

{|align="center" | {|align="center" | ||

|-valign="top" | |-valign="top" | ||

| − | |[[Файл: | + | |[[Файл:Normal_bias_reg.png|200px|thumb|Рис 1. Норма. M=2]] |

| − | + | |[[Файл:High_variance_reg.png|200px|thumb|Рис 2. Переобучение. M=4]] | |

| − | |[[Файл:High_variance_reg.png|200px|thumb|Рис | ||

|} | |} | ||

| + | |||

| + | Как можно видеть на Рис 1. представлена зависимость, которая хорошо подходит для описания данных, а на Рис. 2 - модель слишком сильно заточилась под обучающую выборку. | ||

| + | |||

| + | Одним из способов бороться с этим эффектом - использовать регуляризацию, т. е. добавлять некоторый штраф за большие значения коэффициентов у модели. Тем самым мы запретим слишком "резкие" изгибы и ограничим возможность подстраивания модели под данные. | ||

==Основные виды регуляризации== | ==Основные виды регуляризации== | ||

Версия 03:21, 19 января 2020

| Определение: |

| Регуляризация (англ. regularization) в статистике, машинном обучении, теории обратных задач — метод добавления некоторых дополнительных ограничений к условию с целью решить неккоректно поставленную задачу или предотвратить переобучение. Чаще всего эта информация имеет вид штрафа за сложность модели. |

Содержание

Мотивация

Как говорилось ранее, регуляризация полезна для борьбы с <переобучением>. Если вы выбрали сложную модель, и при этом у вас недостаточно данных, то легко можно получить итоговую модель, которая хорошо описывает обучающую выборку, но не обобщается на тестовую.

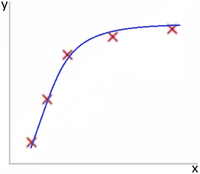

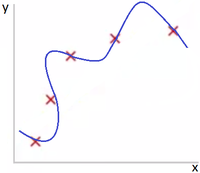

В качестве наглядного примера можно рассмотреть линейные регрессионные модели. Восстановить зависимость для нескольких точек можно пытаться полиномами разной степени M.

Как можно видеть на Рис 1. представлена зависимость, которая хорошо подходит для описания данных, а на Рис. 2 - модель слишком сильно заточилась под обучающую выборку.

Одним из способов бороться с этим эффектом - использовать регуляризацию, т. е. добавлять некоторый штраф за большие значения коэффициентов у модели. Тем самым мы запретим слишком "резкие" изгибы и ограничим возможность подстраивания модели под данные.