Neural Style Transfer — различия между версиями

(→Style Loss) |

(→Content Loss) |

||

| Строка 26: | Строка 26: | ||

Во время каждой итерации все три изображения, передаются через модель VGG16. Значения функции активации нейронов, которые кодируют представление признаков данного изображения на определенных слоях, принимаются как входные данные для этих двух функций потерь. Также стоит добавить: изначально мы случайным образом инициализируем сгенерированное изображение, например, матрицей случайного шума такого же разрешения, как и изображение контента. С каждой итерацией мы изменяем сгенерированное изображение, чтобы минимизировать общую потерю '''L'''. | Во время каждой итерации все три изображения, передаются через модель VGG16. Значения функции активации нейронов, которые кодируют представление признаков данного изображения на определенных слоях, принимаются как входные данные для этих двух функций потерь. Также стоит добавить: изначально мы случайным образом инициализируем сгенерированное изображение, например, матрицей случайного шума такого же разрешения, как и изображение контента. С каждой итерацией мы изменяем сгенерированное изображение, чтобы минимизировать общую потерю '''L'''. | ||

| − | == | + | == Функция потери контента == |

| − | + | Возьмем функциональное представление 7-го сверточного слой VGG16. Чтобы вычислить потерю контента, пропускаем изображение контента и сгенерированное изображение через VGG16 и получаем значения функции активации (выходы) 7-го слоя для обоих этих изображений. После каждого сверточного слоя идет ReLu, поэтому мы будем обозначать выход этого слоя в целом как relu_3_3 (поскольку это выход третьего сверточного слоя третьего набора / блока сверток) (Рисунок 2). Наконец, мы находим L2-норму поэлементного вычитания между этими двумя матрицами значений функции активации следующим образом: | |

| − | + | [[Файл:Image7.jpeg|500px|center]] | |

| − | + | Это поможет сохранить исходный контент в сгенерированном изображении, а также минимизировать разницу в представлении признаков, которое логически фокусируется на разнице между содержимым обоих изображений. | |

== Style Loss == | == Style Loss == | ||

Версия 23:19, 17 апреля 2019

Содержание

Описание алгоритма

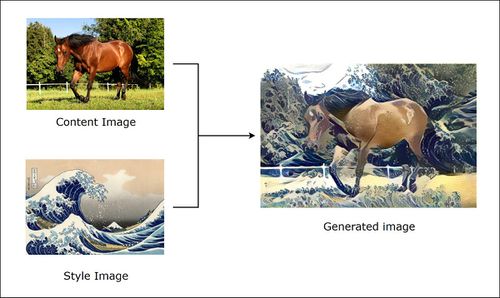

Алгоритм нейронного переноса стиля (англ. Neural Style Transfer), разработанный Леоном Гатисом, Александром Экером и Матиасом Бетге, позволяет получить изображение и воспроизводить его в новом художественном стиле. Алгоритм берет три изображения, входное изображение (англ. input image), изображение контента (англ. content image) и изображение стиля (англ. style image), и изменяет входные данные так, чтобы они соответствовали содержанию изображения контента и художественному стилю изображения стиля. Авторами в качестве модели сверточной нейронной сети предлагается использовать сеть VGG16.

Принцип работы алгоритма

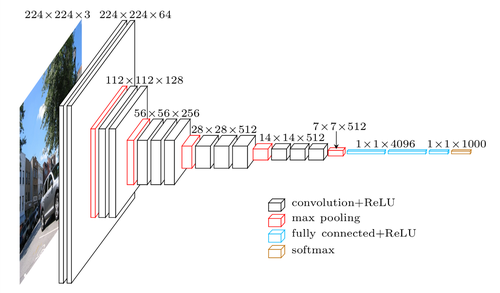

Рассмотрим 1-й сверточный слой (англ. convolution layer) VGG16, который использует ядро 3x3 и обучает 64 карты признаков (англ. feature map) для генерации представления изображения размерности 224x224x64, принимая 3-канальное изображение размером 224x224 в качестве входных данных (Рисунок 3). Во время обучения эти карты признаков научились обнаруживать простые шаблоны, например, такие как прямые линии, окружности или даже не имеющие никакого смысла для человеческого глаза шаблоны, которые тем не менее имеют огромное значение для этой модели. Такое "обнаружение" шаблонов называется обучением представления признаков. Теперь давайте рассмотрим 10-й сверточный слой VGG16, который использует ядро 3x3 с 512 картами признаков для обучения и в итоге генерирует вывод представления изображения размерности 28x28x512. Нейроны 10-го слоя уже могут обнаруживать более сложные шаблоны такие как, например, колесо автомобиля, окно или дерево и т.д.

Собственно вышеперечисленные свойства характерны для любой сверточной нейронной сети, работа которой обычно интерпретируется как переход от конкретных особенностей изображения к более абстрактным деталям, и далее к ещё более абстрактным деталям вплоть до выделения понятий высокого уровня. При этом сеть самонастраивается и вырабатывает необходимую иерархию абстрактных признаков (последовательности карт признаков), фильтруя маловажные детали и выделяя существенное.

Такая природа представления кодирования сама по себе является ключом к передаче стиля, который используется для вычисления функции потерь между сгенерированным изображением относительно изображения контента и изображения стиля. При обучении модели более десяти тысяч изображений на класс модель может генерировать аналогичное представление признаков для множества различных изображений, если они принадлежат к одному классу или имеют схожий контент или стиль.

Следовательно, имеет смысл использовать разницу в значении представления признаков сгенерированного изображения по содержанию и по стилю изображения, чтобы направлять итерации, через которые мы производим само сгенерированное изображение, но как убедиться, что изображение с содержанием C и сгенерированное изображение G похожи по своему содержанию, а не по стилю, в то время как сгенерированное изображение наследует только похожее представление стиля изображения стиля S, а не само изображение стиля в целом. Это решается разделением функции потерь на две части: одна - потеря контента, а другая - потеря стиля.

Функция потерь

В уравнении выше, чтобы получить общую потерю нужно рассчитать потерю содержимого и потерю стиля , а также и - гиперпараметры, которые используются для определения весов для каждого типа потерь, то есть эти параметры можно представить просто как "рычаги" для управления тем, сколько контента / стиля мы хотим наследовать в сгенерированном изображении.

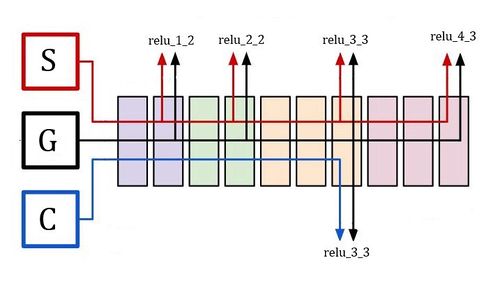

Во время каждой итерации все три изображения, передаются через модель VGG16. Значения функции активации нейронов, которые кодируют представление признаков данного изображения на определенных слоях, принимаются как входные данные для этих двух функций потерь. Также стоит добавить: изначально мы случайным образом инициализируем сгенерированное изображение, например, матрицей случайного шума такого же разрешения, как и изображение контента. С каждой итерацией мы изменяем сгенерированное изображение, чтобы минимизировать общую потерю L.

Функция потери контента

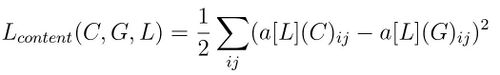

Возьмем функциональное представление 7-го сверточного слой VGG16. Чтобы вычислить потерю контента, пропускаем изображение контента и сгенерированное изображение через VGG16 и получаем значения функции активации (выходы) 7-го слоя для обоих этих изображений. После каждого сверточного слоя идет ReLu, поэтому мы будем обозначать выход этого слоя в целом как relu_3_3 (поскольку это выход третьего сверточного слоя третьего набора / блока сверток) (Рисунок 2). Наконец, мы находим L2-норму поэлементного вычитания между этими двумя матрицами значений функции активации следующим образом:

Это поможет сохранить исходный контент в сгенерированном изображении, а также минимизировать разницу в представлении признаков, которое логически фокусируется на разнице между содержимым обоих изображений.

Style Loss

Теперь давайте посмотрим на потерю стиля, а при расчете потери стиля мы рассмотрим представление характеристик многих слоев свертки от мелких до более глубоких слоев модели. В отличие от потери контента, мы не можем просто найти разницу в единицах активации. Нам нужен способ найти корреляцию между этими активациями по разным каналам одного и того же слоя, и для этого нам нужно нечто, называемое матрицей Грама.

Gram Matrix

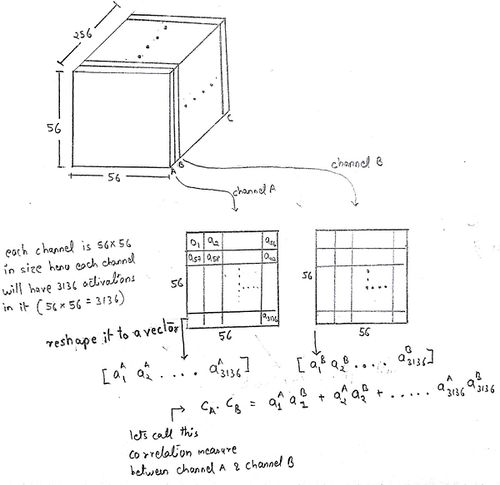

Я попытаюсь создать основу, необходимую для понимания матрицы грамм, на примере. Итак, давайте рассмотрим, как мы передаем наше изображение стиля через vgg16 и получаем значения активации из 7-го уровня, который генерирует матрицу представления объектов размером 56x56x256, которую вы можете использовать на рисунке 2, который описывает архитектуру vgg16. Теперь давайте подробнее рассмотрим этот вывод.

В этом 3-D массиве имеется 256 каналов размером 56x56 каждый. Теперь давайте предположим, что есть канал ‘A’, чьи блоки активации могут активироваться, когда они сталкиваются с разделом изображения, содержащим черные и коричневые полосы, а затем есть канал ‘B’, чьи блоки активации могут активироваться, когда они сталкиваются с чем-то похожим на глазное яблоко

Примечание: здесь активируемые юниты относятся к ним, имеющим значительно большую ценность по сравнению с нулем после прохождения через relu.

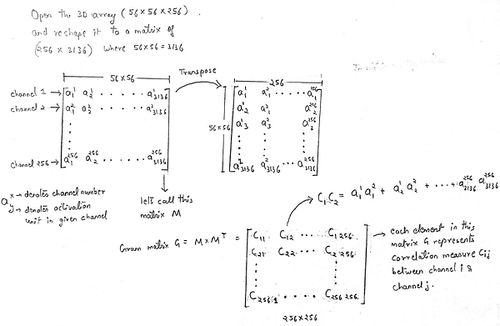

Если оба этих канала ‘A’ & ‘B’ активируются вместе для одного и того же входа, существует высокая вероятность того, что изображение может содержать лицо тигра (поскольку у него было два канала с высокими значениями, которые активируются для глазного яблока и коричневых черных полос) , Теперь, если оба эти канала будут запущены с высокими значениями активации, это означает, что они будут иметь высокую корреляцию по сравнению с корреляцией между каналом ‘A’ & ‘C’, где канал ‘C’ может активироваться, когда он видит ромбовидный шаблон. Таким образом, чтобы получить корреляцию всех этих каналов друг с другом, нам нужно вычислить что-то, называемое граммовой матрицей, мы будем использовать грамм-матрицу для измерения степени корреляции между каналами, которая позже будет служить мерой самого стиля. Теперь вы, возможно, поняли значение грамм-матрицы, но чтобы понять, как мы получаем грамм-матрицу из вышеупомянутого трехмерного массива, рассмотрим изображение, упомянутое ниже.

Теперь, как вы можете видеть, как каждый элемент этой граммовой матрицы содержит меру корреляции всех каналов относительно друг друга. Продвигаясь вперед, как мы используем эту вычисленную матрицу Грамма G для расчета потери стиля. Обозначим грамм-матрицу стилевого изображения слоя L как GM[L](S), а грамм-матрицу сгенерированного изображения того же слоя, что и GM[L](G). Обе матрицы грамм были вычислены из одного и того же слоя, следовательно, с использованием одного и того же числа каналов, что привело к тому, что он стал матрицей размера ch x ch. Теперь, если мы найдем сумму квадратичной разности или L2_norm вычитания элементов этих двух матриц и попытаемся минимизировать это, то это в конечном итоге приведет к минимизации разницы между стилем изображения изображения и сгенерированного изображения. Подумайте об этом, это может занять некоторое время, но когда это произойдет, вы будете загипнотизированы тем, насколько это просто, но эффективно.

В вышеприведенном уравнении N_l представляет номер канала в карте признаков / выходных данных уровня l, а M_l представляет высоту * ширину карты объектов / выходных данных слоя l.

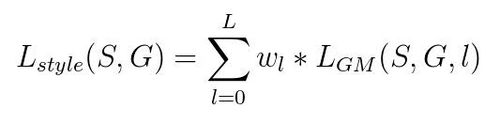

В то время как при вычислении потери стиля мы используем несколько уровней активации, эти сценарии приводят нас к возможности назначать разные весовые коэффициенты для каждой подпотери, предоставляемой разными уровнями. ниже уравнения суммирует то, что я только что сказал, довольно элегантно, но в нашем случае или в большинстве случаев в целом люди дают одинаковый вес для всех слоев.

Пример кода на PyTorch

class ContentLoss(nn.Module):

def __init__(self, target,):

super(ContentLoss, self).__init__()

# we 'detach' the target content from the tree used

# to dynamically compute the gradient: this is a stated value,

# not a variable. Otherwise the forward method of the criterion

# will throw an error.

self.target = target.detach()

def forward(self, input):

self.loss = F.mse_loss(input, self.target)

return input