Корреляция случайных величин — различия между версиями

Kabanov (обсуждение | вклад) (→Свойства корреляции) |

м (rollbackEdits.php mass rollback) |

||

| (не показаны 23 промежуточные версии 6 участников) | |||

| Строка 1: | Строка 1: | ||

| − | |||

{{Определение | {{Определение | ||

|definition= | |definition= | ||

| − | <b> | + | <b>Среднеквадратичным отклонением</b> (англ. ''standart deviation'') <tex>\sigma_{\eta}</tex> называется величина, равная квадратному корню из [[Дисперсия_случайной_величины | дисперсии]] случайной величины <tex>\eta</tex> |

| − | : <tex | + | : <tex>\sigma_{\eta}=\sqrt{D(\eta)}</tex> |

| + | }} | ||

| + | {{Определение | ||

| + | |definition= | ||

| + | Пусть <tex>\eta,\xi</tex> {{---}} две [[Дискретная_случайная_величина | случайные величины]], определённые на одном и том же вероятностном пространстве. Тогда <b> корреляцией случайных величин </b> (англ. correlation) <tex>\eta</tex> и <tex>\xi</tex> называется выражение следующего вида: | ||

| + | : <tex>\mathrm{Corr}(\eta,\xi)=\dfrac{\mathrm{Cov}(\eta,\xi)}{\sigma_{\eta}\sigma_{\xi}}</tex>, где <tex>\mathrm{Cov}(\eta,\xi)</tex> {{---}} [[Ковариация_случайных_величин | ковариация случайных величин]]. | ||

}} | }} | ||

== Вычисление == | == Вычисление == | ||

| − | Заметим, что <tex>\sigma_{\xi} = \sqrt{D(\xi)} = E\big((\xi-E(\xi))^2\big)</tex> - среднеквадратичное отклонение. | + | Заметим, что <tex>\sigma_{\xi} = \sqrt{D(\xi)} = E\big((\xi-E(\xi))^2\big)</tex> {{---}} среднеквадратичное отклонение. |

| − | : <tex | + | : <tex>\mathrm{Corr}(\eta,\xi)=\dfrac{\mathrm{Cov}(\eta,\xi)}{\sigma_{\eta} \sigma_{\xi}} = \dfrac{E\big((\eta-E\eta)(\xi-E\xi)\big)}{{\sqrt{D(\eta)} \sqrt{D(\xi)}}} =\dfrac{E(\xi \eta) - E(\xi) E(\eta)}{{\sigma_{\eta} \sigma_{\xi}}}</tex> |

== Корреляция и взаимосвязь величин == | == Корреляция и взаимосвязь величин == | ||

| Строка 17: | Строка 21: | ||

|statement= | |statement= | ||

Корреляция симметрична: | Корреляция симметрична: | ||

| − | : <tex>Corr(\eta,\xi) = Corr(\xi,\eta)</tex>. | + | : <tex>\mathrm{Corr}(\eta,\xi) = \mathrm{Corr}(\xi,\eta)</tex>. |

|proof= | |proof= | ||

| − | : <tex | + | : <tex>\mathrm{Corr}(\eta,\xi) = \dfrac{ E(\eta \xi) - E(\eta) E(\xi)}{\sqrt{D(\eta)} \sqrt{D(\xi)} } = \dfrac{ E(\xi \eta) - E(\xi) E(\eta)}{\sqrt{D(\xi)} \sqrt{D(\eta)} } = \mathrm{Corr}(\xi,\eta)</tex>. |

}} | }} | ||

{{Утверждение | {{Утверждение | ||

|statement= | |statement= | ||

| − | Корреляция случайной величины с собой равна 1. | + | Корреляция случайной величины с собой равна <tex>1</tex>. |

|proof= | |proof= | ||

| − | : <tex | + | : <tex>\mathrm{Corr}(\eta,\eta) = \dfrac{ E(\eta \eta) - E(\eta) E(\eta)}{\sqrt{D(\eta)} \sqrt{D(\eta)} } = \dfrac{D(\eta)}{D(\eta)} = 1</tex> |

}} | }} | ||

| Строка 33: | Строка 37: | ||

Корреляция лежит на отрезке <tex>[-1, 1]</tex>. | Корреляция лежит на отрезке <tex>[-1, 1]</tex>. | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

}} | }} | ||

| Строка 50: | Строка 43: | ||

{{Утверждение | {{Утверждение | ||

|statement= | |statement= | ||

| − | Если <tex> Corr(\eta, \xi) = \pm 1 </tex>, то <tex>\eta</tex> и <tex>\xi</tex> линейно зависимы. | + | Если <tex> \mathrm{Corr}(\eta, \xi) = \pm 1 </tex>, то <tex>\eta</tex> и <tex>\xi</tex> линейно зависимы. |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

}} | }} | ||

{{Утверждение | {{Утверждение | ||

|statement= | |statement= | ||

| − | Если <tex>\eta</tex> и <tex>\xi</tex> линейно зависимы, то <tex>Corr(\eta, \xi)= \pm 1 | + | Если <tex>\eta</tex> и <tex>\xi</tex> линейно зависимы, то <tex>\mathrm{Corr}(\eta, \xi)= \pm 1 </tex>. |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

}} | }} | ||

{{Утверждение | {{Утверждение | ||

|statement= | |statement= | ||

| − | Если <tex>\eta,\xi</tex> независимые случайные величины, то <tex>Corr(\eta,\xi) = 0</tex>. | + | Если <tex>\eta,\xi</tex> независимые случайные величины, то <tex>\mathrm{Corr}(\eta,\xi) = 0</tex>. |

|proof= | |proof= | ||

| − | Пусть <tex>\eta</tex> и <tex>\xi</tex> - [[Независимые_случайные_величины|независимые величины]]. Тогда <tex>E(\eta | + | Пусть <tex>\eta</tex> и <tex>\xi</tex> {{---}} [[Независимые_случайные_величины|независимые величины]]. Тогда <tex>E(\eta \xi)=E(\eta) E(\xi)</tex>, где <tex>E</tex> {{---}} их [[Математическое_ожидание_случайной_величины|математическое ожидание]]. Получаем: |

| − | : <tex | + | : <tex>\mathrm{Corr}(\eta, \xi) = \dfrac{E(\xi) E(\eta) - E(\xi) E(\eta)}{{E\big((\eta-E(\eta))^2\big) E\big((\xi-E(\xi))^2\big)}} = 0</tex> |

<b>Но обратное неверно:</b> | <b>Но обратное неверно:</b> | ||

| − | Пусть <tex>\eta</tex> - [[Дискретная_случайная_величина|случайная величина]], распределенная симметрично около 0, а <tex>\xi=\eta^2</tex>. <tex>Corr(\eta,\xi)=0</tex>, но <tex>\eta</tex> и <tex>\xi</tex> - зависимые величины. | + | Пусть <tex>\eta</tex> {{---}} [[Дискретная_случайная_величина|случайная величина]], распределенная симметрично около <tex>0</tex>, а <tex>\xi=\eta^2</tex>. <tex>\mathrm{Corr}(\eta,\xi)=0</tex>, но <tex>\eta</tex> и <tex>\xi</tex> {{---}} зависимые величины. |

}} | }} | ||

== Примеры == | == Примеры == | ||

| − | В общем смысле корреляция - это зависимость между случайными величинами, когда изменение одной влечет изменение распределения другой. | + | В общем смысле корреляция {{---}} это зависимость между случайными величинами, когда изменение одной влечет изменение распределения другой. |

=== Определение корреляции по диаграмме === | === Определение корреляции по диаграмме === | ||

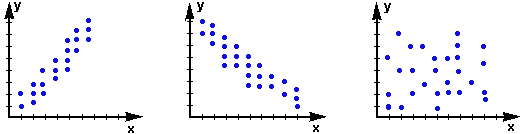

| − | [[Файл:Пример_графиков_корреляции.png|600px|thumb|right|3 диаграммы рассеивания двух случайных величин X и Y]] | + | [[Файл:Пример_графиков_корреляции.png|600px|thumb|right|3 диаграммы рассеивания двух случайных величин <tex>X</tex> и <tex>Y</tex>]] |

| − | + | #Соответственно, на '''первом графике''' изображена '''положительная корреляция''', когда увеличение <tex>Y</tex> ведет к постепенному увеличению <tex>X</tex>. | |

| − | + | #'''Второй график''' отображает '''отрицательную корреляцию''', когда увеличение <tex>X</tex> воздействует на постепенное уменьшение <tex>Y</tex>. | |

| − | + | #'''Третий график''' показывает, что <tex>X</tex> и <tex>Y</tex> связаны слабо, их распределение не зависит от изменения друг друга, поэтому корреляция между ними будет '''равна <tex>0</tex>'''. | |

| − | |||

| − | |||

=== Определение корреляции по таблице === | === Определение корреляции по таблице === | ||

| − | Рассмотрим 2 случайные величины: курс акций нефтедобывающей компании (X) и цены на нефть (Y). | + | Рассмотрим <tex>2</tex> случайные величины: курс акций нефтедобывающей компании (<tex>X</tex>) и цены на нефть (<tex>Y</tex>). |

| − | {| | + | {| class="wikitable" |

|- | |- | ||

| − | ! X | | + | ! X |

| + | | <tex>2003,6</tex> || <tex>2013,2</tex> || <tex>2007,6</tex> || <tex>2007,4</tex> || <tex>2039,9</tex> || <tex>2025</tex> || <tex>2007</tex> || <tex>2017</tex> || <tex>2015,6</tex> || <tex>2011</tex> | ||

|- | |- | ||

| − | ! Y | + | ! Y |

| + | | <tex>108,4</tex> || <tex>107,96</tex> || <tex>108,88</tex> || <tex>110,44</tex> || <tex>110,2</tex> || <tex>108,97</tex> || <tex>109,15</tex> || <tex>108,8</tex> || <tex>111,2</tex> || <tex>110,23</tex> | ||

|- | |- | ||

|} | |} | ||

| − | Для упрощения вычислений определим X и Y как равновероятные случайные величины. Тогда их математическое ожидание и дисперсию легко посчитать: | + | Для упрощения вычислений определим <tex>X</tex> и <tex>Y</tex> как равновероятные случайные величины. Тогда их математическое ожидание и дисперсию легко посчитать: |

<tex>E(X) = 2014,73</tex> | <tex>E(X) = 2014,73</tex> | ||

| Строка 128: | Строка 96: | ||

<tex>D(Y) = 0,959661</tex> | <tex>D(Y) = 0,959661</tex> | ||

| − | Используя формулу, <tex | + | Используя формулу, <tex>\mathrm{Corr}(\eta,\xi)=\dfrac{E(\xi \eta) - E(\xi)E(\eta)}{{\sigma_{\eta} \sigma_{\xi}}}</tex> определяем, что корреляция между величинами <tex>X</tex> и <tex>Y</tex> составляет <tex>0,240935496</tex>, то есть <tex>24\%</tex>. |

| + | |||

| + | == См. также == | ||

| + | *[[Дисперсия случайной величины|Дисперсия случайной величины]] | ||

| + | *[[Ковариация случайных величин|Ковариация случайных величин]] | ||

| − | == | + | == Источники информации == |

* [http://ru.wikipedia.org/wiki/%D0%9A%D0%BE%D1%80%D1%80%D0%B5%D0%BB%D1%8F%D1%86%D0%B8%D1%8F Википедия {{---}} Корреляция] | * [http://ru.wikipedia.org/wiki/%D0%9A%D0%BE%D1%80%D1%80%D0%B5%D0%BB%D1%8F%D1%86%D0%B8%D1%8F Википедия {{---}} Корреляция] | ||

* [http://en.wikipedia.org/wiki/Correlation_and_dependence Wikipedia {{---}} Correlation and dependence] | * [http://en.wikipedia.org/wiki/Correlation_and_dependence Wikipedia {{---}} Correlation and dependence] | ||

Текущая версия на 19:42, 4 сентября 2022

| Определение: |

| Среднеквадратичным отклонением (англ. standart deviation) называется величина, равная квадратному корню из дисперсии случайной величины

|

| Определение: |

Пусть — две случайные величины, определённые на одном и том же вероятностном пространстве. Тогда корреляцией случайных величин (англ. correlation) и называется выражение следующего вида:

|

Содержание

Вычисление

Заметим, что — среднеквадратичное отклонение.

Корреляция и взаимосвязь величин

Значительная корреляция между случайными величинами всегда означает, что присутствует некая взаимосвязь между значениями конкретной выборки, но при другой выборке связь вполне может отсутствовать. Поэтому при нахождении взаимосвязи не нужно делать поспешных выводов о причинно-следственном характере величин, а следует рассмотреть наиболее полную выборку, чтобы делать какие-либо выводы. Коэффициенты корреляции устанавливают лишь статистические взаимосвязи, но не более того.

Свойства корреляции

| Утверждение: |

Корреляция симметрична:

|

|

| Утверждение: |

Корреляция случайной величины с собой равна . |

|

|

| Утверждение: |

Корреляция лежит на отрезке . |

| Утверждение: |

Если , то и линейно зависимы. |

| Утверждение: |

Если и линейно зависимы, то . |

| Утверждение: |

Если независимые случайные величины, то . |

|

Пусть и — независимые величины. Тогда , где — их математическое ожидание. Получаем: Но обратное неверно: Пусть — случайная величина, распределенная симметрично около , а . , но и — зависимые величины. |

Примеры

В общем смысле корреляция — это зависимость между случайными величинами, когда изменение одной влечет изменение распределения другой.

Определение корреляции по диаграмме

- Соответственно, на первом графике изображена положительная корреляция, когда увеличение ведет к постепенному увеличению .

- Второй график отображает отрицательную корреляцию, когда увеличение воздействует на постепенное уменьшение .

- Третий график показывает, что и связаны слабо, их распределение не зависит от изменения друг друга, поэтому корреляция между ними будет равна .

Определение корреляции по таблице

Рассмотрим случайные величины: курс акций нефтедобывающей компании () и цены на нефть ().

| X | ||||||||||

|---|---|---|---|---|---|---|---|---|---|---|

| Y |

Для упрощения вычислений определим и как равновероятные случайные величины. Тогда их математическое ожидание и дисперсию легко посчитать:

Используя формулу, определяем, что корреляция между величинами и составляет , то есть .