Алгоритмы во внешней памяти. Базовые конструкции — различия между версиями

Mervap (обсуждение | вклад) |

м (rollbackEdits.php mass rollback) |

||

| (не показано 19 промежуточных версий 3 участников) | |||

| Строка 1: | Строка 1: | ||

== Модель вычислений во внешней памяти == | == Модель вычислений во внешней памяти == | ||

| − | Обычно оценка сложности рассматриваемых алгоритмов происходит в модели под названием ''RAM-машина''. Это означает, что у нас есть оперативная память, из которой мы можем читать и писать произвольную ячейку памяти за время элементарной операции. Таким образом время вычислительных операций и операций с памятью | + | Обычно оценка сложности рассматриваемых алгоритмов происходит в модели под названием ''RAM-машина''<ref>[[wikipedia:Random-access_machine |Wikipedia {{---}} Random-access machine]]</ref>. Это означает, что у нас есть оперативная память, из которой мы можем читать и писать произвольную ячейку памяти за время элементарной операции. Таким образом время вычислительных операций и операций с памятью приравнивается, что сильно упрощает анализ. |

| − | Но в таком случае размер данных, с которыми мы работаем, должен помещаться в оперативную память. Предположим, что ее размер порядка <tex>10-100</tex> GB, а обработать | + | Но в таком случае размер данных, с которыми мы работаем, должен помещаться в оперативную память. Предположим, что ее размер порядка <tex>10-100</tex> GB, а обработать нужно порядка <tex>10</tex> TB информации. Очевидно, что необходимо использовать какую-то внешнюю память, например {{---}} жесткий диск. Хотя диски существенно дешевле |

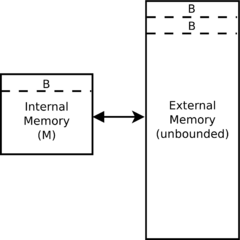

[[Файл:External memory.png|240px|thumb|Оперативная память слева вмещает <tex>\dfrac{M}{B}</tex> блоков размера <tex>B</tex>. Внешняя память справа неограниченна.]] | [[Файл:External memory.png|240px|thumb|Оперативная память слева вмещает <tex>\dfrac{M}{B}</tex> блоков размера <tex>B</tex>. Внешняя память справа неограниченна.]] | ||

| − | оперативной памяти и имеют высокую емкость, они гораздо медленнее | + | оперативной памяти и имеют высокую емкость, они гораздо медленнее из-за механического построения считывания. Для сравнения, время обращения к оперативной памяти порядка <tex>100</tex> ns, а к HDD {{---}} порядка <tex>10</tex> ms (<tex>10^{-7}</tex> s и <tex>10^{-2}</tex> s). Однако, основное время тратится на позиционирование головки жесткого диска, из-за чего разрыв в скорости последовательного чтения не такой большой. Из оперативной памяти можно читать со скоростью порядка <tex>10</tex> GB/s, с HDD {{---}} порядка <tex>100</tex> MB/s. |

| − | Из-за описанного выше, для оценки сложности алгоритмов во внешней памяти была предложена другая модель. Модель | + | Из-за описанного выше, для оценки сложности алгоритмов во внешней памяти была предложена другая модель. Модель гласит следующее: существует какая-то внешняя память и процессор со своей внутренней памятью. Внутренняя память ограничена и имеет размер порядка <tex>M</tex> машинных слов. Внешняя память считается безграничной в рамках рассматриваемой задачи, то есть имеет размер хотя бы порядка <tex>N</tex> машинных слов, где <tex>N</tex> {{---}} размер задачи. Чтение и запись из внешней памяти происходит блоками последовательных данных размера <tex>B</tex> машинных слов. В качестве меры сложности принимается количество операций ввода-вывода, которые выполняет алгоритм, где одна операция ввода-вывода это либо чтение из внешней памяти одного блока размера <tex>B</tex>, либо запись. |

| − | У данной модели есть один существенный недостаток | + | У данной модели есть один существенный недостаток: мы никак не учитываем время, которое тратится на вычисления, а считаем только обращения к диску. Из-за этого многие задачи в данной модели решаются быстрее, чем в модели с ''RAM-машиной''. Например, прочитав какой-то блок, далее мы имеем право произвести экспоненциальный по сложности перебор, и это никак не будет учитываться. Поэтому нужно иметь в виду, что данная модель стремится эффективно использовать жесткий диск, а не балансировать между использованием процессора и жесткого диска. |

== Размер блока == | == Размер блока == | ||

| − | Так как время позиционирования головки внешнего диска весьма непредсказуемо, то необходимо взять размер блока таким, чтобы время чтения самих данных было гораздо больше, чем время позиционирования к этим данным. То есть должно выполняться <tex>seek\_time \leqslant read\_time</tex>. Если <tex>read\_time = 100</tex> MB/s, то <tex>B \geqslant 1</tex> MB. На практике, размер блока нужно брать больше чем <tex>1</tex> MB (около <tex>8-16</tex> MB), так как тогда время позиционирования станет существенно меньше времени чтения. | + | Так как время позиционирования головки внешнего диска весьма непредсказуемо, то необходимо взять размер блока таким, чтобы время чтения самих данных было гораздо больше, чем время позиционирования к этим данным. То есть должно выполняться <tex>seek\_time \leqslant read\_time</tex>. Если <tex>read\_time = 100</tex> MB/s, <tex>seek\_time = 10</tex> ms, то <tex>B \geqslant 1</tex> MB. На практике, размер блока нужно брать больше чем <tex>1</tex> MB (около <tex>8-16</tex> MB), так как тогда время позиционирования станет существенно меньше времени чтения. |

| − | == | + | == Базовые задачи == |

=== Scan === | === Scan === | ||

| − | + | На диске записаны <tex>N</tex> чисел, нужно найти их сумму (например, по какому-нибудь модулю). Очевидно, что эта задача равносильна просто считыванию с диска. Сложность линейного сканирования данных с диска {{---}} <tex>\left\lceil\dfrac{N}{B}\right\rceil = Scan(N)</tex>. Важно заметить, что из-за округления, в общем случае <tex>\sum\limits_{i = 1}^{k}Scan(N_i) \neq Scan\left(\sum\limits_{i = 1}^{k}N_i\right)</tex>. | |

=== Слияние упорядоченных последовательностей === | === Слияние упорядоченных последовательностей === | ||

| + | Пусть имеется две упорядоченные последовательности размера <tex>N_1</tex> и <tex>N_2</tex> соответственно. Чтобы их слить, достаточно завести во внутренней памяти <tex>3</tex> блока. В первые <tex>2</tex> мы будем читать сами последовательности, а в третий {{---}} записывать результат слияния, используя [[Сортировка_слиянием#Слияние_двух_массивов | стандартный алгоритм]] с <tex>2</tex> указателями. Как только какой-то из указателей дошел до конца блока, необходимо считывать следующий, а когда буфер с результатом слияния заполнился {{---}} необходимо записывать его во внешнюю память и очищать. Сложность алгоритма {{---}} <tex>\mathcal{O}(Scan(N_1 + N_2))</tex> | ||

| − | + | === Сортировка === | |

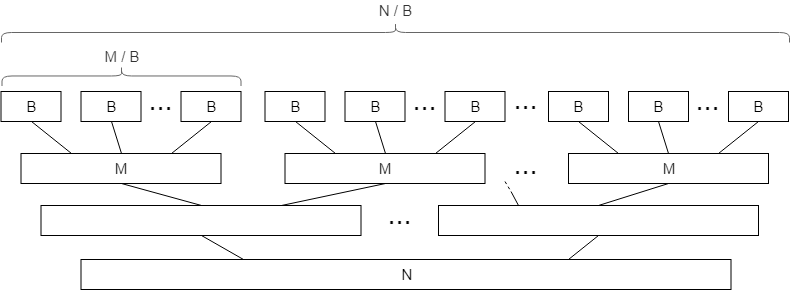

| + | Поскольку мы легко умеем выполнять слияние упорядоченных последовательностей, логичным шагом будет рассмотреть сортировку во внешней памяти. Рассмотрим некоторую модификацию алгоритма [[Сортировка слиянием|Merge sort]]. В стандартном алгоритме все элементы разбиваются на пары, после чего сливаются в упорядоченные последовательности длины <tex>2</tex>, те в свою очередь сливаются в последовательности длины <tex>4</tex> и так далее (для простоты описания будем считать, что <tex>N</tex> и <tex>B</tex> это степени двойки). Во внешней памяти не выгодно начинать с последовательностей длины <tex>1</tex>, так как чтение происходит блоками длины <tex>B</tex>. Вместо этого можно целиком считать блок и отсортировать его во внутренней памяти. Тогда количество листьев в дереве сортировки будет не <tex>N</tex>, а <tex>\dfrac{N}{B}</tex>. Помимо этого, гораздо выгоднее сливать больше чем <tex>2</tex> списка за раз, чтобы уменьшить высоту дерева сортировки. Так как оперативная память размера <tex>M</tex>, то можно сливать сразу <tex>\dfrac{M}{B}</tex> списков. Итого, на каждом уровне дерева сортировки мы выполняем <tex>\mathcal{O}\left(\dfrac{N}{B}\right)</tex> операций и итоговая сложность {{---}} <tex>\mathcal{O}\left(\dfrac{N}{B}\log_{\frac{M}{B}}\dfrac{N}{B}\right) = Sort(N)</tex>. | ||

| − | + | [[Файл:External sort.png]] | |

| − | |||

| − | В качестве небольшой оптимизации можно в начале сортировать во внутренней памяти последовательности длины M, а не B. Хотя итоговая сложность и станет <tex>\mathcal{O}\left(\dfrac{N}{B}\log_{\frac{M}{B}}\dfrac{N}{M}\right)</tex>, но это уменьшит высоту дерева сортировки всего на единицу, что не очень сильно скажется на времени работы. | + | В качестве небольшой оптимизации можно в начале сортировать во внутренней памяти последовательности длины <tex>M</tex>, а не <tex>B</tex>. Хотя итоговая сложность и станет <tex>\mathcal{O}\left(\dfrac{N}{B}\log_{\frac{M}{B}}\dfrac{N}{M}\right)</tex>, но это уменьшит высоту дерева сортировки всего на единицу, что не очень сильно скажется на времени работы. |

=== Join === | === Join === | ||

| − | + | Пусть во внешней памяти есть <tex>2</tex> таблицы вида <tex>(key, value)</tex>. Первая таблица имеет вид <tex>(k_i, a_{k_i})</tex>, вторая {{---}} <tex>(l_j, b_{l_j})</tex>. Необходимо получить таблицу вида <tex>(i, a_i, b_i)</tex> (не умаляя общности считаем, что <tex>(k_1 \dots k_N)</tex> и <tex>(l_1 \dots l_N)</tex> являются перестановками чисел от <tex>1</tex> до <tex>N</tex>). Очевидно, что задача решается просто сортировками таблиц по ключу с последующим проходом по ним <tex>2</tex> указателями. Поэтому сложность алгоритма {{---}} <tex>Sort(N)</tex>. | |

| + | |||

| + | Данный алгоритм хоть и крайне прост, является одним из ключевых примитивов. Когда необходимо совершить какую-то операцию над разбросанными по памяти данными, часто задача сводится к последовательности нескольких Join'ов. | ||

== List Ranking == | == List Ranking == | ||

| − | |||

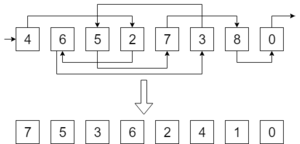

| − | + | [[Файл:List.png|300px|thumb|Входные данные и ответ]] | |

| + | Данная задача заключается в следующем: дан односвязный список, то есть для каждого элемента известно, какой идет следующим за ним. Необходимо для каждого элемента определить, каким он является по счету с конца списка. Расстояние до конца списка будем называть ''рангом'' элемента. Несмотря на простоту задачи в ''RAM-машине'', во внешней памяти задача имеет нетривиальное решение. Из-за того что все данные лежат хаотично, мы не можем просто пройтись по списку, это может потребовать слишком много операций ввода-вывода. | ||

| + | |||

| + | === Идея === | ||

| + | |||

| + | Решим задачу следующим способом: выкинем из списка какую-то часть элементов, после чего рекурсивно посчитаем ответ для полученного списка. Затем, зная промежуточный ответ, восстановим ответ для исходной задачи. Первая проблема {{---}} в модифицированном списке ранги элементов отличаются. Чтобы решить эту проблему, рассмотрим более общую задачу. Будем считать, что у каждого элемента есть вес, а ранг элемента {{---}} это сумма весов до конца списка. Для решения исходной задачи в самом начале присвоим каждому элементу вес <tex>1</tex>. | ||

| + | |||

| + | === Обозначения === | ||

| − | + | * <tex>next</tex> {{---}} массив входных данных. <tex>next_x = y</tex> означает, что после элемента <tex>x</tex> идет <tex>y</tex> (<tex>next_i = 0</tex> значит, что элемент <tex>i</tex> последний в списке). | |

| + | * <tex>w_i</tex> {{---}} вес элемента с номером <tex>i</tex> | ||

| + | * <tex>r_i</tex> {{---}} ранг элемента с номером <tex>i</tex> | ||

| − | + | === Удаление элементов и восстановление рангов === | |

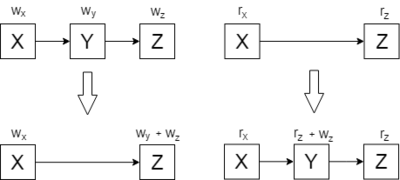

| − | + | Если есть <tex>3</tex> последовательных элемента <tex>x</tex>, <tex>y</tex>, <tex>z</tex> (<tex>next_x = y</tex>, <tex>next_y = z</tex>), то при удалении элемента <tex>y</tex> нужно увеличить вес <tex>z</tex> на <tex>w_y</tex>. То есть <tex>w_z'=w_z + w_y</tex>. После того, как мы посчитаем ответ для модифицированного списка, ранг удаленного элемента <tex>y</tex> будет равен <tex>r_y=r_z+w_z</tex>. | |

| − | + | [[Файл:List-ranking-wr.png|400px|Удаление элемента и восстановление ответа]] | |

| − | + | Выкидывать по <tex>1</tex> элементу крайне неэффективно, но если выкидывать какую-то весомую часть, то нужно быстро пересчитывать веса элементов. Сделать это можно с помощью уже рассмотренного Join, однако необходимо наложить ограничение на множество удаляемых элементов: никакие два удаленных элемента не должны идти подряд в списке. В противном случае может образоваться цепочка из удаленных элементов произвольной длины. Веса всех элементов этой цепочки нужно будет прибавить к первому не удаленному элементу, что равносильно самой задаче List Ranking, которую мы и пытаемся решить. | |

| − | 3 | + | Рассмотрим как именно изменять веса элементов. Построим и отсортируем по ключу <tex>3</tex> таблицы: |

| − | + | # Таблица <tex>Conn</tex> из пар <tex>(i, j)</tex>, где каждая пара значит, что после <tex>i</tex>-ого элемента идет <tex>j</tex>-ый (может быть получена из входных данных за время линейного сканирования) | |

| + | # Таблица <tex>W</tex> из пар <tex>(i, w_i)</tex>, хранящая веса элементов | ||

| + | # Таблица <tex>D</tex>, в которой записаны удаляемые элементы | ||

| − | + | Теперь пройдемся <tex>3</tex> указателями по этим таблицам. Как только встречается триплет вида <tex>(i, j) \in Conn</tex>, <tex>(i, w_i) \in W</tex>, <tex>(i) \in D</tex>, то добавим в новую таблицу пару <tex>(j, w_i)</tex>. В конце получится таблица добавок весов. Теперь из таблицы добавок и таблицы весов можно с помощью того же Join получить таблицу новых весов. | |

| − | + | По возвращению из рекурсии аналогично пересчитываются ранги элементов. Рассмотрим <tex>3</tex> таблицы: | |

| − | + | # Таблица <tex>RevConn</tex> из пар <tex>(j, i)</tex>, где каждая пара значит, что после <tex>i</tex>-ого элемента идет <tex>j</tex>-ый | |

| + | # Таблица <tex>W</tex> из пар <tex>(i, w_i)</tex>, хранящая веса элементов | ||

| + | # Таблица <tex>R</tex> из пар <tex>(i, r_i)</tex>, в которой записаны ранги элементов модифицированного списка | ||

| − | 3) | + | Также пройдемся <tex>3</tex> указателями по этим таблицам. Если нам встречается триплет вида <tex>(j, i) \in RevConn</tex>, <tex>(j, w_j) \in W</tex>, <tex>(j, r_j) \in R</tex>, то добавим пару <tex>(i, r_j + w_j)</tex> в таблицу новых рангов. Однако в эту таблицу попадут все элементы, у которых следующий элемент не был удален. Поэтому далее необходимо заменить лишние записи, используя таблицу старых рангов и Join. |

| − | + | === Выбор удаляемых элементов === | |

| − | Открытым остался | + | Открытым остался вопрос о том, какие элементы удалять. В идеале было бы удалять каждый второй элемент (больше нельзя, иначе ограничение будет нарушено), но понять какой элемент четный, какой нечетный не проще чем сама задача ранжирования. Один из способов удалять элементы {{---}} вероятностный. Для каждого элемента в списке бросим монетку. После этого выбросим всех орлов, после которых в списке идет решка (делается опять же с помощью Join). В таком случае никакие два выброшенных элемента не будут идти в списке подряд. |

| − | Подсчитаем | + | Подсчитаем [[Математическое ожидание случайной величины| математическое ожидание]] количества выброшенных элементов {{---}} <tex>E(D) = \sum\limits_{(i, j) \in Conn}\dfrac{1}{4} = \dfrac{N}{4}</tex> |

Тогда время работы алгоритма можно оценить с помощью рекурренты <tex>T(N) = T\left(\dfrac{3N}{4}\right) + Sort(N) = \mathcal{O}(Sort(N))</tex> | Тогда время работы алгоритма можно оценить с помощью рекурренты <tex>T(N) = T\left(\dfrac{3N}{4}\right) + Sort(N) = \mathcal{O}(Sort(N))</tex> | ||

| + | |||

| + | == См. также == | ||

| + | * [[Cache-oblivious алгоритмы]] | ||

| + | * [[B-дерево]] | ||

| + | * [[B+-дерево]] | ||

| + | |||

| + | == Примeчания == | ||

| + | <references/> | ||

| + | |||

| + | == Источники информации == | ||

| + | * [https://www.lektorium.tv/course/22905 Максим Бабенко {{---}} Курс алгоритмов во внешней памяти.] | ||

| + | * [https://en.wikipedia.org/wiki/External_memory_algorithm Wikipedia {{---}} External memory algorithm.] | ||

| + | |||

| + | [[Категория:Алгоритмы]] | ||

| + | [[Категория:Алгоритмы во внешней памяти]] | ||

Текущая версия на 19:34, 4 сентября 2022

Содержание

Модель вычислений во внешней памяти

Обычно оценка сложности рассматриваемых алгоритмов происходит в модели под названием RAM-машина[1]. Это означает, что у нас есть оперативная память, из которой мы можем читать и писать произвольную ячейку памяти за время элементарной операции. Таким образом время вычислительных операций и операций с памятью приравнивается, что сильно упрощает анализ.

Но в таком случае размер данных, с которыми мы работаем, должен помещаться в оперативную память. Предположим, что ее размер порядка GB, а обработать нужно порядка TB информации. Очевидно, что необходимо использовать какую-то внешнюю память, например — жесткий диск. Хотя диски существенно дешевле

оперативной памяти и имеют высокую емкость, они гораздо медленнее из-за механического построения считывания. Для сравнения, время обращения к оперативной памяти порядка ns, а к HDD — порядка ms ( s и s). Однако, основное время тратится на позиционирование головки жесткого диска, из-за чего разрыв в скорости последовательного чтения не такой большой. Из оперативной памяти можно читать со скоростью порядка GB/s, с HDD — порядка MB/s.

Из-за описанного выше, для оценки сложности алгоритмов во внешней памяти была предложена другая модель. Модель гласит следующее: существует какая-то внешняя память и процессор со своей внутренней памятью. Внутренняя память ограничена и имеет размер порядка машинных слов. Внешняя память считается безграничной в рамках рассматриваемой задачи, то есть имеет размер хотя бы порядка машинных слов, где — размер задачи. Чтение и запись из внешней памяти происходит блоками последовательных данных размера машинных слов. В качестве меры сложности принимается количество операций ввода-вывода, которые выполняет алгоритм, где одна операция ввода-вывода это либо чтение из внешней памяти одного блока размера , либо запись.

У данной модели есть один существенный недостаток: мы никак не учитываем время, которое тратится на вычисления, а считаем только обращения к диску. Из-за этого многие задачи в данной модели решаются быстрее, чем в модели с RAM-машиной. Например, прочитав какой-то блок, далее мы имеем право произвести экспоненциальный по сложности перебор, и это никак не будет учитываться. Поэтому нужно иметь в виду, что данная модель стремится эффективно использовать жесткий диск, а не балансировать между использованием процессора и жесткого диска.

Размер блока

Так как время позиционирования головки внешнего диска весьма непредсказуемо, то необходимо взять размер блока таким, чтобы время чтения самих данных было гораздо больше, чем время позиционирования к этим данным. То есть должно выполняться . Если MB/s, ms, то MB. На практике, размер блока нужно брать больше чем MB (около MB), так как тогда время позиционирования станет существенно меньше времени чтения.

Базовые задачи

Scan

На диске записаны чисел, нужно найти их сумму (например, по какому-нибудь модулю). Очевидно, что эта задача равносильна просто считыванию с диска. Сложность линейного сканирования данных с диска — . Важно заметить, что из-за округления, в общем случае .

Слияние упорядоченных последовательностей

Пусть имеется две упорядоченные последовательности размера и соответственно. Чтобы их слить, достаточно завести во внутренней памяти блока. В первые мы будем читать сами последовательности, а в третий — записывать результат слияния, используя стандартный алгоритм с указателями. Как только какой-то из указателей дошел до конца блока, необходимо считывать следующий, а когда буфер с результатом слияния заполнился — необходимо записывать его во внешнюю память и очищать. Сложность алгоритма —

Сортировка

Поскольку мы легко умеем выполнять слияние упорядоченных последовательностей, логичным шагом будет рассмотреть сортировку во внешней памяти. Рассмотрим некоторую модификацию алгоритма Merge sort. В стандартном алгоритме все элементы разбиваются на пары, после чего сливаются в упорядоченные последовательности длины , те в свою очередь сливаются в последовательности длины и так далее (для простоты описания будем считать, что и это степени двойки). Во внешней памяти не выгодно начинать с последовательностей длины , так как чтение происходит блоками длины . Вместо этого можно целиком считать блок и отсортировать его во внутренней памяти. Тогда количество листьев в дереве сортировки будет не , а . Помимо этого, гораздо выгоднее сливать больше чем списка за раз, чтобы уменьшить высоту дерева сортировки. Так как оперативная память размера , то можно сливать сразу списков. Итого, на каждом уровне дерева сортировки мы выполняем операций и итоговая сложность — .

В качестве небольшой оптимизации можно в начале сортировать во внутренней памяти последовательности длины , а не . Хотя итоговая сложность и станет , но это уменьшит высоту дерева сортировки всего на единицу, что не очень сильно скажется на времени работы.

Join

Пусть во внешней памяти есть таблицы вида . Первая таблица имеет вид , вторая — . Необходимо получить таблицу вида (не умаляя общности считаем, что и являются перестановками чисел от до ). Очевидно, что задача решается просто сортировками таблиц по ключу с последующим проходом по ним указателями. Поэтому сложность алгоритма — .

Данный алгоритм хоть и крайне прост, является одним из ключевых примитивов. Когда необходимо совершить какую-то операцию над разбросанными по памяти данными, часто задача сводится к последовательности нескольких Join'ов.

List Ranking

Данная задача заключается в следующем: дан односвязный список, то есть для каждого элемента известно, какой идет следующим за ним. Необходимо для каждого элемента определить, каким он является по счету с конца списка. Расстояние до конца списка будем называть рангом элемента. Несмотря на простоту задачи в RAM-машине, во внешней памяти задача имеет нетривиальное решение. Из-за того что все данные лежат хаотично, мы не можем просто пройтись по списку, это может потребовать слишком много операций ввода-вывода.

Идея

Решим задачу следующим способом: выкинем из списка какую-то часть элементов, после чего рекурсивно посчитаем ответ для полученного списка. Затем, зная промежуточный ответ, восстановим ответ для исходной задачи. Первая проблема — в модифицированном списке ранги элементов отличаются. Чтобы решить эту проблему, рассмотрим более общую задачу. Будем считать, что у каждого элемента есть вес, а ранг элемента — это сумма весов до конца списка. Для решения исходной задачи в самом начале присвоим каждому элементу вес .

Обозначения

- — массив входных данных. означает, что после элемента идет ( значит, что элемент последний в списке).

- — вес элемента с номером

- — ранг элемента с номером

Удаление элементов и восстановление рангов

Если есть последовательных элемента , , (, ), то при удалении элемента нужно увеличить вес на . То есть . После того, как мы посчитаем ответ для модифицированного списка, ранг удаленного элемента будет равен .

Выкидывать по элементу крайне неэффективно, но если выкидывать какую-то весомую часть, то нужно быстро пересчитывать веса элементов. Сделать это можно с помощью уже рассмотренного Join, однако необходимо наложить ограничение на множество удаляемых элементов: никакие два удаленных элемента не должны идти подряд в списке. В противном случае может образоваться цепочка из удаленных элементов произвольной длины. Веса всех элементов этой цепочки нужно будет прибавить к первому не удаленному элементу, что равносильно самой задаче List Ranking, которую мы и пытаемся решить.

Рассмотрим как именно изменять веса элементов. Построим и отсортируем по ключу таблицы:

- Таблица из пар , где каждая пара значит, что после -ого элемента идет -ый (может быть получена из входных данных за время линейного сканирования)

- Таблица из пар , хранящая веса элементов

- Таблица , в которой записаны удаляемые элементы

Теперь пройдемся указателями по этим таблицам. Как только встречается триплет вида , , , то добавим в новую таблицу пару . В конце получится таблица добавок весов. Теперь из таблицы добавок и таблицы весов можно с помощью того же Join получить таблицу новых весов.

По возвращению из рекурсии аналогично пересчитываются ранги элементов. Рассмотрим таблицы:

- Таблица из пар , где каждая пара значит, что после -ого элемента идет -ый

- Таблица из пар , хранящая веса элементов

- Таблица из пар , в которой записаны ранги элементов модифицированного списка

Также пройдемся указателями по этим таблицам. Если нам встречается триплет вида , , , то добавим пару в таблицу новых рангов. Однако в эту таблицу попадут все элементы, у которых следующий элемент не был удален. Поэтому далее необходимо заменить лишние записи, используя таблицу старых рангов и Join.

Выбор удаляемых элементов

Открытым остался вопрос о том, какие элементы удалять. В идеале было бы удалять каждый второй элемент (больше нельзя, иначе ограничение будет нарушено), но понять какой элемент четный, какой нечетный не проще чем сама задача ранжирования. Один из способов удалять элементы — вероятностный. Для каждого элемента в списке бросим монетку. После этого выбросим всех орлов, после которых в списке идет решка (делается опять же с помощью Join). В таком случае никакие два выброшенных элемента не будут идти в списке подряд.

Подсчитаем математическое ожидание количества выброшенных элементов —

Тогда время работы алгоритма можно оценить с помощью рекурренты