Практики реализации нейронных сетей — различия между версиями

Sketcher (обсуждение | вклад) (→Источники информации) |

м (rollbackEdits.php mass rollback) |

||

| (не показано 25 промежуточных версий 4 участников) | |||

| Строка 1: | Строка 1: | ||

==Аугментация данных== | ==Аугментация данных== | ||

| − | При глубоком обучении иногда можно столкнуться с ситуацией, когда | + | При глубоком обучении иногда можно столкнуться с ситуацией, когда набор данных имеет ограниченный размер. Но чтобы получить лучшие результаты обобщение модели, необходимо иметь больше данных, в том числе и различные их вариации. То есть необходимо увеличить размер исходного набора искусственным образом, и это можно сделать с помощью аугментации данных. |

{{Определение | {{Определение | ||

|definition= '''Аугментация данных''' (англ. ''data augmentation'') {{---}} это методика создания дополнительных данных из имеющихся данных.}} | |definition= '''Аугментация данных''' (англ. ''data augmentation'') {{---}} это методика создания дополнительных данных из имеющихся данных.}} | ||

| − | Чаще всего, проблема ограниченного | + | Чаще всего, проблема ограниченного набора данных возникает при решении задач, связанных с обработкой изображений. Следующие способы аугментации изображений являются самыми популярными: |

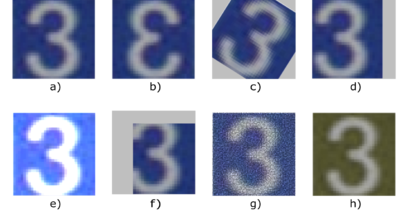

| − | [[Файл: | + | [[Файл:Augmentation.png|400px|thumb|right|Рис 1. a) Исходное изображение. b) Отображение по горизонтали. c) Вращение. d) Отступ. <br> e) Увеличение яркости и контрастности. f) Вырезание. <br> g) Добавление шума. h) Изменение RGB каналов.]] |

| − | *Отображение по вертикали или горизонтали (''flipping''). | + | *Отображение по вертикали или горизонтали (англ. ''flipping''). |

| − | *Поворот изображения на определенный угол (''rotation''). | + | *Поворот изображения на определенный угол (англ. ''rotation''). |

| − | *Создание отступа (''padding''). | + | *Создание отступа (англ. ''padding''). |

| − | *Вырезание части изображения (''cropping''). | + | *Вырезание части изображения (англ. ''cropping''). |

| − | *Добавление шума (''adding noise''). | + | *Добавление шума (англ. ''adding noise''). |

| − | *Манипуляции с цветом (''color jittering''). | + | *Манипуляции с цветом (англ. ''color jittering''). |

Также, можно применять различные комбинации, к примеру, вырезать часть изображения, повернуть его и изменить цвет фона. | Также, можно применять различные комбинации, к примеру, вырезать часть изображения, повернуть его и изменить цвет фона. | ||

| − | Продвинутыми способами аугментации данных является семейство [[Generative Adversarial Nets (GAN) | | + | Продвинутыми способами аугментации данных является семейство [[Generative Adversarial Nets (GAN) | порождающих состязательных сетей]]. |

==Дропаут== | ==Дропаут== | ||

| − | Одной из проблем глубокого обучения нейронных сетей является [[Переобучение | переобучение]]. И дропаут | + | Одной из проблем глубокого обучения нейронных сетей является [[Переобучение | переобучение]]. И метод дропаут {{---}} популярный способ решения этой проблемы, благодаря простому алгоритму и хорошим практическим результатам. |

{{Определение | {{Определение | ||

|definition= '''Дропаут''' (англ. ''dropout'') {{---}} метод регуляризации нейронной сети для предотвращения переобучения.}} | |definition= '''Дропаут''' (англ. ''dropout'') {{---}} метод регуляризации нейронной сети для предотвращения переобучения.}} | ||

В обычной нейронной сети явление переобучения появляется из-за так называемой совместной адаптации (англ. ''co-adaptation''), то есть при обновлении весов нейрона, во время обучения [[Обратное распространение ошибки | методом обратного распространения ошибки]], учитывается деятельность остальных нейронов с целью минимизировать функцию потерь. Поэтому веса нейронов могут меняться, исправляя при этом ошибки других нейронов. Метод дропаута как раз предотвращает эту адаптацию. | В обычной нейронной сети явление переобучения появляется из-за так называемой совместной адаптации (англ. ''co-adaptation''), то есть при обновлении весов нейрона, во время обучения [[Обратное распространение ошибки | методом обратного распространения ошибки]], учитывается деятельность остальных нейронов с целью минимизировать функцию потерь. Поэтому веса нейронов могут меняться, исправляя при этом ошибки других нейронов. Метод дропаута как раз предотвращает эту адаптацию. | ||

| − | [[Файл: | + | [[Файл:NewDropoutExample.jpeg|400px|thumb|right|Рис 2. a) Стандартная нейронная сеть. <br> b) Нейронная сеть после применения дропаута.]] |

| − | === | + | ===Алгоритм дропаут=== |

Рассмотрим слой нейронной сети состоящий из <tex>H</tex> нейронов. Метод дропаут выключает нейрон с вероятностью <tex>p</tex>, соответственно, оставляет включенным с вероятностью <tex>q = 1 - p</tex>, причем вероятность выключения любого нейрона сети одинакова. | Рассмотрим слой нейронной сети состоящий из <tex>H</tex> нейронов. Метод дропаут выключает нейрон с вероятностью <tex>p</tex>, соответственно, оставляет включенным с вероятностью <tex>q = 1 - p</tex>, причем вероятность выключения любого нейрона сети одинакова. | ||

| Строка 42: | Строка 42: | ||

{{Определение | {{Определение | ||

|definition= '''Функция активации''' (англ. ''activation function'') <tex>a(x)</tex> определяет выходное значение нейрона в зависимости от результата взвешенной суммы входов и порогового значения.}} | |definition= '''Функция активации''' (англ. ''activation function'') <tex>a(x)</tex> определяет выходное значение нейрона в зависимости от результата взвешенной суммы входов и порогового значения.}} | ||

| − | Рассмотрим нейрон, у которого взвешенная сумма входов: <tex>z = \sum\limits_{i} w_{i}x_{i} + | + | Рассмотрим нейрон, у которого взвешенная сумма входов: <tex>z = \sum\limits_{i} w_{i}x_{i} + b</tex>, где <tex>w_{i}</tex> и <tex>x_{i}</tex> {{---}} вес и входное значение <tex>i</tex>-ого входа, а <tex>b</tex> {{---}} смещение. Полученный результат передается в функцию активации, которая решает рассматривать этот нейрон как активированный, или его можно игнорировать. |

[[Файл:BinaryStepFunction.jpg|200px|thumb|right|Рис 3. Ступенчатая функция]] | [[Файл:BinaryStepFunction.jpg|200px|thumb|right|Рис 3. Ступенчатая функция]] | ||

| Строка 55: | Строка 55: | ||

# Невозможность использования метода обратного распространения ошибки. Так как в основе этого метода обучения лежит [[Стохастический градиентный спуск | градиентный спуск]], а для того чтобы его найти, нужно взять производную, которая для данной функции активации {{---}} константа и не зависит от входных значений. То есть при обновлении весов нельзя сказать улучшается ли эмпирический риск на текущем шаге или нет. | # Невозможность использования метода обратного распространения ошибки. Так как в основе этого метода обучения лежит [[Стохастический градиентный спуск | градиентный спуск]], а для того чтобы его найти, нужно взять производную, которая для данной функции активации {{---}} константа и не зависит от входных значений. То есть при обновлении весов нельзя сказать улучшается ли эмпирический риск на текущем шаге или нет. | ||

# Рассмотрим нейронную сеть с несколькими слоями с данной функцией активации. Так как для каждого слоя выходное значение линейно, то они образуют линейную комбинацию, результатом которой является линейная функция. То есть финальная функция активации на последнем слое зависит только от входных значений на первом слое. А это значит, что любое количество слоев может быть заменено всего одним слоем, и, следовательно, нет смысла создавать многослойную сеть. | # Рассмотрим нейронную сеть с несколькими слоями с данной функцией активации. Так как для каждого слоя выходное значение линейно, то они образуют линейную комбинацию, результатом которой является линейная функция. То есть финальная функция активации на последнем слое зависит только от входных значений на первом слое. А это значит, что любое количество слоев может быть заменено всего одним слоем, и, следовательно, нет смысла создавать многослойную сеть. | ||

| + | |||

| + | Главное отличие линейной функции от остальных в том, что ее область значений не ограничена: <tex>(-\infty; +\infty)</tex>. Следовательно, ее нужно использовать, когда выходное значение нейрона должно <tex>\in \mathbb R</tex>, а не ограниченному интервалу. | ||

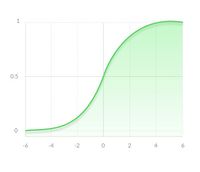

[[Файл:SigmoidFunction.jpg|200px|thumb|right|Рис 5. Сигмоидная функция]] | [[Файл:SigmoidFunction.jpg|200px|thumb|right|Рис 5. Сигмоидная функция]] | ||

| + | |||

===Сигмоидная функция=== | ===Сигмоидная функция=== | ||

Сигмоидная функция (англ. ''sigmoid function''), которую также называет логистической (англ. ''logistic function''), является гладкой монотонно возрастающей нелинейной функцией: <tex>\sigma(z) = \dfrac1{1+e^{-z}}</tex>. И так как эта функция нелинейна, то ее можно использовать в нейронных сетях с множеством слоев, а также обучать эти сети методом обратного распространения ошибки. Сигмоида ограничена двумя горизонтальными асимптотами <tex>y = 1</tex> и <tex>y = 0</tex>, что дает нормализацию выходного значения каждого нейрона. Кроме того, для сигмоидной функции характерен гладкий градиент, который предотвращает "прыжки" при подсчете выходного значения. Помимо всего этого, у этой функции есть еще одно преимущество, для значений <tex>x > 2</tex> и <tex>x < -2</tex>, <tex>y</tex> "прижимается" к одной из асимптот, что позволяет делать четкие предсказания классов. | Сигмоидная функция (англ. ''sigmoid function''), которую также называет логистической (англ. ''logistic function''), является гладкой монотонно возрастающей нелинейной функцией: <tex>\sigma(z) = \dfrac1{1+e^{-z}}</tex>. И так как эта функция нелинейна, то ее можно использовать в нейронных сетях с множеством слоев, а также обучать эти сети методом обратного распространения ошибки. Сигмоида ограничена двумя горизонтальными асимптотами <tex>y = 1</tex> и <tex>y = 0</tex>, что дает нормализацию выходного значения каждого нейрона. Кроме того, для сигмоидной функции характерен гладкий градиент, который предотвращает "прыжки" при подсчете выходного значения. Помимо всего этого, у этой функции есть еще одно преимущество, для значений <tex>x > 2</tex> и <tex>x < -2</tex>, <tex>y</tex> "прижимается" к одной из асимптот, что позволяет делать четкие предсказания классов. | ||

Несмотря на множество сильных сторон сигмоидной функции, у нее есть значительный недостаток. Производная такой функции крайне мала во всех точках, кроме сравнительно небольшого промежутка. Это сильно усложняет процесс улучшения весов с помощью градиентного спуска. Более того, эта проблема усугубляется в случае, если модель содержит много слоев. Данная проблема называется проблемой исчезающего градиента.<ref>[https://en.wikipedia.org/wiki/Vanishing_gradient_problem Vanishing gradient problem, Wikipedia]</ref> | Несмотря на множество сильных сторон сигмоидной функции, у нее есть значительный недостаток. Производная такой функции крайне мала во всех точках, кроме сравнительно небольшого промежутка. Это сильно усложняет процесс улучшения весов с помощью градиентного спуска. Более того, эта проблема усугубляется в случае, если модель содержит много слоев. Данная проблема называется проблемой исчезающего градиента.<ref>[https://en.wikipedia.org/wiki/Vanishing_gradient_problem Vanishing gradient problem, Wikipedia]</ref> | ||

| + | |||

| + | Что касается использования сигмоидной функции, то ее преимущество над другими {{---}} в нормализации выходного значения. Иногда, это бывает крайне необходимо. К примеру, когда итоговое значение слоя должно представлять вероятность случайной величины. Кроме того, эту функцию удобно применять при решении задачи классификации, благодаря свойству "прижимания" к асимптотам. | ||

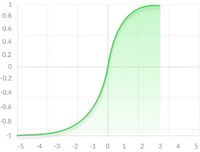

[[Файл:TanhFunction.jpg|200px|thumb|right|Рис 6. Функция гиперболического тангенса]] | [[Файл:TanhFunction.jpg|200px|thumb|right|Рис 6. Функция гиперболического тангенса]] | ||

===Функция гиперболического тангенса=== | ===Функция гиперболического тангенса=== | ||

| − | Функция гиперболического тангенса (англ. ''hyperbolic tangent'') имеет вид: <tex>tanh(z) = \dfrac2{1+e^{-2z}} - 1</tex>. Эта функция является скорректированной сигмоидной функцей <tex>tanh(z) = 2 \cdot sigma(2z) - 1</tex>, то есть она сохраняет те же преимущества и недостатки, но уже для диапазона значений <tex>(-1; 1)</tex>. | + | Функция гиперболического тангенса (англ. ''hyperbolic tangent'') имеет вид: <tex>tanh(z) = \dfrac2{1+e^{-2z}} - 1</tex>. Эта функция является скорректированной сигмоидной функцей <tex>tanh(z) = 2 \cdot sigma(2z) - 1</tex>, то есть она сохраняет те же преимущества и недостатки, но уже для диапазона значений <tex>(-1; 1)</tex>. |

| + | |||

| + | Обычно, <tex>tanh</tex> является предпочтительнее сигмоиды в случаях, когда нет необходимости в нормализации. Это происходит из-за того, что область определения данной функции активации центрирована относительно нуля, что снимает ограничение при подсчете градиента для перемещения в определенном направлении. Кроме того, производная гиперболического тангенса значительно выше вблизи нуля, давая большую амплитуду градиентному спуску, а следовательно и более быструю сходимость. | ||

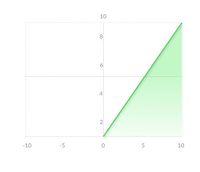

[[Файл:ReLuFunction.jpg|200px|thumb|right|Рис 7. Функция ReLU]] | [[Файл:ReLuFunction.jpg|200px|thumb|right|Рис 7. Функция ReLU]] | ||

===Функция ReLU=== | ===Функция ReLU=== | ||

| − | Rectified Linear Unit {{---}} это наиболее часто используемая | + | Rectified Linear Unit {{---}} это наиболее часто используемая функция активации при глубоком обучении. Данная функция возвращает 0, если принимает отрицательный аргумент, в случае же положительного аргумента, функция возвращает само число. То есть она может быть записана как <tex>f(z)=max(0, z)</tex>. На первый взгляд может показаться, что она линейна и имеет те же проблемы что и линейная функция, но это не так и ее можно использовать в нейронных сетях с множеством слоев. |

Функция ReLU обладает несколькими преимущества перед сигмоидой и гиперболическим тангенсом: | Функция ReLU обладает несколькими преимущества перед сигмоидой и гиперболическим тангенсом: | ||

# Очень быстро и просто считается производная. Для отрицательных значений {{---}} 0, для положительных {{---}} 1. | # Очень быстро и просто считается производная. Для отрицательных значений {{---}} 0, для положительных {{---}} 1. | ||

# Разреженность активации. В сетях с очень большим количеством нейронов использование сигмоидной функции или гиперболического тангенса в качестве активационный функции влечет активацию почти всех нейронов, что может сказаться на производительности обучения модели. Если же использовать ReLU, то количество включаемых нейронов станет меньше, в силу характеристик функции, и сама сеть станет легче. | # Разреженность активации. В сетях с очень большим количеством нейронов использование сигмоидной функции или гиперболического тангенса в качестве активационный функции влечет активацию почти всех нейронов, что может сказаться на производительности обучения модели. Если же использовать ReLU, то количество включаемых нейронов станет меньше, в силу характеристик функции, и сама сеть станет легче. | ||

| + | |||

У данной функции есть один недостаток, называющийся проблемой умирающего ReLU<ref>[https://en.wikipedia.org/wiki/Rectifier_(neural_networks)#Potential_problems Dying ReLU problem, Wikipedia]</ref>. Так как часть производной функции равна нулю, то и градиент для нее будет нулевым, а то это значит, что веса не будут изменяться во время спуска и нейронная сеть перестанет обучаться. | У данной функции есть один недостаток, называющийся проблемой умирающего ReLU<ref>[https://en.wikipedia.org/wiki/Rectifier_(neural_networks)#Potential_problems Dying ReLU problem, Wikipedia]</ref>. Так как часть производной функции равна нулю, то и градиент для нее будет нулевым, а то это значит, что веса не будут изменяться во время спуска и нейронная сеть перестанет обучаться. | ||

| + | |||

| + | Функцию активации ReLU следует использовать, если нет особых требований для выходного значения нейрона, вроде неограниченной области определения. Но если после обучения модели результаты получились не оптимальные, то стоит перейти к другим функциям, которые могут дать лучший результат. | ||

| + | |||

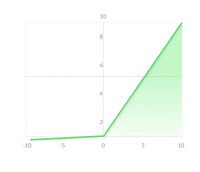

| + | [[Файл:LReLuFunction.jpg|200px|thumb|right|Рис 8. Функция Leaky ReLU]] | ||

| + | ===Функция Leaky ReLU=== | ||

| + | Одной из проблем стандартного ReLU является затухающий, а именно нулевой, градиент при отрицательных значениях. При использовании обычного ReLU некоторые нейроны умирают, а отследить умирание нейронов не просто. Чтобы решить эту проблему иногда используется подход ReLU с «утечкой» (leak) {{---}} график функции активации на отрицательных значениях образует не горизонтальную прямую, а наклонную, с маленьким угловым коэффициентом (порядка 0,01). То есть она может быть записана как <tex>\begin{equation} | ||

| + | f(x) = | ||

| + | \begin{cases} | ||

| + | 0.01x, & \text{if}\ x < 0 \\ | ||

| + | x, & \text{otherwise} \\ | ||

| + | \end{cases} | ||

| + | \end{equation}</tex>. Такое небольшое отрицательное значение помогает добиться ненулевого градиента при отрицательных значениях. | ||

| + | Однако, функция Leaky ReLU имеет некоторые недостатки: | ||

| + | # Сложнее считать производную, по сравнению со стандартным подходом (так как значения уже не равны нулю), что замедляет работу каждой эпохи. | ||

| + | # Угловой коэффициент прямой также является гиперпараметром, который надо настраивать. | ||

| + | # На практике, результат не всегда сильно улучшается относительно ReLU. | ||

| + | Стоит отметить, что помимо проблемы умирающих нейронов, у ReLU есть и другая {{---}} проблема [[Затухающий градиент | затухающего градиента]]<sup>[на 03.01.20 не создан]</sup>. При слишком большом количестве слоев градиент будет принимать очень маленькое значение, постепенно уменьшаясь до нуля. Из-за этого нейронная сеть работает нестабильно и неправильно. Leaky ReLU (LReLU) решает первую проблему, но в по-настоящему глубоких сетях проблема затухания градиента все еще встречается и при использовании этого подхода. | ||

| + | |||

| + | На практике LReLU используется не так часто. Практический результат использования LReLU вместо ReLU отличается не слишком сильно. Однако в случае использования Leaky требуется дополнительно настраивать гиперпараметр (уровень наклона при отрицательных значениях), что требует определенных усилий. Еще одной проблемой является то, что результат LReLU не всегда лучше чем при использовании обычного ReLU, поэтому чаще всего такой подход используют как альтернатива. Довольно часто на практике используется PReLU (Parametric ReLU), который позволяет добиться более значительных улучшений по сравнению с ReLU и LReLU. Также, в случае параметрической модификации ReLU, угол наклона не является гиперпараметром и настраивается нейросетью. | ||

==См. также== | ==См. также== | ||

Текущая версия на 19:22, 4 сентября 2022

Содержание

Аугментация данных

При глубоком обучении иногда можно столкнуться с ситуацией, когда набор данных имеет ограниченный размер. Но чтобы получить лучшие результаты обобщение модели, необходимо иметь больше данных, в том числе и различные их вариации. То есть необходимо увеличить размер исходного набора искусственным образом, и это можно сделать с помощью аугментации данных.

| Определение: |

| Аугментация данных (англ. data augmentation) — это методика создания дополнительных данных из имеющихся данных. |

Чаще всего, проблема ограниченного набора данных возникает при решении задач, связанных с обработкой изображений. Следующие способы аугментации изображений являются самыми популярными:

- Отображение по вертикали или горизонтали (англ. flipping).

- Поворот изображения на определенный угол (англ. rotation).

- Создание отступа (англ. padding).

- Вырезание части изображения (англ. cropping).

- Добавление шума (англ. adding noise).

- Манипуляции с цветом (англ. color jittering).

Также, можно применять различные комбинации, к примеру, вырезать часть изображения, повернуть его и изменить цвет фона.

Продвинутыми способами аугментации данных является семейство порождающих состязательных сетей.

Дропаут

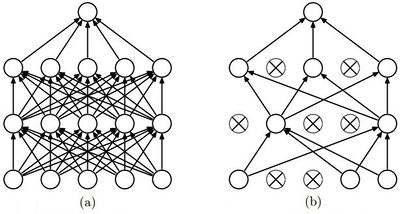

Одной из проблем глубокого обучения нейронных сетей является переобучение. И метод дропаут — популярный способ решения этой проблемы, благодаря простому алгоритму и хорошим практическим результатам.

| Определение: |

| Дропаут (англ. dropout) — метод регуляризации нейронной сети для предотвращения переобучения. |

В обычной нейронной сети явление переобучения появляется из-за так называемой совместной адаптации (англ. co-adaptation), то есть при обновлении весов нейрона, во время обучения методом обратного распространения ошибки, учитывается деятельность остальных нейронов с целью минимизировать функцию потерь. Поэтому веса нейронов могут меняться, исправляя при этом ошибки других нейронов. Метод дропаута как раз предотвращает эту адаптацию.

Алгоритм дропаут

Рассмотрим слой нейронной сети состоящий из нейронов. Метод дропаут выключает нейрон с вероятностью , соответственно, оставляет включенным с вероятностью , причем вероятность выключения любого нейрона сети одинакова.

Пусть — функция активации, тогда применение дропаута для -ого нейрона выглядит так: ,

где вероятность .

Данная формула применяется на этапе обучения модели. Но так как на этом этапе нейрон остается в сети с вероятностью , на этапе тестирования необходимо эмулировать поведение нейронной сети, использованного при обучении. Для этого результат выходного значения функции активации умножается на коэффициент , то есть на этапе тестирования: .

Обратный дропаут

Обратный дропаут (англ. inverted dropout) отличается от обычного тем, что умножение на коэффициент происходит на этапе обучения, причем этот коэффициент равен обратной вероятности того, что нейрон останется в сети: . А на этапе тестирования выходное значение нейрона остается таким же, как и в методе обратного распространения ошибки.

Таким образом, выходное значение -ого нейрона на этапе обучения: , на этапе тестирования: .

Обратная модификация дропаута на практике используется чаще обычной, потому что в ней не нужно менять каждый раз модель для проведения этапа тестирования.

Функции активации

Одним из важнейших аспектов глубокой нейронной сети являются функции активации.

| Определение: |

| Функция активации (англ. activation function) определяет выходное значение нейрона в зависимости от результата взвешенной суммы входов и порогового значения. |

Рассмотрим нейрон, у которого взвешенная сумма входов: , где и — вес и входное значение -ого входа, а — смещение. Полученный результат передается в функцию активации, которая решает рассматривать этот нейрон как активированный, или его можно игнорировать.

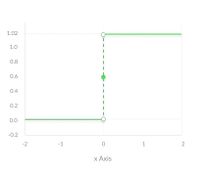

Ступенчатая функция

Ступенчатая функция (англ. binary step function) является пороговой функцией активации. То есть если больше или меньше некоторого значения, то нейрон становится активированным. Такая функция отлично работает для бинарной классификации. Но она не работает, когда для классификации требуется большее число нейронов и количество возможных классов больше двух.

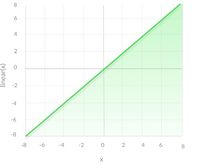

Линейная функция

Линейная функция (англ. linear function) представляет собой прямую линию, то есть , а это значит, что результат этой функции активации пропорционален переданному аргументу. В отличии от предыдущей функции, она позволяет получить диапазон значений на выходе, а не только бинарные 0 и 1, что решает проблему классификации с большим количеством классов. Но у линейной функции есть две основных проблемы:

- Невозможность использования метода обратного распространения ошибки. Так как в основе этого метода обучения лежит градиентный спуск, а для того чтобы его найти, нужно взять производную, которая для данной функции активации — константа и не зависит от входных значений. То есть при обновлении весов нельзя сказать улучшается ли эмпирический риск на текущем шаге или нет.

- Рассмотрим нейронную сеть с несколькими слоями с данной функцией активации. Так как для каждого слоя выходное значение линейно, то они образуют линейную комбинацию, результатом которой является линейная функция. То есть финальная функция активации на последнем слое зависит только от входных значений на первом слое. А это значит, что любое количество слоев может быть заменено всего одним слоем, и, следовательно, нет смысла создавать многослойную сеть.

Главное отличие линейной функции от остальных в том, что ее область значений не ограничена: . Следовательно, ее нужно использовать, когда выходное значение нейрона должно , а не ограниченному интервалу.

Сигмоидная функция

Сигмоидная функция (англ. sigmoid function), которую также называет логистической (англ. logistic function), является гладкой монотонно возрастающей нелинейной функцией: . И так как эта функция нелинейна, то ее можно использовать в нейронных сетях с множеством слоев, а также обучать эти сети методом обратного распространения ошибки. Сигмоида ограничена двумя горизонтальными асимптотами и , что дает нормализацию выходного значения каждого нейрона. Кроме того, для сигмоидной функции характерен гладкий градиент, который предотвращает "прыжки" при подсчете выходного значения. Помимо всего этого, у этой функции есть еще одно преимущество, для значений и , "прижимается" к одной из асимптот, что позволяет делать четкие предсказания классов.

Несмотря на множество сильных сторон сигмоидной функции, у нее есть значительный недостаток. Производная такой функции крайне мала во всех точках, кроме сравнительно небольшого промежутка. Это сильно усложняет процесс улучшения весов с помощью градиентного спуска. Более того, эта проблема усугубляется в случае, если модель содержит много слоев. Данная проблема называется проблемой исчезающего градиента.[1]

Что касается использования сигмоидной функции, то ее преимущество над другими — в нормализации выходного значения. Иногда, это бывает крайне необходимо. К примеру, когда итоговое значение слоя должно представлять вероятность случайной величины. Кроме того, эту функцию удобно применять при решении задачи классификации, благодаря свойству "прижимания" к асимптотам.

Функция гиперболического тангенса

Функция гиперболического тангенса (англ. hyperbolic tangent) имеет вид: . Эта функция является скорректированной сигмоидной функцей , то есть она сохраняет те же преимущества и недостатки, но уже для диапазона значений .

Обычно, является предпочтительнее сигмоиды в случаях, когда нет необходимости в нормализации. Это происходит из-за того, что область определения данной функции активации центрирована относительно нуля, что снимает ограничение при подсчете градиента для перемещения в определенном направлении. Кроме того, производная гиперболического тангенса значительно выше вблизи нуля, давая большую амплитуду градиентному спуску, а следовательно и более быструю сходимость.

Функция ReLU

Rectified Linear Unit — это наиболее часто используемая функция активации при глубоком обучении. Данная функция возвращает 0, если принимает отрицательный аргумент, в случае же положительного аргумента, функция возвращает само число. То есть она может быть записана как . На первый взгляд может показаться, что она линейна и имеет те же проблемы что и линейная функция, но это не так и ее можно использовать в нейронных сетях с множеством слоев. Функция ReLU обладает несколькими преимущества перед сигмоидой и гиперболическим тангенсом:

- Очень быстро и просто считается производная. Для отрицательных значений — 0, для положительных — 1.

- Разреженность активации. В сетях с очень большим количеством нейронов использование сигмоидной функции или гиперболического тангенса в качестве активационный функции влечет активацию почти всех нейронов, что может сказаться на производительности обучения модели. Если же использовать ReLU, то количество включаемых нейронов станет меньше, в силу характеристик функции, и сама сеть станет легче.

У данной функции есть один недостаток, называющийся проблемой умирающего ReLU[2]. Так как часть производной функции равна нулю, то и градиент для нее будет нулевым, а то это значит, что веса не будут изменяться во время спуска и нейронная сеть перестанет обучаться.

Функцию активации ReLU следует использовать, если нет особых требований для выходного значения нейрона, вроде неограниченной области определения. Но если после обучения модели результаты получились не оптимальные, то стоит перейти к другим функциям, которые могут дать лучший результат.

Функция Leaky ReLU

Одной из проблем стандартного ReLU является затухающий, а именно нулевой, градиент при отрицательных значениях. При использовании обычного ReLU некоторые нейроны умирают, а отследить умирание нейронов не просто. Чтобы решить эту проблему иногда используется подход ReLU с «утечкой» (leak) — график функции активации на отрицательных значениях образует не горизонтальную прямую, а наклонную, с маленьким угловым коэффициентом (порядка 0,01). То есть она может быть записана как . Такое небольшое отрицательное значение помогает добиться ненулевого градиента при отрицательных значениях. Однако, функция Leaky ReLU имеет некоторые недостатки:

- Сложнее считать производную, по сравнению со стандартным подходом (так как значения уже не равны нулю), что замедляет работу каждой эпохи.

- Угловой коэффициент прямой также является гиперпараметром, который надо настраивать.

- На практике, результат не всегда сильно улучшается относительно ReLU.

Стоит отметить, что помимо проблемы умирающих нейронов, у ReLU есть и другая — проблема затухающего градиента[на 03.01.20 не создан]. При слишком большом количестве слоев градиент будет принимать очень маленькое значение, постепенно уменьшаясь до нуля. Из-за этого нейронная сеть работает нестабильно и неправильно. Leaky ReLU (LReLU) решает первую проблему, но в по-настоящему глубоких сетях проблема затухания градиента все еще встречается и при использовании этого подхода.

На практике LReLU используется не так часто. Практический результат использования LReLU вместо ReLU отличается не слишком сильно. Однако в случае использования Leaky требуется дополнительно настраивать гиперпараметр (уровень наклона при отрицательных значениях), что требует определенных усилий. Еще одной проблемой является то, что результат LReLU не всегда лучше чем при использовании обычного ReLU, поэтому чаще всего такой подход используют как альтернатива. Довольно часто на практике используется PReLU (Parametric ReLU), который позволяет добиться более значительных улучшений по сравнению с ReLU и LReLU. Также, в случае параметрической модификации ReLU, угол наклона не является гиперпараметром и настраивается нейросетью.