Практики реализации нейронных сетей — различия между версиями

Sketcher (обсуждение | вклад) |

Sketcher (обсуждение | вклад) (Binary step function) |

||

| Строка 5: | Строка 5: | ||

{{Определение | {{Определение | ||

|definition= '''Функция активации''' (англ. ''activation function'') определяет выходной сигнал нейрона в зависимости от результата взвешенной суммы входов и порогового значения.}} | |definition= '''Функция активации''' (англ. ''activation function'') определяет выходной сигнал нейрона в зависимости от результата взвешенной суммы входов и порогового значения.}} | ||

| − | Рассмотрим нейрон Z с выходным значением < | + | Рассмотрим нейрон Z с выходным значением <tex>Z = \sum\limits_{i} w_{i}x_{i} + bias</tex>, где <tex>w_{i}</tex> и <tex>x_{i}</tex> {{---}} вес и входное значение <tex>i</tex>-ого входа, а <tex>bias</tex> {{---}} смещение. Полученный результат передается в функцию активации, которая решает рассматривать этот нейрон как активированный, или его можно игнорировать. |

| + | [[Файл:BinaryStepFunction.png|300px|thumb|right|Рис 1. Binary step function]] | ||

===Ступенчатая функция=== | ===Ступенчатая функция=== | ||

| + | Ступенчатая функция (англ. ''binary step function'') является пороговой функцией активации. | ||

| + | То есть если <tex>Z</tex> больше или меньше некоторого значения, то нейрон становится активированным. Такая функция отлично работает для бинарной классификации. | ||

| + | Но она не работает, когда для классификации требуется большее число нейронов и количество возможных классов больше двух. | ||

===Линейная функция=== | ===Линейная функция=== | ||

| Строка 16: | Строка 20: | ||

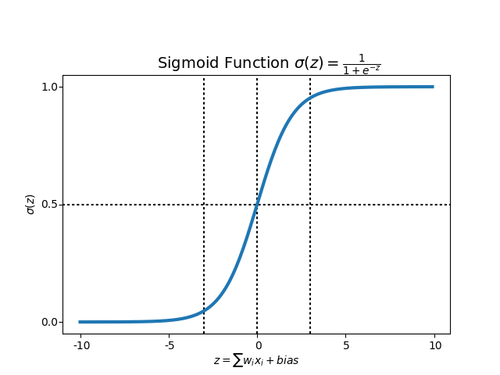

Для того, чтобы избежать данных проблем, в нейронных сетях используется сигмоидная функция в качестве активационной. Также ее еще называют логистической. | Для того, чтобы избежать данных проблем, в нейронных сетях используется сигмоидная функция в качестве активационной. Также ее еще называют логистической. | ||

| − | [[Файл:sigmoid_function.png|border|500px|thumb|center|Рис | + | [[Файл:sigmoid_function.png|border|500px|thumb|center|Рис 3. Sigmoid function]] |

Sigmoid функция, в отличие от ступенчатой функции, вводит нелинейность в выбранную модель нейронной сети. Нелинейность означает, что выход, получаемый из нейрона произведением некоторых входов <math>x (x_1, x_2, ..., x_m)</math> и весов <math>w (w_1, w_2, ..., w_m)</math> плюс смещение, преобразованный сигмоидной функцией, не может быть представлен линейной комбинацией его входных сигналов. | Sigmoid функция, в отличие от ступенчатой функции, вводит нелинейность в выбранную модель нейронной сети. Нелинейность означает, что выход, получаемый из нейрона произведением некоторых входов <math>x (x_1, x_2, ..., x_m)</math> и весов <math>w (w_1, w_2, ..., w_m)</math> плюс смещение, преобразованный сигмоидной функцией, не может быть представлен линейной комбинацией его входных сигналов. | ||

Версия 00:41, 26 февраля 2020

Содержание

Аугментация данных

Дропаут

Функции активации

Одним из важнейших аспектов глубокой нейронной сети являются функции активации.

| Определение: |

| Функция активации (англ. activation function) определяет выходной сигнал нейрона в зависимости от результата взвешенной суммы входов и порогового значения. |

Рассмотрим нейрон Z с выходным значением , где и — вес и входное значение -ого входа, а — смещение. Полученный результат передается в функцию активации, которая решает рассматривать этот нейрон как активированный, или его можно игнорировать.

Ступенчатая функция

Ступенчатая функция (англ. binary step function) является пороговой функцией активации. То есть если больше или меньше некоторого значения, то нейрон становится активированным. Такая функция отлично работает для бинарной классификации. Но она не работает, когда для классификации требуется большее число нейронов и количество возможных классов больше двух.

Линейная функция

Сигмоида

У ступенчатых функций есть определенное количество ограничений, связанных с ее линейностью. Если функция активации является линейной, то независимо от количества складываемых скрытых слоев в нейронной сети, конечный результат по-прежнему будет являться линейной комбинацией исходных входных данных. Эта линейность означает, что она не может реально охватить сложность нелинейных задач, таких как оператор XOR или различные паттерны, разделенные кривыми или кругами. Другой проблемой является то, что перцептрон со ступенчатой функцией не очень «стабилен», то есть может перейти из состояния 0 в 1 и из 0 в 1 при небольших изменениях в любом из весов входного слоя.

Для того, чтобы избежать данных проблем, в нейронных сетях используется сигмоидная функция в качестве активационной. Также ее еще называют логистической.

Sigmoid функция, в отличие от ступенчатой функции, вводит нелинейность в выбранную модель нейронной сети. Нелинейность означает, что выход, получаемый из нейрона произведением некоторых входов и весов плюс смещение, преобразованный сигмоидной функцией, не может быть представлен линейной комбинацией его входных сигналов.

ReLU

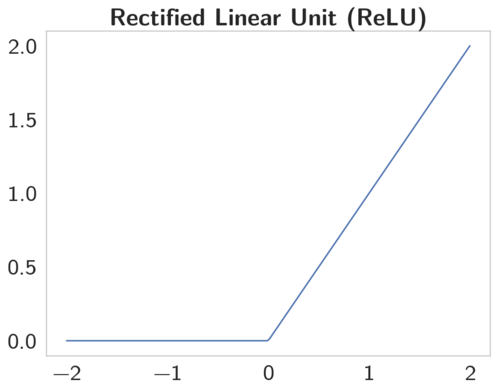

Несмотря на множество сильных сторон sigmoid функции, у нее есть значительные недостатки. Производная такой функции крайне мала во всех точках, кроме сравнительно небольшого промежутка. Это сильно усложняет процесс улучшения весов с помощью градиентного спуска. Эта проблема усугубляется в случае, если модель содержит больше слоев. Данная проблема называется проблемой исчезающего градиента.[1]

Функция ReLU имеет производную равную 0 для всех отрицательных значениях и 1 для положительных. Таким образом, когда обучение происходит на датасетах разумного размера, обычно находятся точки данных, дающие положительные значения для любого выбранного узла. Таким образом, средняя производная редко бывает близка к 0, что позволяет продолжать градиентный спуск.

Rectified Linear Unit — это наиболее часто используемая активационная функция при глубоком обучении. Данная функция возвращает 0, если принимает отрицательный вход, в случае же положительного входа, функция возвращает само число. Таким образом функция может быть записана как .

Функция ReLU отлично работает в большинстве приложений, в результате чего она получила широкое распространение. Данная функция позволяет правильно учитывать нелинейности и взаимодействия.