Дерево решений и случайный лес — различия между версиями

(→Постредукция (post-pruning)) |

|||

| Строка 69: | Строка 69: | ||

===Постредукция (post-pruning)=== | ===Постредукция (post-pruning)=== | ||

Постредукция (англ. ''post-pruning'') просматривает все внутренние вершины дерева и заменяет отдельные вершины либо одной из дочерних вершин (при этом вторая дочерняя удаляется), либо терминальной вершиной. Процесс замен продолжается до тех | Постредукция (англ. ''post-pruning'') просматривает все внутренние вершины дерева и заменяет отдельные вершины либо одной из дочерних вершин (при этом вторая дочерняя удаляется), либо терминальной вершиной. Процесс замен продолжается до тех | ||

| − | пор, пока в дереве остаются вершины, удовлетворяющие критерию замены. <br> | + | пор, пока в дереве остаются вершины, удовлетворяющие критерию замены. <br><br> |

| − | ''Критерием замены'' является сокращение числа ошибок на контрольной выборке, отобранной заранее, и не участвовавшей в обучении дерева. Стандартная рекомендация — оставлять в контроле около 30% объектов. <br> | + | ''Критерием замены'' является сокращение числа ошибок на контрольной выборке, отобранной заранее, и не участвовавшей в обучении дерева. Стандартная рекомендация — оставлять в контроле около 30% объектов. <br><br> |

Для реализации постредукции контрольная выборка <tex>X^k</tex> пропускается через | Для реализации постредукции контрольная выборка <tex>X^k</tex> пропускается через | ||

построенное дерево. При этом в каждой внутренней вершине <tex>v</tex> запоминается подмножество <tex>S_v \subseteq X_k</tex> попавших в неё контрольных объектов. Если <tex>S_v = \emptyset </tex>, то вершина <tex>v</tex> считается ненадёжной и заменяется терминальной по ''мажоритарному правилу'': <br> | построенное дерево. При этом в каждой внутренней вершине <tex>v</tex> запоминается подмножество <tex>S_v \subseteq X_k</tex> попавших в неё контрольных объектов. Если <tex>S_v = \emptyset </tex>, то вершина <tex>v</tex> считается ненадёжной и заменяется терминальной по ''мажоритарному правилу'': <br> | ||

| Строка 85: | Строка 85: | ||

* заменить поддерево вершины <tex>v</tex> поддеревом правой дочерней вершины <tex>R_v</tex>; | * заменить поддерево вершины <tex>v</tex> поддеревом правой дочерней вершины <tex>R_v</tex>; | ||

* заменить поддерево <tex>v</tex> терминальной вершиной класса <tex>y_v = \mathrm{arg}\min_{y\in Y}r_c(v) </tex>. | * заменить поддерево <tex>v</tex> терминальной вершиной класса <tex>y_v = \mathrm{arg}\min_{y\in Y}r_c(v) </tex>. | ||

| − | |||

== Деревья регрессии == | == Деревья регрессии == | ||

Версия 20:07, 20 января 2019

Содержание

Дерево решений

| Определение: |

Дерево решений (англ. decision tree, DT) — алгоритм классификации , задающийся деревом (связным ациклическим графом):

|

| Определение: |

Бинарное дерево решений — частный случай дерева решений, для которого .

|

Y classify(x): while : ((x)) ; return

Рекурсивный алгоритм построения бинарного дерева решений ID3

Идея алгоритма (англ. Induction of Decision Tree) заключается в последовательном дроблении выборки на две части до тех пор, пока в каждой части не окажутся объекты только одного класса. Проще всего записать этот алгоритм в виде рекурсивной процедуры , которая строит дерево по заданной подвыборке и возвращает его корневую вершину.

1:function ID3(): 2: if все объекты множества принадлежат одному классу then 3: создать новый лист 4: 5: return v 6: найти предикат с максимальной информативностью: I(, ) 7: разбить выборку на две части по предикату : 8: if или then 9: создать новый лист 10: = класс, в котором находится большинство объектов из 11: else 12: создать новую внутреннюю вершину 13: 14: = ID3() 15: = ID3() 16: return

Информативность

Критерий ветвления

Критейрий Джини

Энтропийный критерий

Рецукция решающих деревьев

Суть редукции состоит в удалении поддеревьев, имеющих недостаточную статистическую надёжность. При этом дерево перестаёт безошибочно классифицировать обучающую выборку, зато качество классификации новых объектов, как правило, улучшается. Рассмотрим наиболее простые варианты редукции.

Предредукция

Предредукция (англ. pre-pruning) или критерий раннего останова досрочно прекращает дальнейшее ветвление в вершине дерева, если информативность для всех возможных предикатов не дотягивает до заданного порогового значения .

Для этого на шаге 8 алгоритма условие или заменяется условием . Порог является управляющим параметром метода.

Предредукция считается не самым эффективным способом избежать переобучения, так как жадное ветвление по-прежнему остаётся глобально неоптимальным. Более эффективной считается cтратегия постредукции.

Постредукция (post-pruning)

Постредукция (англ. post-pruning) просматривает все внутренние вершины дерева и заменяет отдельные вершины либо одной из дочерних вершин (при этом вторая дочерняя удаляется), либо терминальной вершиной. Процесс замен продолжается до тех

пор, пока в дереве остаются вершины, удовлетворяющие критерию замены.

Критерием замены является сокращение числа ошибок на контрольной выборке, отобранной заранее, и не участвовавшей в обучении дерева. Стандартная рекомендация — оставлять в контроле около 30% объектов.

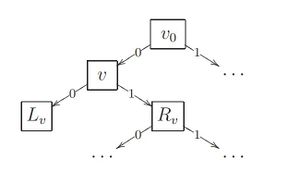

Для реализации постредукции контрольная выборка пропускается через

построенное дерево. При этом в каждой внутренней вершине запоминается подмножество попавших в неё контрольных объектов. Если , то вершина считается ненадёжной и заменяется терминальной по мажоритарному правилу:

в качестве берётся тот класс, объектов которого больше всего в обучающей подвыборке , пришедшей в вершину .

Затем для каждой внутренней вершины вычисляется число ошибок, полученных при классификации выборки следующими способами:

- — классификация поддеревом, растущим из вершины ;

- — классификация поддеревом левой дочерней вершины ;

- — классификация поддеревом правой дочерней вершины ;

- — отнесение всех объектов выборки к классу .

Эти величины сравниваются, и, в зависимости от того, какая из них оказалась

минимальной, принимается, соответственно, одно из четырёх решений:

- сохранить поддерево вершины ;

- заменить поддерево вершины поддеревом левой дочерней вершины ;

- заменить поддерево вершины поддеревом правой дочерней вершины ;

- заменить поддерево терминальной вершиной класса .

Деревья регрессии

Критерии ветвления

Оценивание вероятностей

Полужадный синтез

Алгоритмы построения решающих деревьев

Обобщающая способность решающих деревьев

Композиции решающих деревьев

- Решающий лес

- Бустинг над решающими деревьями

История

Ссылки

- Classification and Regression Trees — лекции Cosma Shalizi, ноябрь 2009.