Байесовские сети — различия между версиями

| Строка 121: | Строка 121: | ||

|author= | |author= | ||

|statement=Если <math>P</math> факторизуется над <math>G</math>, то <math>G</math> является картой независимостей для <math>P</math>. | |statement=Если <math>P</math> факторизуется над <math>G</math>, то <math>G</math> является картой независимостей для <math>P</math>. | ||

| + | |proof=Теорема является более формальной записью утверждения про <math>d</math>-разделимость выше, доказательство на примере из рисунка 2 приведено выше. | ||

}} | }} | ||

Версия 13:19, 18 марта 2019

| Определение: |

| Байесовская сеть (англ. Bayesian network) — это направленный ациклический граф , в котором каждой вершине поставлена в соответствие случайная переменная и каждое ребро представляет прямую зависимость от . Пусть , тогда в Байесовской сети каждой вершине графа должно быть сопоставлено распределение условных вероятностей от вершин из . |

Цепное правило для Байесовских сетей: Цепное правило позволяет разложить (факторизовать) совместное распределение в произведение условных распределений.

Содержание

Пример

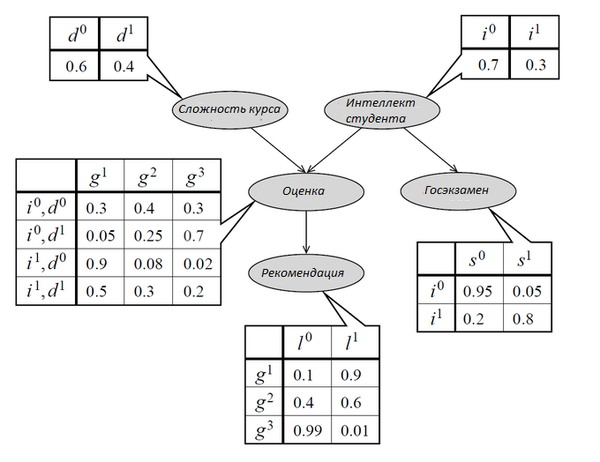

Байесовская сеть, представленная на рисунке 1, отображает следующие зависимости. Оценка студента (Grade) зависит от его интеллекта (Intelligence) и сложности курса (Difficulty). Студент просит у преподавателя рекомендательное письмо (Letter), предположим, что преподаватель может написать плохое или хорошее письмо в зависимости от оценки студента. Также студент сдаёт экзамен для поступления в колледж (SAT), результаты экзамена не зависят от письма преподавателя, оценки за его курс и сложности курса. Представление этой модели в Байесовской сети представлено на рисунке ниже.

С помощью цепного правила рассчитаем вероятность того, что умный студент получает B по лёгкому курсу, высокий балл по SAT и плохое рекомендательное письмо:

Байесовская сеть представляет допустимое вероятностное распределение:

- Вероятность исхода в Байесовской сети неотрицательна, так как вычисляется как произведение условных вероятностей событий, которые неотрицательны.

- Сумма вероятностей исходов в Байесовской сети равна единице:

Виды вероятностного вывода (англ. Reasoning Patterns)

Прямой вывод, или прогнозирование (англ. Causal Reasoning)

Прямой вывод — определение вероятности события при наблюдаемых причинах.

Пример к рисунку 1: вероятность получения хорошего рекомендательного письма, если известно, что студент обладает низким интеллектом, , если известно, что курс был лёгким, вероятность повысится, .

Обратный вывод, или диагностирование (англ. Evidential Reasoning)

Обратный вывод — определение вероятности причины при наблюдаемых следствиях.

Пример к рисунку 1: вероятность того, что курс сложный, если студент получил оценку С, , вероятность того, что студент умный, если он получил оценку С, .

Межпричинный (смешанный) вывод (англ. Intercausal Reasoning)

Межпричинный вывод — определение вероятности одной из причин наступившего события при условии наступления одной или нескольких других причин этого события.

Рассмотрим вероятность из прошлого примера, , вероятность того, что студент умный, слегка увеличивается, если также известно, что курс сложный, , сложность курса (D) и интеллект студента (I) не связаны ребром, рассмотрим, как получается, что они влияют друг на друга, на более простом примере.

Предположим, у пациента температура, это сильно повышает вероятность как простуды, так и отравления, хотя они не влияют друг на друга, но если станет известно, что пациент отравился, вероятность простуды сильно уменьшится, симптом уже объяснён одной из возможных причин, и вторая становится менее вероятной. Таким образом, если общее следствие получает означивание, причины становятся зависимыми. По-английски этот феномен называется «explaining away».

Пропагация вывода (англ. Flow of Probabilistic Influence)

Обобщим наблюдения из прошлой секции.

Свидетельства — утверждения вида «событие в узле x произошло».

влияет на , когда свидетельство может изменить распределение вероятностей Y.

Рассмотрим случаи, когда влияет на при имеющихся свидетельствах :

- Если вершины связаны непосредственно ( или ), всегда влияет на .

- — влияет на , если не принадлежит .

- (-образная структура) — влияет на , если или кто-либо из потомков принадлежит , и, соответственно, не влияет на , если или хотя бы кто-либо из потомков не принадлежит .

| Определение: |

Активные пути (англ. Active Trails) — путь активен при свидетельствах , если:

|

Условная независимость

| Определение: |

| Маргинальная вероятность — это безусловная вероятность события ; то есть, вероятность события , независимо от того, наступает ли какое-то другое событие или нет. Если о можно думать как о некоторой случайной величине, принявшей данной значение, маргинальная вероятность может быть получена суммированием (или более широко интегрированием) совместных вероятностей по всем значениям этой случайной величины. Эту процедуру иногда называют маргинализацией вероятности. На рисунке 1 вероятность того, что студент умный () является маргинальной, так как у вершины i нет родителей, с помощью маргинализации эту же вероятность можно получить сложив вероятности того, что студент умный, и он получит высокий балл по SAT, и того что, студент умный и получит низкий балл по SAT. |

| Определение: |

| и являются -разделёнными (англ. -separated), если в графе при означивании не существует активного пути между и . Обозначение: . |

| Определение: |

| факторизуется над , если |

| Определение: |

| — в вероятностном пространстве переменная не зависима от переменной при условии означивания переменной . Знак следует читать как "удовлетворяет". |

| Утверждение: |

, если , где — факторы, следует читать как "пропорционально". |

| Теорема: |

Если факторизуется над и , то . |

| Доказательство: |

|

Покажем на примере из рисунка 1: , — цепное правило, факторизуется над , .Значит, . |

| Утверждение: |

Если факторизуется над , то в каждая переменная -разделена (независима) от вершин, не являющихся её потомками, при означивании родителей. |

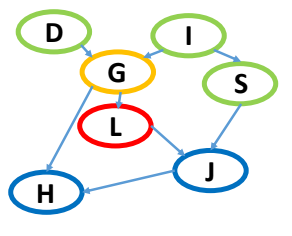

Рассмотрим пример на рисунке 2: Вершина от всех вершин, не являющихся её потомками, так как все пути от вершин, не являющихся потомками, проходят через , которая получила означивание, следовательно, такие пути неактивны, а пути, проходящие через или не являются активными, так как данные вершины не получили означивание и образуют -образную структуру.

| Определение: |

| , если , является картой независимостей для . — множество независимостей. |

| Теорема: |

Если факторизуется над , то является картой независимостей для . |

| Доказательство: |

| Теорема является более формальной записью утверждения про -разделимость выше, доказательство на примере из рисунка 2 приведено выше. |

| Теорема: |

Если является картой независимостей для , то факторизуется над . |

| Доказательство: |

|

— цепное правило для вероятностей, воспользуемся тем, что переменные независимы от вершин, не являющихся их потомками, при означивании родителей, получим: — цепное правило для байесовской сети. Значит факторизуется над . |

Применение

Байесовские сети используются в медицине, классификации документов, обработке изображений, обработке данных, системах поддержки принятия решений, моделирования в биоинформатике, для анализа текстов и сегментации.

Примечания

- https://www.coursera.org/lecture/probabilistic-graphical-models/semantics-factorization-trtai

- https://www.coursera.org/lecture/probabilistic-graphical-models/reasoning-patterns-KMjHs

- https://www.coursera.org/lecture/probabilistic-graphical-models/flow-of-probabilistic-influence-1eCp1

- https://www.coursera.org/lecture/probabilistic-graphical-models/conditional-independence-PTXfn

- https://www.coursera.org/lecture/probabilistic-graphical-models/independencies-in-bayesian-networks-JRkCU

См. также

Источники информации

- Andrew D. Gordon, Thomas A. Henzinger, Aditya V. Nori, and Sriram K. Rajamani. 2014. Probabilistic programming. In Proceedings of the on Future of Software Engineering (FOSE 2014). ACM, New York, NY, USA, 167-181. DOI=10.1145/2593882.2593900 doi.acm.org/10.1145/2593882.2593900