Генерация изображения по тексту — различия между версиями

Geny200 (обсуждение | вклад) м (bug fix) |

Geny200 (обсуждение | вклад) (Added MMVR) |

||

| Строка 8: | Строка 8: | ||

=== Some Name Here (Inferring Semantic Layout for Hierarchical Text-to-Image Synthesis) === | === Some Name Here (Inferring Semantic Layout for Hierarchical Text-to-Image Synthesis) === | ||

=== AttnGAN === | === AttnGAN === | ||

| − | Последние разработки исследователей в области автоматического создания изображений по текстовому описанию, основаны на [[Generative Adversarial Nets (GAN)|генеративных состязательных сетях (GANs)]].Общепринятый подход заключается в кодировании всего текстового описания в глобальное векторное пространство предложений (англ. global sentence vector). Такой подход демонстрирует ряд впечатляющих результатов, но у него есть главные недостатки: отсутствие чёткой детализации на уровне слов и невозможность генерации изображений высокого разрешения. Эта проблема становится еще более серьезной при генерации сложных кадров, таких как в наборе данных COCO<ref>[https://cocodataset.org COCO dataset (Common Objects in Context)]</ref>. | + | Последние разработки исследователей в области автоматического создания изображений по текстовому описанию, основаны на [[Generative Adversarial Nets (GAN)|генеративных состязательных сетях (GANs)]].Общепринятый подход заключается в кодировании всего текстового описания в глобальное векторное пространство предложений (англ. global sentence vector). Такой подход демонстрирует ряд впечатляющих результатов, но у него есть главные недостатки: отсутствие чёткой детализации на уровне слов и невозможность генерации изображений высокого разрешения. Эта проблема становится еще более серьезной при генерации сложных кадров, таких как в наборе данных COCO<ref name="COCO">[https://cocodataset.org COCO dataset (Common Objects in Context)]</ref>. |

В качестве решения данной проблемы была предложена<ref>[https://openaccess.thecvf.com/content_cvpr_2018/papers/Xu_AttnGAN_Fine-Grained_Text_CVPR_2018_paper.pdf Tao X., Pengchuan Z. {{---}} AttnGAN: Fine-Grained Text to Image Generationwith Attentional Generative Adversarial Networks, 2018] </ref> новая [[Generative Adversarial Nets (GAN)|генеративно-состязательная нейросеть]] с вниманием (англ. Attentional Generative Adversarial Network, AttnGAN), которая относится к вниманию как к фактору обучения, что позволяет выделять слова для генерации фрагментов изображения. | В качестве решения данной проблемы была предложена<ref>[https://openaccess.thecvf.com/content_cvpr_2018/papers/Xu_AttnGAN_Fine-Grained_Text_CVPR_2018_paper.pdf Tao X., Pengchuan Z. {{---}} AttnGAN: Fine-Grained Text to Image Generationwith Attentional Generative Adversarial Networks, 2018] </ref> новая [[Generative Adversarial Nets (GAN)|генеративно-состязательная нейросеть]] с вниманием (англ. Attentional Generative Adversarial Network, AttnGAN), которая относится к вниманию как к фактору обучения, что позволяет выделять слова для генерации фрагментов изображения. | ||

| Строка 19: | Строка 19: | ||

*Attentional Generative Network {{---}} самая большая сеть, состоящая из трех уровней. Каждый уровень порождает изображения все большего разрешения, от 64x64 до 256x256 пикселей, и результат работы на каждом уровне корректируется с помощью сетей внимания <math>F^{attn}</math>, которые несут в себе информацию о правильном расположении отдельных объектов сцены. Кроме того, результаты на каждом уровне проверяются тремя отдельно работающими дискриминаторами, которые оценивают реалистичность изображения и соответствие его общему представлению о сцене. | *Attentional Generative Network {{---}} самая большая сеть, состоящая из трех уровней. Каждый уровень порождает изображения все большего разрешения, от 64x64 до 256x256 пикселей, и результат работы на каждом уровне корректируется с помощью сетей внимания <math>F^{attn}</math>, которые несут в себе информацию о правильном расположении отдельных объектов сцены. Кроме того, результаты на каждом уровне проверяются тремя отдельно работающими дискриминаторами, которые оценивают реалистичность изображения и соответствие его общему представлению о сцене. | ||

| − | Благодаря модификациям нейросеть AttnGAN показывает значительно лучшие результаты, чем традиционные системы GAN. В частности, максимальный из известных показателей inception score<ref>[https://arxiv.org/abs/1801.01973 A Note on the Inception Score]</ref> для существующих нейросетей улучшен на 14,14% (с 3,82 до 4,36) на наборе данных CUB и улучшен на целых 170,25% (с 9,58 до 25,89)<ref>[https://paperswithcode.com/sota/text-to-image-generation-on-coco Test results {{---}} Text-to-Image Generation on COCO]</ref> на более сложном наборе данных COCO. | + | Благодаря модификациям нейросеть AttnGAN показывает значительно лучшие результаты, чем традиционные системы GAN. В частности, максимальный из известных показателей inception score<ref>[https://arxiv.org/abs/1801.01973 A Note on the Inception Score]</ref> для существующих нейросетей улучшен на 14,14% (с 3,82 до 4,36) на наборе данных CUB и улучшен на целых 170,25% (с 9,58 до 25,89)<ref>[https://paperswithcode.com/sota/text-to-image-generation-on-coco Test results {{---}} Text-to-Image Generation on COCO]</ref> на более сложном наборе данных COCO<ref name="COCO" />. |

<gallery mode="slideshow" caption="Пример результата работы AttnGAN"> | <gallery mode="slideshow" caption="Пример результата работы AttnGAN"> | ||

| Строка 43: | Строка 43: | ||

=== ChatPainter === | === ChatPainter === | ||

| − | В предыдущих и последующих моделях для создания изображений используются текстовые описания. Однако они могут быть недостаточно информативными, чтобы охватить все представленные изображения, и модели будет недостаточно данных для того чтобы сопоставить объекты на изображениях со словами в описании. Поэтому в качестве дополнительных данных предлагается использовать диалоги, которые дополнительно описывают сцены. Это приводит к значительному улучшению inception score и качества генерируемых изображений в наборе данных MS COCO (Microsoft COCO dataset)<ref>[https://www.microsoft.com/en-us/research/wp-content/uploads/2014/09/LinECCV14coco.pdf Microsoft COCO]</ref>. Для создания нового набора данных с диалогами, были объединены описания представленные в наборе данных MS COCO, с данными из Visual Dialog dataset (VisDial)<ref>[https://arxiv.org/abs/1611.08669 Visual Dialog]</ref>. | + | В предыдущих и последующих моделях для создания изображений используются текстовые описания. Однако они могут быть недостаточно информативными, чтобы охватить все представленные изображения, и модели будет недостаточно данных для того чтобы сопоставить объекты на изображениях со словами в описании. Поэтому в качестве дополнительных данных предлагается использовать диалоги, которые дополнительно описывают сцены. Это приводит к значительному улучшению inception score и качества генерируемых изображений в наборе данных MS COCO (Microsoft COCO dataset)<ref name="MSCOCO">[https://www.microsoft.com/en-us/research/wp-content/uploads/2014/09/LinECCV14coco.pdf Microsoft COCO]</ref>. Для создания нового набора данных с диалогами, были объединены описания представленные в наборе данных MS COCO<ref name="MSCOCO" />, с данными из Visual Dialog dataset (VisDial)<ref>[https://arxiv.org/abs/1611.08669 Visual Dialog]</ref>. |

<div class="oo-ui-panelLayout-scrollable" style="display: block; vertical-align:middle; height: auto; width: auto;">[[Файл: ChatPainter.png|thumb| alt=Архитектура ChatPainter|x350px|center| Архитектура ChatPainter: <ol style="list-style-type:lower-alpha"> | <div class="oo-ui-panelLayout-scrollable" style="display: block; vertical-align:middle; height: auto; width: auto;">[[Файл: ChatPainter.png|thumb| alt=Архитектура ChatPainter|x350px|center| Архитектура ChatPainter: <ol style="list-style-type:lower-alpha"> | ||

<li>Этап 1: модель генерирует изображение 64×64, по описанию и диалогу. </li> | <li>Этап 1: модель генерирует изображение 64×64, по описанию и диалогу. </li> | ||

| Строка 66: | Строка 66: | ||

{| class="wikitable" | {| class="wikitable" | ||

| − | |+ '''Inception scores для сгенерированных изображений в тестовом наборе MS COCO''' | + | |+ '''Inception scores для сгенерированных изображений в тестовом наборе MS COCO<ref name="MSCOCO" />''' |

|- | |- | ||

! Модель !! Inception Score | ! Модель !! Inception Score | ||

| Строка 80: | Строка 80: | ||

=== MMVR === | === MMVR === | ||

| + | [[Файл:MMVR.png|thumb|right|x360px|alt=Архитектура MMVR|Архитектура MMVR]] | ||

| + | Модель мультимодальной векторной сети (англ. Multi-Modal Vector Representation, MMVR), впервые предложенная в статье<ref>[https://arxiv.org/abs/1809.10274 Shagan S., Dheeraj P. {{---}} SEMANTICALLY INVARIANT TEXT-TO-IMAGE GENERATION, 2018]</ref>, способна создавать изображения по описанию и генерировать описание исходя из предоставленного изображения. Она включает несколько модификаций для улучшения генерации изображений и описаний, а именно: вводится [[Функция потерь и эмпирический риск|функция потерь]] на основе метрики N-грамм, которая обобщает описание относительно изображения; так же для генерации вместо одного используется несколько семантически сходных предложений, что так же улучшает создаваемые изображения. | ||

| + | |||

| + | Модель может быть разделена на два взаимозависимых модуля (см. рис): | ||

| + | *Генератор изображений на основе [[Generative Adversarial Nets (GAN)| GAN]] с DeePSiM<ref>[https://arxiv.org/abs/1602.02644 DeePSiM. Alexey D. and Thomas B. {{---}} Generating Images with Perceptual Similarity Metrics based on Deep Networks, 2016]</ref>. | ||

| + | *Генератор описаний изображений на основе Long-term [[Рекуррентные нейронные сети|Recurrent]] Convolutional Networks (LRCNs)<ref>[https://arxiv.org/abs/1411.4389 Jeff D., Lisa A. H. {{---}} Long-term Recurrent Convolutional Networks for Visual Recognition and Description, 2015]</ref>. | ||

| + | |||

| + | Прямое распространение (англ. forward pass) инициируется путем передачи случайного скрытого вектора (англ. latent vector) <tex>h_{t}</tex> в генератор изображений (<tex>G</tex>), который генерирует изображение <tex>\hat{x}</tex>. Затем по сгенерированной картинке генератор описаний создаёт подпись. Для определения ошибки между сгенерированным описанием <tex>\hat{y}</tex> и исходным описанием <tex>y</tex> используется перекрестная энтропия на уровне слов. Она используется для итеративного обновления <tex>h_{t}</tex> (заодно и <tex>\hat{x}</tex>), оставляя при этом все остальные компоненты фиксированными. С каждой итерацией <tex>\hat{y}</tex> приближается к < tex>y</tex>, и сгенерированное изображение на каждом шаге <tex>\hat{x}</tex> является временным представлением конечного изображения. Для улучшения реалистичности изображения используется энкодер шумоподавленя (англ. Denoising Autoencoder, DAE)<ref name="PPGN">[https://arxiv.org/abs/1612.00005 Anh N., Jeff C. {{---}} Plug & Play Generative Networks: Conditional Iterative Generation of Images in Latent Space]</ref> {{---}} в правило обновления добавляется ошибка восстановления изображения (англ. reconstruction error), вычисляемая как разница между <tex>h_{t}</tex> и <tex>\hat{h_{t}}</tex>. | ||

| + | [[файл:MMVR_example.png|thumb|left|x190px|Сравнение PPGN<ref name="PPGN" /> и MMVR]] | ||

| + | Обучение начинается с генерации случайного 4096-мерного вектора <tex>h_{t}</tex>, который передаётся в модель для последующего итеративного обновления. Процесс завершается после 200 итераций, и полученное изображение считается репрезентативным для данного описания. | ||

| + | {| class="wikitable" | ||

| + | |+ '''Inception scores для сгенерированных изображений в тестовом наборе MS COCO<ref name="MSCOCO" />''' | ||

| + | |- | ||

| + | ! Модель !! Inception Score | ||

| + | |- | ||

| + | | style = "text-align: right" | Plug and Play Generative Networks (PPGN)<ref name="PPGN" /> || style = "text-align: center" | <tex>6.71 \pm 0.45</tex> | ||

| + | |- | ||

| + | | style = "text-align: right" | MMVR || style = "text-align: center" | <tex>7.22 \pm 0.81</tex> | ||

| + | |- | ||

| + | | style = "text-align: right" | MMVR (<tex>N_{c}=5</tex>)|| style = "text-align: center" | <tex>8.30 \pm 0.78</tex> | ||

| + | |}MMVR (<tex>N_{c}</tex>) {{---}} модификация MMVR с несколькими текстовыми описаниями на изображение, где <tex>N_{c}</tex> - количество описаний. | ||

| + | |||

=== FusedGAN === | === FusedGAN === | ||

=== MirrorGAN === | === MirrorGAN === | ||

Версия 21:48, 9 января 2021

Автоматический синтез реалистичных изображений из текста был бы интересен и довольно полезен, но современные системы искусственного интеллекта все еще далеки от этой цели. Однако в последние годы были разработаны универсальные и мощные рекуррентные архитектуры нейронных сетей для изучения различных представлений текстовых признаков. Между тем, глубокие сверточные генеративные состязательные сети (англ. Generative Adversarial Nets, GANs) начали генерировать весьма убедительные изображения определенных категорий, таких как лица, обложки альбомов и интерьеры комнат. Мы рассмотрим глубокую архитектуру и формулировку GAN, объединим достижения в моделировании текста и изображений, переводя визуальные концепции из символов в пиксели.

Содержание

- 1 GAN

- 1.1 DCGAN

- 1.2 Attribute2Image

- 1.3 StackGAN

- 1.4 StackGAN++

- 1.5 Some Name Here (Inferring Semantic Layout for Hierarchical Text-to-Image Synthesis)

- 1.6 AttnGAN

- 1.7 Stacking VAE and GAN

- 1.8 ChatPainter

- 1.9 MMVR

- 1.10 FusedGAN

- 1.11 MirrorGAN

- 1.12 Obj-GANs

- 1.13 LayoutVAE

- 1.14 TextKD-GAN

- 1.15 MCA-GAN

- 1.16 LeicaGAN

- 2 Области применения

- 3 См. также

- 4 Примечания

- 5 Источники информации

GAN

DCGAN

Attribute2Image

StackGAN

StackGAN++

Some Name Here (Inferring Semantic Layout for Hierarchical Text-to-Image Synthesis)

AttnGAN

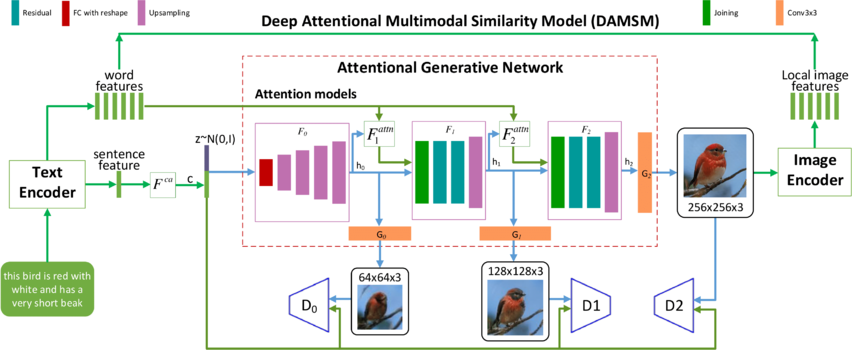

Последние разработки исследователей в области автоматического создания изображений по текстовому описанию, основаны на генеративных состязательных сетях (GANs).Общепринятый подход заключается в кодировании всего текстового описания в глобальное векторное пространство предложений (англ. global sentence vector). Такой подход демонстрирует ряд впечатляющих результатов, но у него есть главные недостатки: отсутствие чёткой детализации на уровне слов и невозможность генерации изображений высокого разрешения. Эта проблема становится еще более серьезной при генерации сложных кадров, таких как в наборе данных COCO[1].

В качестве решения данной проблемы была предложена[2] новая генеративно-состязательная нейросеть с вниманием (англ. Attentional Generative Adversarial Network, AttnGAN), которая относится к вниманию как к фактору обучения, что позволяет выделять слова для генерации фрагментов изображения.

Модель состоит из нескольких взаимодействующих нейросетей:

- Энкодер текста (англ. Text Encoder) и изображения (англ. Image Encoder) векторизуют исходное текстовое описания и реальные изображения. В данном случае текст рассматривается в виде последовательности отдельных слов, представление которых обрабатывается совместно с представлением изображения, что позволяет сопоставить отдельные слова отдельным частям изображения. Таким образом реализуется механизм внимания (англ. Deep Attentional Multimodal Similarity Model, DAMSM).

- — создает сжатое представление об общей сцене на изображении, исходя из всего текстового описания. Значение на выходе конкатенируется с вектором из нормального распределения , который задает вариативность сцены. Эта информация является основой для работы генератора.

- Attentional Generative Network — самая большая сеть, состоящая из трех уровней. Каждый уровень порождает изображения все большего разрешения, от 64x64 до 256x256 пикселей, и результат работы на каждом уровне корректируется с помощью сетей внимания , которые несут в себе информацию о правильном расположении отдельных объектов сцены. Кроме того, результаты на каждом уровне проверяются тремя отдельно работающими дискриминаторами, которые оценивают реалистичность изображения и соответствие его общему представлению о сцене.

Благодаря модификациям нейросеть AttnGAN показывает значительно лучшие результаты, чем традиционные системы GAN. В частности, максимальный из известных показателей inception score[3] для существующих нейросетей улучшен на 14,14% (с 3,82 до 4,36) на наборе данных CUB и улучшен на целых 170,25% (с 9,58 до 25,89)[4] на более сложном наборе данных COCO[1].

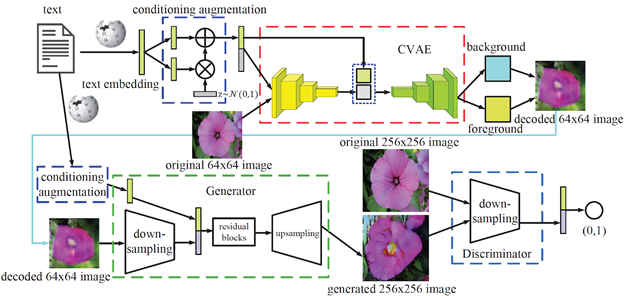

Stacking VAE and GAN

Большинство существующих методов генерации изображения по тексту нацелены на создание целостных изображений, которые не разделяют передний и задний план изображений, в результате чего объекты искажаются фоном. Более того, они обычно игнорируют взаимодополняемость различных видов генеративных моделей. Данное решение[5] предлагает контекстно-зависимый подход к генерации изображения, который разделяет фон и передний план. Для этого используется взаимодополняющая связка вариационного автокодировщика (англ. Variational Autoencoder, VAE) и генеративно-состязательной нейросети.

VAE считается более устойчивым чем GAN, это можно использовать для достоверной подборки распределения и выявления разнообразия исходного изображения. Однако он не подходит для генерации изображений высокого качества, т. к. генерируемые VAE изображения легко размываются. Чтобы исправить данный недостаток архитектура включает два компонента:

- Контекстно-зависимый вариационный кодировщик (англ. conditional VAE, CVAE) используется для захвата основной компоновки и цвета, разделяя фон и передний план изображения.

- GAN уточняет вывод CVAE с помощью состязательного обучения, которое восстанавливает потерянные детали и исправляет дефекты для создания реалистичного изображения.

Полученные результаты проверки на 2 наборах данных (CUB и Oxford-102[6]) эмпирически подтверждают эффективность предложенного метода.

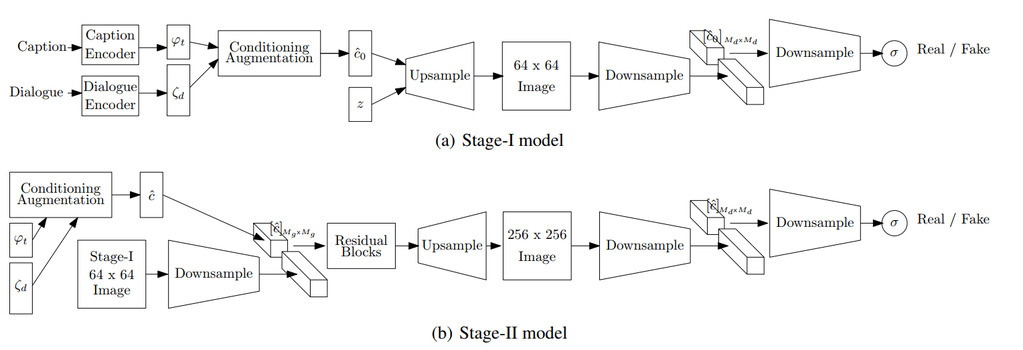

ChatPainter

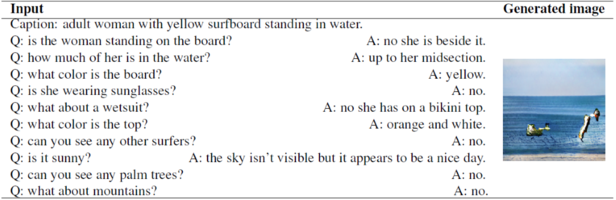

В предыдущих и последующих моделях для создания изображений используются текстовые описания. Однако они могут быть недостаточно информативными, чтобы охватить все представленные изображения, и модели будет недостаточно данных для того чтобы сопоставить объекты на изображениях со словами в описании. Поэтому в качестве дополнительных данных предлагается использовать диалоги, которые дополнительно описывают сцены. Это приводит к значительному улучшению inception score и качества генерируемых изображений в наборе данных MS COCO (Microsoft COCO dataset)[7]. Для создания нового набора данных с диалогами, были объединены описания представленные в наборе данных MS COCO[7], с данными из Visual Dialog dataset (VisDial)[8].

Данная архитектура (см. рис) опирается на модель StackGAN. StackGAN генерирует изображение в два этапа: Stage-I генерирует грубое изображение 64×64, а Stage-II генерирует улучшенное изображение 256×256.

Формирование вектора описаний происходит путем кодирования подписей с помощью предварительно обученного энкодера[9]. Для генерации диалоговых вложений используется два метода:

- Не рекурсивный энкодер — сжимает весь диалог в одну строку и кодирует его с помощью предварительно обученного энкодера Skip-Thought[10].

- Рекурсивный энкодер — генерирует Skip-Thought векторы (англ. Skip-Thought Vectors)[11] для каждого сообщения в диалоге, а затем кодирует их двунаправленной рекуррентной нейронной сетью c LSTM

Затем выходы описаний и диалогов объединяются и передаются в качестве входных данных в модуль аугментации данных (англ. Conditioning Augmentation, CA). Модуль CA нужен для получения скрытых скрытые условных переменных, которые передаются на вход генератору. Архитектура блоков upsample, downsample и residual blocks сохраняется такой же, как и у исходного StackGAN

Результаты тестирования и сравнение модели ChatPainter с другими приведены в таблице. Из неё видно, что модель ChatPainter, которая получает дополнительную диалоговую информацию, имеет более высокий Inception Score, в отличии от модели StackGAN. Кроме того, рекурсивная версия ChatPainter получилась лучше, чем не рекурсивная версия. Вероятно, это связано с тем, что в не рекурсивной версии энкодер не обучается на длинных предложениях сворачивая весь диалог в одну строку.

| Модель | Inception Score |

|---|---|

| StackGAN | |

| ChatPainter (non-recurrent) | |

| ChatPainter (recurrent) | |

| AttnGAN |

MMVR

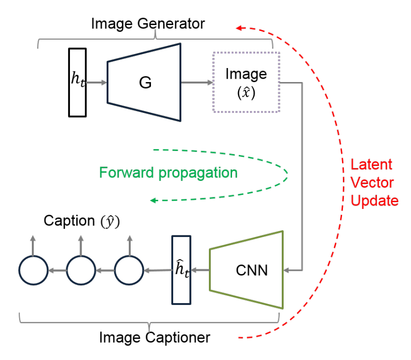

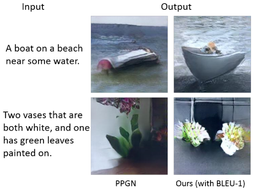

Модель мультимодальной векторной сети (англ. Multi-Modal Vector Representation, MMVR), впервые предложенная в статье[12], способна создавать изображения по описанию и генерировать описание исходя из предоставленного изображения. Она включает несколько модификаций для улучшения генерации изображений и описаний, а именно: вводится функция потерь на основе метрики N-грамм, которая обобщает описание относительно изображения; так же для генерации вместо одного используется несколько семантически сходных предложений, что так же улучшает создаваемые изображения.

Модель может быть разделена на два взаимозависимых модуля (см. рис):

- Генератор изображений на основе GAN с DeePSiM[13].

- Генератор описаний изображений на основе Long-term Recurrent Convolutional Networks (LRCNs)[14].

Прямое распространение (англ. forward pass) инициируется путем передачи случайного скрытого вектора (англ. latent vector) в генератор изображений (), который генерирует изображение . Затем по сгенерированной картинке генератор описаний создаёт подпись. Для определения ошибки между сгенерированным описанием и исходным описанием используется перекрестная энтропия на уровне слов. Она используется для итеративного обновления (заодно и ), оставляя при этом все остальные компоненты фиксированными. С каждой итерацией приближается к < tex>y</tex>, и сгенерированное изображение на каждом шаге является временным представлением конечного изображения. Для улучшения реалистичности изображения используется энкодер шумоподавленя (англ. Denoising Autoencoder, DAE)[15] — в правило обновления добавляется ошибка восстановления изображения (англ. reconstruction error), вычисляемая как разница между и .

Обучение начинается с генерации случайного 4096-мерного вектора , который передаётся в модель для последующего итеративного обновления. Процесс завершается после 200 итераций, и полученное изображение считается репрезентативным для данного описания.

| Модель | Inception Score |

|---|---|

| Plug and Play Generative Networks (PPGN)[15] | |

| MMVR | |

| MMVR () |

FusedGAN

MirrorGAN

Obj-GANs

LayoutVAE

TextKD-GAN

MCA-GAN

LeicaGAN

Области применения

- Создание контента и данных

- Картинки для интернет-магазина

- Аватары для игр

- Видеоклипы, сгенерированные автоматически, исходя из музыкального бита произведения

- Виртуальные ведущие[16]

- Благодаря работе генеративных моделей возникает синтез данных, на которых потом могут обучаться другие системы

- Генерации реалистичного видео городской среды[17]

См. также

Примечания

- ↑ 1,0 1,1 COCO dataset (Common Objects in Context)

- ↑ Tao X., Pengchuan Z. — AttnGAN: Fine-Grained Text to Image Generationwith Attentional Generative Adversarial Networks, 2018

- ↑ A Note on the Inception Score

- ↑ Test results — Text-to-Image Generation on COCO

- ↑ Chenrui Z., Yuxin P. — Stacking VAE and GAN for Context-awareText-to-Image Generation, 2018

- ↑ Oxford Flowers 102 dataset

- ↑ 7,0 7,1 7,2 7,3 Microsoft COCO

- ↑ Visual Dialog

- ↑ Pre-trained encoder for ICML 2016 paper

- ↑ Skip-Thought encoder

- ↑ Skip-Thought Vectors

- ↑ Shagan S., Dheeraj P. — SEMANTICALLY INVARIANT TEXT-TO-IMAGE GENERATION, 2018

- ↑ DeePSiM. Alexey D. and Thomas B. — Generating Images with Perceptual Similarity Metrics based on Deep Networks, 2016

- ↑ Jeff D., Lisa A. H. — Long-term Recurrent Convolutional Networks for Visual Recognition and Description, 2015

- ↑ 15,0 15,1 15,2 Anh N., Jeff C. — Plug & Play Generative Networks: Conditional Iterative Generation of Images in Latent Space

- ↑ Виртуальный диктор

- ↑ NVIDIA Interactive Graphics

Источники информации

- Scott R. — Generative Adversarial Text to Image Synthesis, 2016

- Xinchen Y. — Conditional Image Generation from Visual Attributes, 2015

- Han Z., Tao X. — Text to Photo-realistic Image Synthesis with Stacked Generative Adversarial Networks, 2017

- Han Z., Tao X. — Realistic Image Synthesis with Stacked Generative Adversarial Networks, 2018

- Seunghoon H., Dingdong Y. — Inferring Semantic Layout for Hierarchical Text-to-Image Synthesis, 2018

- Tao X., Pengchuan Z. — Fine-Grained Text to Image Generationwith Attentional Generative Adversarial Networks, 2018

- Chenrui Z., Yuxin P. — Stacking VAE and GAN for Context-awareText-to-Image Generation, 2018

- Shikhar S., Dendi S. — ChatPainter: Improving Text to Image Generation using Dialogue, 2018

- Shagan S., Dheeraj P. — SEMANTICALLY INVARIANT TEXT-TO-IMAGE GENERATION, 2018

- Navaneeth B., Gang H. — Semi-supervised FusedGAN for ConditionalImage Generation, 2018

- Tingting Q., Jing Z. — MirrorGAN: Learning Text-to-image Generation by Redescription, 2019

- Wendo L., Pengchuan Z. — Object-driven Text-to-Image Synthesis via Adversarial Training 2019

- Akash A.J., Thibaut D. — LayoutVAE: Stochastic Scene Layout Generation From a Label Set, 2019

- Md. Akmal H. and Mehdi R. — TextKD-GAN: Text Generation using Knowledge Distillation and Generative Adversarial Networks, 2019

- Bowen L., Xiaojuan Q. — MCA-GAN: Text-to-Image Generation Adversarial NetworkBased on Multi-Channel Attention, 2019

- Tingting Q., Jing Z. — Learn, Imagine and Create: Text-to-Image Generation from Prior Knowledge, 2019

- Анатолий А. — Генерация изображений из текста с помощью AttnGAN, 2018