Диалоговые системы — различия между версиями

Rot (обсуждение | вклад) (Метки: правка с мобильного устройства, правка из мобильной версии) |

Rot (обсуждение | вклад) (Метки: правка с мобильного устройства, правка из мобильной версии) |

||

| Строка 10: | Строка 10: | ||

'''Домен (англ. domain)''' {{---}} область знаний, которая относится к запросу пользователя. | '''Домен (англ. domain)''' {{---}} область знаний, которая относится к запросу пользователя. | ||

}} | }} | ||

| + | |||

| + | Часто целеориентированные и чат-ориентированные системы исследуют отдельно, но на практике многие системы являются универсальными. Схема идеальной универсальной модели диалоговой системы приведена на рисунке 1. | ||

| + | |||

| + | [[Файл : Perfect-n2n.png | 200px | thumb | right | Рисунок 1. Схема идеальной диалоговой системы]] | ||

| + | |||

| + | История диалога используется, чтобы обратиться к множеству внешних источников инфомрации. Затем формируется полный контекст диалога, который включает персональные данные пользователя, информацию из внешних источников, историю диалога. Контекст при помощи трансформера структурируется и передается множеству компонентов, которые решают определенные задачи. Набор полученных ответов кодируется и ранжируется с учетом контекста. | ||

== Целеориентированные диалоговые системы == | == Целеориентированные диалоговые системы == | ||

| Строка 17: | Строка 23: | ||

=== Классическая архитектура === | === Классическая архитектура === | ||

| − | Классический метод построения целеориентированных систем заключается в использовании цепочки модулей (пайплайна), которая изображена на рисунке | + | Классический метод построения целеориентированных систем заключается в использовании цепочки модулей (пайплайна), которая изображена на рисунке 2. |

[[Файл : Ds-pipeline-to.png | 400px | thumb | right | | [[Файл : Ds-pipeline-to.png | 400px | thumb | right | | ||

| − | Рисунок | + | Рисунок 2. Диаграмма классической архитектуры диалоговой системы]] |

* '''ASR'''. На вход поступает речь пользователя, которая затем распознается и переводится в текст. Результат работы компонента называют ''гипотезой'', так как полученный текст может соответствовать исходному сообщению не полностью. | * '''ASR'''. На вход поступает речь пользователя, которая затем распознается и переводится в текст. Результат работы компонента называют ''гипотезой'', так как полученный текст может соответствовать исходному сообщению не полностью. | ||

| Строка 35: | Строка 41: | ||

{{Определение | definition= | {{Определение | definition= | ||

| − | '''Именованная сущность (англ. named entity)''' {{---}} слово во фразе пользователя, которое можно отнести к определенному типу. | + | '''Именованная сущность (англ. named entity)''' {{---}} слово во фразе пользователя, которое можно отнести к определенному типу.<br /> |

| − | |||

'''Слот (англ. named entity)''' {{---}} параметр запроса пользователя, ограниченный множеством допустимых значений. | '''Слот (англ. named entity)''' {{---}} параметр запроса пользователя, ограниченный множеством допустимых значений. | ||

}} | }} | ||

Обычно после распознавания именованных сущностей выполняется ''заполнение слотов'' (англ. slot filling), в ходе которого каждая найденная сущность приводится к своей нормальной форме с учетом ее типа и множества возможных значений. Заполнение слотов позволяет не учитывать морфологию сущности при дальнейшей ее обработке. Простейшим подходом к решению данной задачи является поиск с использованием расстояния Левенштейна. | Обычно после распознавания именованных сущностей выполняется ''заполнение слотов'' (англ. slot filling), в ходе которого каждая найденная сущность приводится к своей нормальной форме с учетом ее типа и множества возможных значений. Заполнение слотов позволяет не учитывать морфологию сущности при дальнейшей ее обработке. Простейшим подходом к решению данной задачи является поиск с использованием расстояния Левенштейна. | ||

| + | |||

| + | Для получения эмбеддингов используются различные языковые модели: Word2Vec, ESIM, GPT, BERT. Хорошей языковой модели достаточно около 100 примеров для хорошей классификации намерения <ref> https://www.slideshare.net/KonstantinSavenkov/nlu-intent-detection-benchmark-by-intento-august-2017 </ref> | ||

Система с классической архитектурой плохо масштабируется. Так как сценарии диалога нужно определять вручную, их становится сложно согласовывать при большом количестве. | Система с классической архитектурой плохо масштабируется. Так как сценарии диалога нужно определять вручную, их становится сложно согласовывать при большом количестве. | ||

| Строка 46: | Строка 53: | ||

=== Нейросетевая архитектура === | === Нейросетевая архитектура === | ||

| − | Если заменить каждую часть классической архитектуры искусственной нейронной сетью, то получим архитектуру изображенную на рисунке | + | Если заменить каждую часть классической архитектуры искусственной нейронной сетью, то получим архитектуру изображенную на рисунке 3. |

| − | [[Файл : Ds-nn-to.png | 400px | thumb | right | Рисунок | + | [[Файл : Ds-nn-to.png | 400px | thumb | right | Рисунок 3. Нейросетевая архитектура диалоговой системы]] |

| − | * '''Intent Network'''. Кодирующая сеть, которая преобразует последовательность токенов <tex> w_0^t, w_1^t, \ldots, w_N^t </tex> в вектор <tex> \mathbf{z}_t </tex>. В качестве вектора <tex> \mathbf{z}_t </tex> может выступать скрытый слой LSTM-сети <tex> \mathbf{z}_t^N </tex>:<br /> | + | * '''Intent Network'''. Кодирующая сеть, которая преобразует последовательность токенов <tex> w_0^t, w_1^t, \ldots, w_N^t </tex> в вектор <tex> \mathbf{z}_t </tex>. В качестве вектора <tex> \mathbf{z}_t </tex> может выступать скрытый слой LSTM-сети <tex> \mathbf{z}_t^N </tex>:<br /> <tex> \mathbf{z}_t = \mathbf{z}_t^N = \operatorname{LSTM}(w_0^t, w_1^t, ..., w_N^t) </tex> |

| − | |||

* '''Belief Tracker'''. В реализации используется RNN-сеть. Дает распределение вероятностей <tex> \mathbf{p}_s^t </tex> по всем значениям определенного слота <tex> s </tex>. | * '''Belief Tracker'''. В реализации используется RNN-сеть. Дает распределение вероятностей <tex> \mathbf{p}_s^t </tex> по всем значениям определенного слота <tex> s </tex>. | ||

| Строка 57: | Строка 63: | ||

* '''Database Operator'''. Выполняет запрос к базе данных по сущностям <tex> \{ \operatorname{argmax} \mathbf{p}_s^t \} </tex> и возвращает вектор <tex> \mathbf{x}_t </tex>, где единицей отмечается та запись (сущность в БД), которая соответствует запросу. | * '''Database Operator'''. Выполняет запрос к базе данных по сущностям <tex> \{ \operatorname{argmax} \mathbf{p}_s^t \} </tex> и возвращает вектор <tex> \mathbf{x}_t </tex>, где единицей отмечается та запись (сущность в БД), которая соответствует запросу. | ||

| − | * '''Policy network'''. Объединяет системные модули. Выходом является вектор <tex> \mathbf{o}_t </tex>, который представляет системное действие. Распределение вероятностей для каждого слота <tex> \mathbf{p}_s^t </tex> пребразуется в вектор <tex> | + | * '''Policy network'''. Объединяет системные модули. Выходом является вектор <tex> \mathbf{o}_t </tex>, который представляет системное действие. Распределение вероятностей для каждого слота <tex> \mathbf{p}_s^t </tex> пребразуется в вектор <tex> \mathbf{\hat p}_s^t </tex>, который состоит из трех компонент: суммарная вероятность, вероятность, что пользователь выразил безразличие к слоту, и вероятность, что слот не был упомянут. Также вектор <tex> \mathbf{x}_t </tex> сжимается в one-hot-вектор <tex> \mathbf{\hat x}_t </tex>, где каждая компонента определяет количество подходящих записей.<br /> <tex> \mathbf{o}_t = \tanh(W_{zo} \mathbf{z}_t + W_{po} \mathbf{\hat p}_t + W_{xo} \mathbf{\hat x}_t), </tex> <br /> где матрицы <tex> W_{zo} </tex>, <tex>W_{po} </tex> и <tex> W_{xo} </tex> {{---}} параметры, а <tex> \mathbf{\hat p}_t = \bigoplus \mathbf{\hat p}_s^t </tex> {{---}} конкатенация. |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | * '''Generation Network'''. Генерирует предложение, используя вектор действия <tex> \mathbf{o}_t </tex> и генератор языка. Предложение содержит специальные токены, которые заменяются на сущности из базы данных по указателю. | |

| − | + | Данную архитектуру также называют сквозной (англ. end-to-end trainable), так как на данных обучается каждая ее часть. Для модели с данной архитектурой не требуется создавать промежуточные состояния вручную, а также ее можно обобщить на намерения, которые не наблюдались во время обучения. | |

| − | + | == Чат-ориентированные диалоговые системы === | |

| − | |||

| − | |||

=== С ограниченными ответами === | === С ограниченными ответами === | ||

| − | С генерацией ответов | + | === С генерацией ответов === |

| − | Примеры систем | + | == Примеры диалоговых систем == |

ELIZA | ELIZA | ||

| Строка 143: | Строка 98: | ||

== Другое == | == Другое == | ||

| − | Языковые модели: | + | Языковые модели: . |

| − | |||

== См. также == | == См. также == | ||

Версия 03:18, 19 января 2021

Содержание

Определение

Диалоговые системы (англ. conversational agents, CA) — компьютерные системы, предназначенные для общения с человеком. Они имитируют поведение человека и обеспечивают естественный способ получения информации, что позволяет значительно упростить руководство пользователя и тем самым повысить удобство взаимодействия с такими системами.

Диалоговую систему также называют разговорным искусственным интеллектом или просто ботом.

Диалоговая система может в разной степени являться целеориентированной системой (англ. goal/task-oriented) или чат-ориентированной (англ. chat-oriented). Как правило, чат-ориентированные системы, в отличие от целеориентированных, поддерживают большое количество доменов, но не способны различать много вопросов в рамках кажного из них.

| Определение: |

| Домен (англ. domain) — область знаний, которая относится к запросу пользователя. |

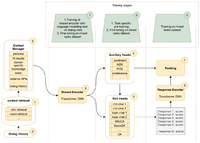

Часто целеориентированные и чат-ориентированные системы исследуют отдельно, но на практике многие системы являются универсальными. Схема идеальной универсальной модели диалоговой системы приведена на рисунке 1.

История диалога используется, чтобы обратиться к множеству внешних источников инфомрации. Затем формируется полный контекст диалога, который включает персональные данные пользователя, информацию из внешних источников, историю диалога. Контекст при помощи трансформера структурируется и передается множеству компонентов, которые решают определенные задачи. Набор полученных ответов кодируется и ранжируется с учетом контекста.

Целеориентированные диалоговые системы

Задачей целеориентированных систем является достижение определенных целей при помощи общения с пользователем. Примером цели может быть поиск книги или включение света.

Классическая архитектура

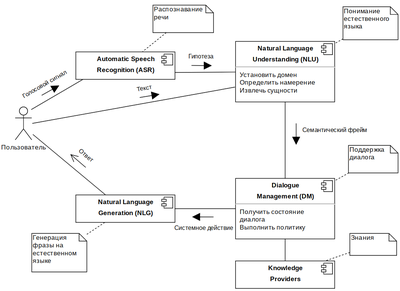

Классический метод построения целеориентированных систем заключается в использовании цепочки модулей (пайплайна), которая изображена на рисунке 2.

- ASR. На вход поступает речь пользователя, которая затем распознается и переводится в текст. Результат работы компонента называют гипотезой, так как полученный текст может соответствовать исходному сообщению не полностью.

- NLU. Фраза в текстовом виде анализируется системой: определяется домен, намерение, именованные сущности. Для распознавания намерений может применяться обученный на эмбеддингах классификатор. Распознавание именованных сущеностей является отдельной задачей извлечения информации. Для ее решения используются формальные языки, статистические модели и их комбинация. В результате работы компонента создается формальное описание фразы — семантический фрейм.

- DM. Состоянием диалога или контекстом является информация, которая была получена при общении с пользователем ранее. В соответствии с текущим состоянием выбирается политика поведения системы, корректируется семантический фрейм. В качестве поставщика знаний может выступать СУБД или Web API.

- NLG. В соответствии с выбранным действием осуществляется генерация ответа пользователю на естественном языке. Для генерации применяются генеративные модели или шаблоны.

| Определение: |

| Намерение (англ. intent) — желание пользователя в рамках произесенной фразы. |

| Определение: |

| Именованная сущность (англ. named entity) — слово во фразе пользователя, которое можно отнести к определенному типу. Слот (англ. named entity) — параметр запроса пользователя, ограниченный множеством допустимых значений. |

Обычно после распознавания именованных сущностей выполняется заполнение слотов (англ. slot filling), в ходе которого каждая найденная сущность приводится к своей нормальной форме с учетом ее типа и множества возможных значений. Заполнение слотов позволяет не учитывать морфологию сущности при дальнейшей ее обработке. Простейшим подходом к решению данной задачи является поиск с использованием расстояния Левенштейна.

Для получения эмбеддингов используются различные языковые модели: Word2Vec, ESIM, GPT, BERT. Хорошей языковой модели достаточно около 100 примеров для хорошей классификации намерения [1]

Система с классической архитектурой плохо масштабируется. Так как сценарии диалога нужно определять вручную, их становится сложно согласовывать при большом количестве.

Нейросетевая архитектура

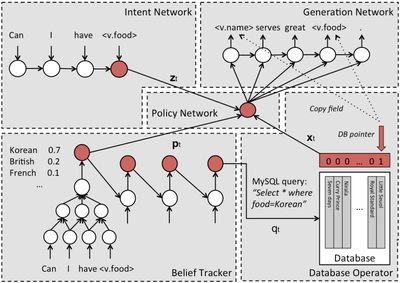

Если заменить каждую часть классической архитектуры искусственной нейронной сетью, то получим архитектуру изображенную на рисунке 3.

- Intent Network. Кодирующая сеть, которая преобразует последовательность токенов в вектор . В качестве вектора может выступать скрытый слой LSTM-сети :

- Belief Tracker. В реализации используется RNN-сеть. Дает распределение вероятностей по всем значениям определенного слота .

- Database Operator. Выполняет запрос к базе данных по сущностям и возвращает вектор , где единицей отмечается та запись (сущность в БД), которая соответствует запросу.

- Policy network. Объединяет системные модули. Выходом является вектор , который представляет системное действие. Распределение вероятностей для каждого слота пребразуется в вектор , который состоит из трех компонент: суммарная вероятность, вероятность, что пользователь выразил безразличие к слоту, и вероятность, что слот не был упомянут. Также вектор сжимается в one-hot-вектор , где каждая компонента определяет количество подходящих записей.

где матрицы , и — параметры, а — конкатенация.

- Generation Network. Генерирует предложение, используя вектор действия и генератор языка. Предложение содержит специальные токены, которые заменяются на сущности из базы данных по указателю.

Данную архитектуру также называют сквозной (англ. end-to-end trainable), так как на данных обучается каждая ее часть. Для модели с данной архитектурой не требуется создавать промежуточные состояния вручную, а также ее можно обобщить на намерения, которые не наблюдались во время обучения.

Чат-ориентированные диалоговые системы =

С ограниченными ответами

С генерацией ответов

Примеры диалоговых систем

ELIZA иалоговая система-психоаналитик (сейчас, ее назвали бы чат-бот), родом из 60-ых годов.

Диалоговая операционная система.

Фреймворки

Существует множество фрейморков, которые значительно упрощают построение диалоговых систем.

DeepPavlov.ai

Включает множество компонентов, при помощи которых создаются скилы. Множество скилов объединяются в диалоговый агент с которым взаимодействуют пользователи на естественном языке.

LTP

Rasa

spaCy

Другое

Языковые модели: .

См. также

- Рекуррентные нейронные сети

- Векторное представление слов

- Обработка естественного языка

- Распознавание речи