Кластеризация — различия между версиями

(Methods added) |

|||

| Строка 41: | Строка 41: | ||

* Графовые алгоритмы кластеризации. Наиболее примитивный класс алгоритмов. В настоящее время практически не применяется на практике. | * Графовые алгоритмы кластеризации. Наиболее примитивный класс алгоритмов. В настоящее время практически не применяется на практике. | ||

* Вероятностные алгоритмы кластеризации. Каждый объект из обучающей выборки относится к каждому из кластеров с определенной степенью вероятности. | * Вероятностные алгоритмы кластеризации. Каждый объект из обучающей выборки относится к каждому из кластеров с определенной степенью вероятности. | ||

| − | ** EM-алгоритм | + | ** EM-алгоритм<ref>[http://neerc.ifmo.ru/wiki/index.php?title=EM-алгоритм EM-алгоритм]</ref> |

* Иерархические алгоритмы кластеризации. Упорядочивание данных путем создания иерархии вложенных кластеров. | * Иерархические алгоритмы кластеризации. Упорядочивание данных путем создания иерархии вложенных кластеров. | ||

| − | * Алгоритм <tex>\mathrm{k}</tex>-средних (англ. ''<tex>\mathrm{k}</tex>-means''). Итеративный алгоритм, основанный на минимизации суммарного квадратичного отклонения точек кластеров от центров этих кластеров. | + | * Алгоритм <tex>\mathrm{k}</tex>-средних (англ. ''<tex>\mathrm{k}</tex>-means'')<ref>[http://neerc.ifmo.ru/wiki/index.php?title=K-средних <tex>\mathrm{k}</tex>-средних]</ref>. Итеративный алгоритм, основанный на минимизации суммарного квадратичного отклонения точек кластеров от центров этих кластеров. |

* Распространение похожести (англ. ''affinity propagation''). Распространяет сообщения о похожести между парами объектов для выбора типичных представителей каждого кластера. | * Распространение похожести (англ. ''affinity propagation''). Распространяет сообщения о похожести между парами объектов для выбора типичных представителей каждого кластера. | ||

* Сдвиг среднего значения (англ. ''mean shift''). Выбирает центроиды кластеров в областях с наибольшей плотностью. | * Сдвиг среднего значения (англ. ''mean shift''). Выбирает центроиды кластеров в областях с наибольшей плотностью. | ||

| Строка 69: | Строка 69: | ||

* Подбор рекомендаций для пользователя на основе предпочтений других пользователей в данном кластере. | * Подбор рекомендаций для пользователя на основе предпочтений других пользователей в данном кластере. | ||

* Определение аномалий путем построения кластеров и выявления неклассифицированных объектов. | * Определение аномалий путем построения кластеров и выявления неклассифицированных объектов. | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

== См. также == | == См. также == | ||

| − | * [[Оценка_качества_в_задаче_кластеризации|Оценка качества в задаче кластеризации]]<sup>[на | + | * [[Оценка_качества_в_задаче_кластеризации|Оценка качества в задаче кластеризации]]<sup>[на 28.12.18 не создан]</sup> |

| − | * [[EM-алгоритм|EM-алгоритм]]<sup>[на | + | * [[EM-алгоритм|EM-алгоритм]]<sup>[на 28.12.18 не создан]</sup> |

| + | * [[k-средних|<tex>\mathrm{k}</tex>-средних]]<sup>[на 28.12.18 не создан]</sup> | ||

== Примечания == | == Примечания == | ||

| Строка 215: | Строка 83: | ||

* [https://en.wikipedia.org/wiki/Cluster_analysis Wikipedia {{---}} Cluster analysis] | * [https://en.wikipedia.org/wiki/Cluster_analysis Wikipedia {{---}} Cluster analysis] | ||

* [http://www.machinelearning.ru/wiki/index.php?title=%D0%9A%D0%BB%D0%B0%D1%81%D1%82%D0%B5%D1%80%D0%B8%D0%B7%D0%B0%D1%86%D0%B8%D1%8F MachineLearning {{---}} Кластеризация] | * [http://www.machinelearning.ru/wiki/index.php?title=%D0%9A%D0%BB%D0%B0%D1%81%D1%82%D0%B5%D1%80%D0%B8%D0%B7%D0%B0%D1%86%D0%B8%D1%8F MachineLearning {{---}} Кластеризация] | ||

| − | |||

| − | |||

* [http://www.machinelearning.ru/wiki/images/c/ca/Voron-ML-Clustering.pdf К.В.Воронцов Лекции по алгоритмам кластеризации и многомерного шкалирования] | * [http://www.machinelearning.ru/wiki/images/c/ca/Voron-ML-Clustering.pdf К.В.Воронцов Лекции по алгоритмам кластеризации и многомерного шкалирования] | ||

| − | |||

[[Категория: Машинное обучение]] | [[Категория: Машинное обучение]] | ||

[[Категория: Кластеризация]] | [[Категория: Кластеризация]] | ||

Версия 15:16, 28 декабря 2018

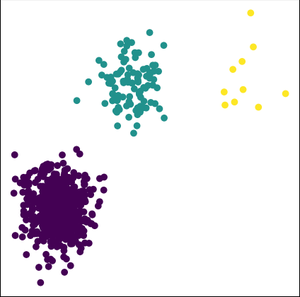

Кластеризация (англ. cluster analysis) — задача группировки множества объектов на подмножества (кластеры) таким образом, чтобы объекты из одного кластера были более похожи друг на друга, чем на объекты из других кластеров по какому-либо критерию.

Задача кластеризации относится к классу задач обучения без учителя.

Содержание

Постановка задачи кластеризации

Пусть — множество объектов, — множество идентификаторов (меток) кластеров. На множестве задана функция расстояния между объектами . Дана конечная обучающая выборка объектов . Необходимо разбить выборку на подмножества (кластеры), то есть каждому объекту сопоставить метку , таким образом чтобы объекты внутри каждого кластера были близки относительно метрики , а объекты из разных кластеров значительно различались.

| Определение: |

| Алгоритм кластеризации — функция , которая любому объекту ставит в соответствие идентификатор кластера . |

Множество в некоторых случаях известно заранее, однако чаще ставится задача определить оптимальное число кластеров, с точки зрения того или иного критерия качества кластеризации.

Кластеризация (обучение без учителя) отличается от классификации (обучения с учителем) тем, что метки объектов из обучающей выборки изначально не заданы, и даже может быть неизвестно само множество .

Решение задачи кластеризации объективно неоднозначно по ряду причин:

- не существует однозначного критерия качества кластеризации. Известен ряд алгоритмов, осуществляющих разумную кластеризацию "по построению", однако все они могут давать разные результаты. Следовательно, для определения качества кластеризации и оценки выделенных кластеров необходим эксперт предметной области.

- число кластеров, как правило, заранее не известно и выбирается по субъективным критериям. Даже если алгоритм не требует изначального знания о числе классов, конкретные реализации зачастую требуют указать этот параметр[1].

- результат кластеризации существенно зависит от метрики. Однако существует ряд рекомендаций по выбору метрик для определенных классов задач.[2]

Типология задач кластеризации

Типы входных данных

- Признаковое описание объектов. Каждый объект описывается набором своих характеристик, называемых признаками (англ. features). Признаки могут быть как числовыми, так и нечисловыми.

- Матрица расстояний между объектами. Каждый объект описывается расстоянием до всех объектов из обучающей выборки.

Вычисление матрицы расстояний по признаковому описанию объектов может быть выполнено бесконечным числом способов в зависимости от определения метрики между объектами. Выбор метрики зависит от обучающей выборки и поставленной задачи.

Цели кластеризации

- Классификация объектов. Попытка понять зависимости между объектами путем выявления их кластерной структуры. Разбиение выборки на группы схожих объектов упрощает дальнейшую обработку данных и принятие решений, позволяет применить к каждому кластеру свой метод анализа (стратегия «разделяй и властвуй»). В данном случае стремятся уменьшить число кластеров для выявления наиболее общих закономерностей.

- Сжатие данных. Можно сократить размер исходной выборки, взяв один или несколько наиболее типичных представителей каждого кластера. Здесь важно наиболее точно очертить границы каждого кластера, их количество не является важным критерием.

- Обнаружение новизны (обнаружение шума). Выделение объектов, которые не подходят по критериям ни в один кластер. Обнаруженные объекты в дальнейшем обрабатывают отдельно.

Методы кластеризации

- Графовые алгоритмы кластеризации. Наиболее примитивный класс алгоритмов. В настоящее время практически не применяется на практике.

- Вероятностные алгоритмы кластеризации. Каждый объект из обучающей выборки относится к каждому из кластеров с определенной степенью вероятности.

- EM-алгоритм[3]

- Иерархические алгоритмы кластеризации. Упорядочивание данных путем создания иерархии вложенных кластеров.

- Алгоритм -средних (англ. -means)[4]. Итеративный алгоритм, основанный на минимизации суммарного квадратичного отклонения точек кластеров от центров этих кластеров.

- Распространение похожести (англ. affinity propagation). Распространяет сообщения о похожести между парами объектов для выбора типичных представителей каждого кластера.

- Сдвиг среднего значения (англ. mean shift). Выбирает центроиды кластеров в областях с наибольшей плотностью.

- Спектральная кластеризация (англ. spectral clustering). Использует собственные значения матрицы расстояний для понижения размерности перед использованием других методов кластеризации.

- Основанная на плотности пространственная кластеризация для приложений с шумами (англ. Density-based spatial clustering of applications with noise, DBSCAN). Алгоритм группирует в один кластер точки в области с высокой плотностью. Одиноко расположенные точки помечает как шум.

Применение

Биология и биоинформатика

- В области экологии кластеризация используется для выделения пространственных и временных сообщест организмов в однородных условиях.

- Кластерный анализ используется для группировки схожих геномных последовательностей в семейство генов, которые являются консервативными структурами для многих организмов и могут выполнять схожие функции.

- Кластеризация помогает автоматически определять генотипы по различным частям хромосом.

- Алгоритмы применяются для выделения небольшого числа групп генетических вариации человеческого генома.

Медицина

- Используется в позитронно-эмиссионной томографии для автоматического выделения различных типов тканей на трехмерном изображении.

- Применяется для выявления шаблонов устойчивости к антибиотикам; для классификации антибиотиков по типу антибактериальной активности.

Маркетинг

Кластеризация широко используется при изучении рынка для обработки данных, полученных из различных опросов. Может применяться для выделения типичных групп покупателей, разделения рынка для создания персонализированных предложений, разработки новых линий продукции.

Интернет

- Выделение групп людей на основе графа связей в социальных сетях.

- Повышение релевантности ответов на поисковые запросы путем группировки веб-сайтов по смысловым значениям поискового запроса.

Компьютерные науки

- Кластеризация используется в сегментации изображений для определения границ и распознавания объектов.

- Кластерный анализ применяется для определения образовавшихся популяционных ниш в ходе работы эволюционных алгоритмов для улучшения параметров эволюции.

- Подбор рекомендаций для пользователя на основе предпочтений других пользователей в данном кластере.

- Определение аномалий путем построения кластеров и выявления неклассифицированных объектов.

См. также

- Оценка качества в задаче кластеризации[на 28.12.18 не создан]

- EM-алгоритм[на 28.12.18 не создан]

- -средних[на 28.12.18 не создан]

Примечания

- ↑ scikit-learn — Clustering

- ↑ Cornwell, B. (2015). Linkage Criteria for Agglomerative Hierarchical Clustering. Social Sequence Analysis, 270–274.

- ↑ EM-алгоритм

- ↑ -средних