Обсуждение участника:SergeyBud

HAT(Hashed Array Tree) — структура данных, объединяющая в себе некоторые возможности массивов, хэш-таблиц и деревьев. В действительности HAT — это эффективный способ реализовать массивы переменной длины, так как он предлагает хорошую производительность порядка , чтобы добавить элементов к пустому массиву, и требует всего лишь дополнительной памяти.

Значимость

Массивы переменной длины — наиболее естественная и удобная структура данных для многих приложений, так как они обеспечивают постоянное время доступа к их элементам. Однако при их реализации мы можем столкнуться с двумя основными проблемами: чрезмерное копирование элементов и использование памяти. HAT — реализация массива переменной длины, решающая обе проблемы и предоставляющая ряд преимуществ по сравнению со стандартными реализациями.

Устройство HAT

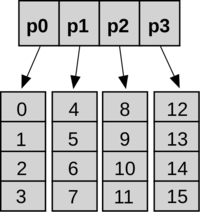

HAT состоит из главного массива указателей и ряда листьев (так же одномерные массивы), в которых хранятся элементы. Возможное число указателей в главном массиве и возможное число элементов в каждом листе равны между собой и являются степенями двойки.

Получение элемента по номеру

Благодаря использованию степеней двойки, мы можем эффективно находить элементы в HAT, используя поразрядные операции.

topIndex(j) // Получить номер указателя в основном массиве return j >> power; leafIndex(j) // Получить номер листа return j & ((1<<power)-1); getHat(j) // Вернуть элемент HAT. Нет проверки на выход за пределы массива. return top[topIndex(j)][leafIndex(j)];

Рассмотрим как происходит вычисление адреса на примере. Пусть у нас есть HAT с 3-мя используемыми листьями, тогда для нашего случая . Получим значения функций для элемент под номером :

- : в данном случае битовый сдвиг эквивалентен опреации деления(взятию по модулю) на . То есть получим — действительно элемент под номером находится в первом листе(нумерация листов с ).

- : в данном случае битовый сдвиг эквивалентен умножению на . Тоесть после вычитания получим число формата , в нашем случае — .

- , то есть индекс в листе равен (в листах нумерация так же с ).

Добавление элементов

Чаще всего при добавлении элемента в одном из листьев (последнем незаполненном на данный момент) найдется свободное место, что позволит осуществить быструю вставку(). Реже мы столкнемся со случаем, когда необходимо создать новый лист. Достаточно всего лишь добавить указатель в свободную ячейку главного массива, что также позволит произвести вставку элемента за . Самый интересный случай — когда главный массив и все листья заполнены. Cначала вычислим нужный размер (массивы и увеличиваются в 2 раза, то есть ), затем скопируем элементы в новую структуру HAT, освобождая старые листья и распределяя новые листья(размер листа изменился, а значит количество элементов в листе и количество используемых листьев так же изменится). Такой подход к расширению помогает избежать избыточного перекопирования, используемого во многих реализациях массивов переменной длины, потому что увеличения размеров всех массивов происходит редко (как будет видно ниже). Копировать элементы мы будем только тогда, когда главный массив полон(достигли соответствующей степени двойки, то есть , где — натуральное число), тогда общая сумма перекопирования будет равна . Воспользуемся тождеством: , тогда для нашего случая: , или около . Это означает, что среднее число дополнительных операций копирования — для последовательного добавления N элементов, а не . Мы получили против в обычном динамическом массиве, то есть константа уменьшилась.

Расход памяти

HAT использует меньше дополнительной памяти, чем в стандартных подходах к расширению массивов, то есть полном перекопировании и перераспределении всего массива. Затраты дополнительной памяти(уже выделенной, но еще не используемой) в самом плохом случае — (этот случай при пустой HAT — в один указатель на единственный пустой лист). Если в листе будет элементов, то ожидаемая трата дополнительной памяти уменьшается до , а это все еще . Сравним с другими структурами, добавляющими элементы за . Например, отдельно связанные списки требуют O(N) дополнительной памяти (один указатель для каждого элемента).

Эффективность

Благодаря преимуществам, предоставляемыми HAT(так например вычисление адреса происходит приблизительно в 2 раза быстрее, чем в стандартном массиве C++ — для соответствующего мы можем сделать предвычисление выражения тогда для вычисления адреса в обоих массивах потребуется всего одна битовая операция), ее можно использовать в любых программах, требующих работу с массивами переменной длинны, где использование других структур данных (например списков) не удобно. На многих алгоритмах HAT работает значительно быстрее стандартных массивов, дополнительно можно ознакомиться с результатами некоторых тестов[1].

Примечания

Источники информации

- Wikipedia — Hashed array tree

- Cline, M.P. and G.A. Lomow, C++ FAQs, Reading, MA: Addison-Wesley, 1995.

- Cormen, T.H., C.E. Leiserson, and R.L. Rivest. Introduction to Algorithms, Cambridge, MA: MIT Press, 1990.