Поиск архитектуры нейронной сети — различия между версиями

| Строка 3: | Строка 3: | ||

== Принцип работы == | == Принцип работы == | ||

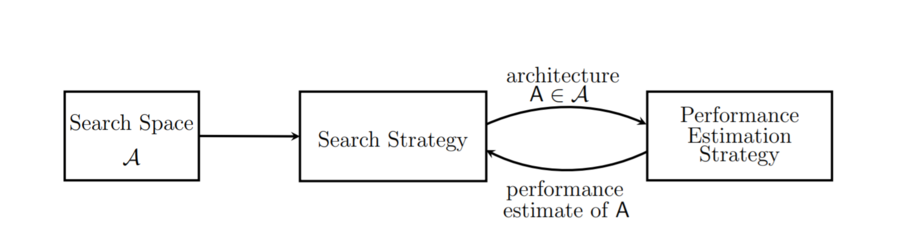

| − | [[Файл:NAS 1.PNG|900px|thumb|center| | + | [[Файл:NAS 1.PNG|900px|thumb|center|Абстрактная иллюстрация методов NAS. Стратегия поиска |

выбирает архитектуру A из предопределенного пространства поиска A. Архитектура | выбирает архитектуру A из предопределенного пространства поиска A. Архитектура | ||

передается в стратегию оценки производительности, которая возвращает оценку эффективности A в стратегию поиска. ([https://arxiv.org/pdf/1808.05377.pdf Источник])]] | передается в стратегию оценки производительности, которая возвращает оценку эффективности A в стратегию поиска. ([https://arxiv.org/pdf/1808.05377.pdf Источник])]] | ||

=== Пространство поиска (Search Space) === | === Пространство поиска (Search Space) === | ||

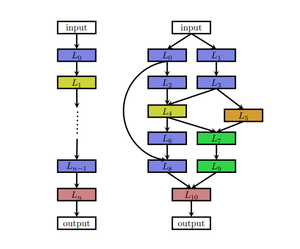

| − | Пространство поиска определяет, какую нейронную архитектуру в принципе может обнаружить подход NAS. Это может быть цепочечная архитектура, в которой выход уровня (n-1) подается как вход уровня (n). Или это может быть современная сложная архитектура с пропущенным соединением (multi-branch network). Предварительные знания о типичных свойствах архитектур способны уменьшить размер пространства поиска и упростить поиск. Тем не менее, они также могут помешать человеку найти новые архитектурные строительные блоки, которые выходят за рамки современных человеческих знаний. | + | [[Файл:Chain-like-NAS.png|thumb|right|A chain-like and multi-branch network; каждый узел соответствует уровню в нейронной сети. Различные типы слоев визуализируются разными цветами. Ребро от слоя Li до слоя Lj обозначает, что Lj получает выходные данные Li в качестве входных данных.]] |

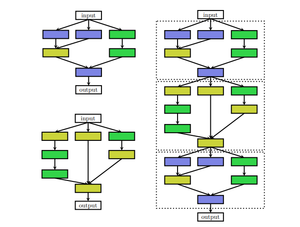

| + | Пространство поиска определяет, какую нейронную архитектуру в принципе может обнаружить подход NAS. Это может быть цепочечная архитектура, в которой выход уровня (n-1) подается как вход уровня (n). [[Файл:Cell-like-NAS.png|left|thumb|слева: сell architecture, две разные ячейки, например normal cell (вверху) и reduction cell (внизу); справа: ячейки помещены во внешнюю структуру ручной работы]] Или это может быть современная сложная архитектура с пропущенным соединением (multi-branch network). Предварительные знания о типичных свойствах архитектур способны уменьшить размер пространства поиска и упростить поиск. Тем не менее, они также могут помешать человеку найти новые архитектурные строительные блоки, которые выходят за рамки современных человеческих знаний. | ||

Наиболее часто используемые типы архитектур для NAS - это entire structures, cell-based structures, | Наиболее часто используемые типы архитектур для NAS - это entire structures, cell-based structures, | ||

progressive structures and morphism-based structures. | progressive structures and morphism-based structures. | ||

| − | |||

Иногда используют внешнюю архитектуру ручной работы (макроархитектуру) с повторяющимися мотивами или ячейками. В таких случаях внешняя структура является фиксированной, NAS ищет только cell-архитектуры. Этот тип поиска известен как микро-поиск или cell search. | Иногда используют внешнюю архитектуру ручной работы (макроархитектуру) с повторяющимися мотивами или ячейками. В таких случаях внешняя структура является фиксированной, NAS ищет только cell-архитектуры. Этот тип поиска известен как микро-поиск или cell search. | ||

| − | |||

| − | |||

| Строка 23: | Строка 21: | ||

Для изучения пространства нейронных архитектур можно использовать множество различных стратегий поиска, включая '''случайный поиск''', '''байесовскую оптимизацию''', '''эволюционные методы''', '''[[обучение с подкреплением]] (reinforcement learning)''' и '''методы на основе градиента'''. | Для изучения пространства нейронных архитектур можно использовать множество различных стратегий поиска, включая '''случайный поиск''', '''байесовскую оптимизацию''', '''эволюционные методы''', '''[[обучение с подкреплением]] (reinforcement learning)''' и '''методы на основе градиента'''. | ||

| − | === BANANAS (Bayesian optimization with neural architectures for NAS) === | + | ==== Сравнение методов стратегий поиска ==== |

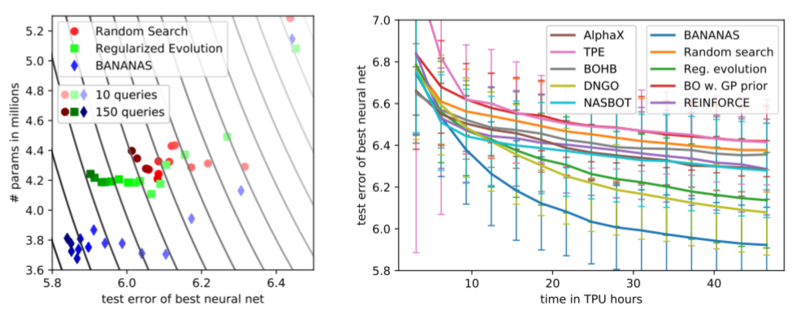

| + | [[Файл:NAS-method-comparison.PNG|800px|thumb|center|слева: результат экспериментов, минимизирующих функцию потерь и количества параметров модели; справа: сравнение основных используемых в NAS алгоритмов]] | ||

| + | Лучшие результаты на сегодняшний день показывает NAS с использованием стратегии байесовской оптимизации (согласно исследованию [https://arxiv.org/pdf/1910.11858.pdf Bayesian Optimization with Neural Architectures for Neural Architecture Search, Colin White, Willie Neiswanger, Yash Savani]). | ||

| + | |||

| + | Байесовская оптимизация (Bayes Optimization, BO) использует алгоритм для построения вероятностной модели целевой функции, а затем использует эту модель, чтобы выбрать наиболее перспективные гиперпараметры и оценивает выбранные гиперпараметры на истинной целевой функции. Следовательно, BO может итеративно обновлять вероятностную модель, ведя учет оценок прошлых результатов. | ||

| + | |||

| + | ==== BANANAS (Bayesian optimization with neural architectures for NAS) ==== | ||

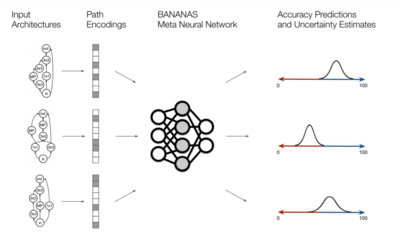

[[Файл:BANANAS alg.PNG|400px|thumb|right|Иллюстрация мета-нейронной сети в алгоритме BANANAS]] | [[Файл:BANANAS alg.PNG|400px|thumb|right|Иллюстрация мета-нейронной сети в алгоритме BANANAS]] | ||

Сложностью применения байесовской оптимизации в NAS является обязательное наличии функции расстояния между слоями нейросети. Чтобы обойти этот момент, был разработан алгоритм [https://github.com/naszilla/bananas BANANAS (Bayesian optimization with neural architectures for NAS)] - алгоритм, использующий специальную кодировку path encoding для кодирования входных архитектур и получающий на выходе вероятностные распределения (см. рисунок). | Сложностью применения байесовской оптимизации в NAS является обязательное наличии функции расстояния между слоями нейросети. Чтобы обойти этот момент, был разработан алгоритм [https://github.com/naszilla/bananas BANANAS (Bayesian optimization with neural architectures for NAS)] - алгоритм, использующий специальную кодировку path encoding для кодирования входных архитектур и получающий на выходе вероятностные распределения (см. рисунок). | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | ||

| − | + | Алгоритм BANANAS: | |

| + | #Выбираются t0 случайных архитектур из пространства поиска (Search Space) | ||

| + | #Итерационно проводится обучение ансамбля мета-нейронный сетей на выбранных архитектурах. Каждая сеть ансамбля является сетью прямой связи с полностью связанными слоями, каждому слою дается случайная инициализация весов и случайный порядок обучающего набора. Используемая функция ошибки - вариация MAPE (mean absolute percentage error). | ||

| + | ##Далее формируется набор архитектур-"кандидатов" посредством случайных изменений лучших архитектур после обучения | ||

| + | ##Для каждой архитектуры-кандидата определяется значение переданной на вход ITS acquisition function (''[[https://en.wikipedia.org/wiki/Thompson_sampling independent Thompson sampling]]'') | ||

| + | ##Для архитектуры-кандидата с минимальным значением acquisition function определяется значение целевой вероятностной функции | ||

| + | |||

| + | |||

===Стратегия оценки эффективности (Performance Estimation Strategy)=== | ===Стратегия оценки эффективности (Performance Estimation Strategy)=== | ||

Целью NAS обычно является поиск | Целью NAS обычно является поиск | ||

| Строка 38: | Строка 45: | ||

способных снизить стоимость этих оценок производительности. | способных снизить стоимость этих оценок производительности. | ||

| − | |||

| − | |||

| − | |||

| − | |||

== Источники информации == | == Источники информации == | ||

Версия 13:06, 14 апреля 2020

Neaural Architecture Search (NAS, Поиск архитектуры нейронной сети) - процесс автоматизации проектирования архитектуры, то есть нахождение нашей модели машинного обучения. Системе NAS предоставляется набор данных, тип задачи (классификация, регрессия и т.д.), на основании которого система определяет архитектуру нейронной сети. Эта архитектура будет работать лучше всех других архитектур для данной задачи при обучении предоставленным набором данных. NAS можно рассматривать как часть AutoML (Автоматическое машинное обучение), он имеет значительное совпадение с оптимизацией гиперпараметров (Настройка гиперпараметров). NAS находит архитектуру из всех возможных архитектур, следуя стратегии поиска, которая максимизирует производительность.

Содержание

Принцип работы

Пространство поиска (Search Space)

Наиболее часто используемые типы архитектур для NAS - это entire structures, cell-based structures, progressive structures and morphism-based structures. Иногда используют внешнюю архитектуру ручной работы (макроархитектуру) с повторяющимися мотивами или ячейками. В таких случаях внешняя структура является фиксированной, NAS ищет только cell-архитектуры. Этот тип поиска известен как микро-поиск или cell search.

Стратегия поиска (Search Strategy)

Стратегия поиска подробно описывает, как исследовать пространство поиска, которое часто экспоненциально велико или даже неограниченно. Она включает в себя классический компромисс между разведкой и эксплуатацией, поскольку, с одной стороны, желательно найти быстро работающие архитектуры, с другой стороны, следует избегать преждевременного схождения.

Для изучения пространства нейронных архитектур можно использовать множество различных стратегий поиска, включая случайный поиск, байесовскую оптимизацию, эволюционные методы, обучение с подкреплением (reinforcement learning) и методы на основе градиента.

Сравнение методов стратегий поиска

Лучшие результаты на сегодняшний день показывает NAS с использованием стратегии байесовской оптимизации (согласно исследованию Bayesian Optimization with Neural Architectures for Neural Architecture Search, Colin White, Willie Neiswanger, Yash Savani).

Байесовская оптимизация (Bayes Optimization, BO) использует алгоритм для построения вероятностной модели целевой функции, а затем использует эту модель, чтобы выбрать наиболее перспективные гиперпараметры и оценивает выбранные гиперпараметры на истинной целевой функции. Следовательно, BO может итеративно обновлять вероятностную модель, ведя учет оценок прошлых результатов.

BANANAS (Bayesian optimization with neural architectures for NAS)

Сложностью применения байесовской оптимизации в NAS является обязательное наличии функции расстояния между слоями нейросети. Чтобы обойти этот момент, был разработан алгоритм BANANAS (Bayesian optimization with neural architectures for NAS) - алгоритм, использующий специальную кодировку path encoding для кодирования входных архитектур и получающий на выходе вероятностные распределения (см. рисунок).

Алгоритм BANANAS:

- Выбираются t0 случайных архитектур из пространства поиска (Search Space)

- Итерационно проводится обучение ансамбля мета-нейронный сетей на выбранных архитектурах. Каждая сеть ансамбля является сетью прямой связи с полностью связанными слоями, каждому слою дается случайная инициализация весов и случайный порядок обучающего набора. Используемая функция ошибки - вариация MAPE (mean absolute percentage error).

- Далее формируется набор архитектур-"кандидатов" посредством случайных изменений лучших архитектур после обучения

- Для каждой архитектуры-кандидата определяется значение переданной на вход ITS acquisition function ([independent Thompson sampling])

- Для архитектуры-кандидата с минимальным значением acquisition function определяется значение целевой вероятностной функции

Стратегия оценки эффективности (Performance Estimation Strategy)

Целью NAS обычно является поиск архитектуры, обеспечивающей высокую точность прогнозов по невидимым данным. Performance Estimation относится к процессу оценки этой производительности. Самый простой вариант - выполнить стандартное обучение и проверку архитектуры данных, но это, к сожалению, вычислительно дорого и ограничивает количество архитектур, которые можно изучить. Поэтому многие недавние исследования направлены на разработку методов, способных снизить стоимость этих оценок производительности.

Источники информации

- AutoML: A Survey of the State-of-the-Art Xin He, Kaiyong Zhao, Xiaowen Chu

- Bayesian Optimization with Neural Architectures for Neural Architecture Search, Colin White, Willie Neiswanger, Yash Savani

- Medium Towards Data Science - Neural Architecture Search (NAS) - The Future Of Deep Learning

- Neural Architecture Search: A Survey