Adaptive precision arithmetic — различия между версиями

Smolcoder (обсуждение | вклад) (→Расширения) |

Smolcoder (обсуждение | вклад) (→Суммирование расширений) |

||

| Строка 183: | Строка 183: | ||

===Суммирование расширений=== | ===Суммирование расширений=== | ||

| + | Базируясь на алгоритмах сложения двух <tex>p</tex>-битных чисел, описанных выше, можно предложить алгоритмы суммирования расширений. В этой статье их будет предложено три: ExpansionSum, LinearExpansionSum и FastExpansionSum. Первый алгоритм прибавляет к m-элементному расширению n-элементное расширение за время <tex>O(mn)</tex>, в то время, как последние два алгоритма делают это за <tex>O(n + m)</tex>. | ||

| + | |||

| + | Несмотря на такое различие в асимптотике, первый алгоритм на практике может оказаться быстрее на расширениях, чей размер мал и фиксирован, потому что программные циклы могут быть полностью развернуты, а косвенные расходы времени исчезают, так как можно отказаться от использования массива). Линейные алгоритмы имеют определенные условия, при которых подобные оптимизации невозможны. | ||

| + | |||

| + | ExpansionSum и LinearExpansionSum имеют свойство, что если входные данные были неперекрывающимися (несмежными), то и на выходе мы получим расширения с соотв.свойством. | ||

| + | |||

| + | FastExpansionSum быстрее, чем LinearExpansionSum, используя шесть операций на компоненту вместо девяти, но имеет один важный недостаток: в расширении на выходе могут быть нулевые элементы, даже если в исходном расширении их не было. | ||

Версия 06:10, 21 октября 2011

Содержание

Мотивация

Все вычисления, производимые компьютером во floating-point[1] модели, имеют погрешность. При большом количестве арифметических действий она возрастает. Во многих случаях результирующая погрешность уже не устраивает, и требуется либо абсолютно точное вычисление, либо меньшая погрешность. Одним из решений данной проблемы является хранение чисел в виде рациональных дробей, в которых числитель и знаменатель представляется в виде длинного целого числа. Но работать с такими числами довольно "дорого" по времени и тяжело в реализации: необходимо писать факторизацию чисел, эффективно сокращать дроби. Для улучшения работы нужны определенные оптимизации. Одной из них и является использование adaptive precision arithmetic.

Background

Большинство современных процессоров поддерживают числа с плавающей точкой в форме . Значащая часть числа (мантисса) представляет собой -битное двоичное число в форме , где каждое обозначает один бит. Также имеется один бит на знак.

Числа с плавающей точкой, как правило, нормализованы, то есть если число не равно нулю, то первый значимый бит равен единице, а экспонента устанавливается соответственно. Например, в -битной арифметике число 1101 (десятичное 13) будет выглядеть как .

Далее в этой статье фраза "что-либо представимо в битах" будет означать представимость в битах мантиссы, не учитывая знак и экспоненту.

Базовые понятия

Расширения

| Определение: |

| Два числа и называются неперекрывающимися (англ. nonoverlapping), если номер наименьшего значимого бита числа (нумерация справа налево) больше, чем номер наибольшего значимого бита числа , или наоборот. |

Более формально, и не перекрываются, если существует такое целое число и , что и , или и .

Ноль не пересекается ни с одним другим числом.

Например, числа 1100 и -10.1 не пересекаются, а 101 и 10 - пересекаются.

| Определение: |

| Два числа и называются смежными (англ. adjacent), если они перекрываются, если и перекрываются, или и перекрываются. |

Например, числа 1100 и 11 - смежные, а 1100 и 1000 - нет.

Иногда для использовании точной арифметики может понадобиться больше, чем бит для хранения величин. В связи с этим вводится одно из базовых форм хранения чисел для такой арифметики.

| Определение: |

| Расширением числа называется такое его представление , где каждое выражено -битным числом с плавающей точкой и называется компонентой этого расширения. |

| Определение: |

| Расширение называется неперекрывающимся (несмежным), если все его компоненты взаимно не перекрываются (не являются смежными). |

Как правило, расширения должны быть неперекрывающимися, а их компоненты должны быть упорядочены от большей к меньшей по величине (то есть - большая). Далее будут рассматриваться именно такая их форма.

Стоит отметить, что число может быть представлено несколькими возможными неперекрывающимися расширениями: 1100 + -10.1 = 1001 + 0.1 = 1000 + 1 + 0.1.

Неперекрывающиеся расширения нужны, например, для того, чтобы быстро вычислять знак выражения (смотрим знак большей по размеру компоненты), или для грубой оценки значения всего расширения (берем большую по величине компоненту).

Округление

Все алгоритмы, представленные в этой статье, предполагают, что сложение, вычитание и умножение производятся с точным округлением. Предполагается, что числа представляются в битах.

| Определение: |

Точное округление (англ. exact rounding) - такой вид округления, что:

|

Например, в 4-битной арифметике произведение будет округлено в .

При вычислении результата может возникнуть ситуация, когда значение попадает в точности между двумя соседними -битными значениями. Тогда требуется определить правило поведения в таком случае. Рассмотрим некоторые из них.

| Определение: |

| Округление до ближайшего четного (англ. round-to-even) - правило, при котором округление в вышеописанном случае производится к ближайшему -битному четному значению. |

| Определение: |

| Округление к нулю (англ. round-toward-zero) - правило, при котором округление в вышеописанном случае производится -битному значению, находящемуся между точным значением и нулем, а также ближайшему к точному значению. |

Например, в 4-битной арифметике число будет округлено до по первому правилу, и до по второму.

Стоит отметить, что стандарт IEEE 754 использует округление до ближайшего четного по умолчанию.

Далее в этой статье символами и будут обозначаться -битные сложение, вычитание и умножение с точным округлением соответственно.

Из-за округления данные операции теряют некоторые важные свойства, например, ассициативность: , но .

При анализе округления часто используют так называемый ulp.

| Определение: |

| ULP (англ. units in the last place) - эффективная величина самого младшего (-ого) бита. |

Например, в -битной арифметике.

Так же полезной нотацией является , которая обозначает ошибку округлении результата выполнения операции . Отметим, что если ulp всегда беззнаковая величина, то err может иметь знак. Для базовых операций (сложение, вычитание, умножение) , и точное округление гарантирует, что .

Свойства

Иногда есть возможность найти более точные границы ошибки округления, что будет видно далее из лемм. Первая лемма используется, когда один операнд много меньше другого, а вторая - когда сумма близка к степени двойки. Для лемм 1 - 4 пусть - -битные числа с плавающей точкой. Леммы приводятся без доказательств, их можно найти в статье Джонатана Шевчука "Adaptive Precision Floating-Point Arithmetic and Fast Robust Geometric Predicates".

| Лемма: |

Пусть .

Ошибка округления не превзойдет . (Аналогично для вычитания). |

Как следствие, верна следующая лемма:

| Лемма: |

Ошибка округления может быть представлена в битах. |

| Лемма: |

Пусть и . Тогда . (Аналогично для вычитания). |

| Лемма: |

Пусть . Тогда . |

Алгоритмы суммирования

Простое суммирование

Важной базовой операцией во всех алгоритмах, основанных на представлении чисел в виде расширений, является сумма двух -битных величин, результатом которой является расширение длины два. Есть два алгоритма для выполнения этой задачи - алгоритмы Деккера и Кнута.

| Теорема (Dekker): |

Пусть и есть -битные числа, причем . Тогда следующий алгоритм вернет непересекающееся расширение такое, что , где - приближение (аппроксимация) суммы , а представляет собой ошибку округления при вычислении . (Аналогично для вычитания). |

Псевдокод для суммы:

Псевдокод для разности:

Отметим, что величины на выходе этой процедуры вовсе не должны иметь один знак, что будет видно из примеров ниже.

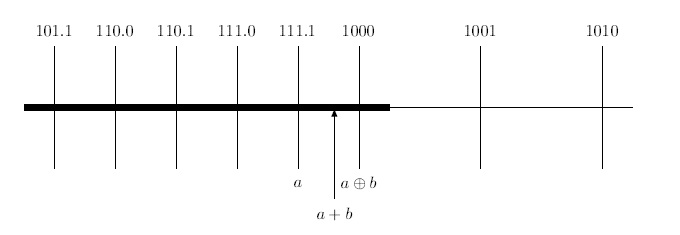

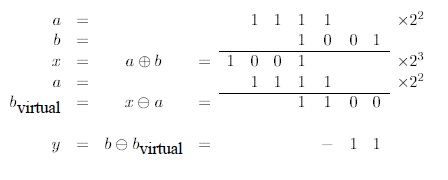

В первом примере и имеют один знак.

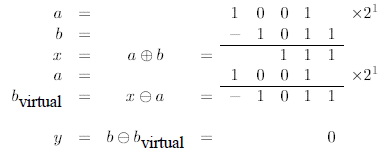

Во втором примере и имеют противоположные знаки, и .

Проблема с использованием этой процедуры заключается в требовании . Если это заранее не известно, то необходимо выполнить сравнение перед ее вызовом. В большинстве С компиляторов, возможно, самым быстрым переносимым способом реализовать эту проверку является выражение . На эту проверку уйдет некоторое время, но увеличение времени может быть на удивление большим из-за современных процессоров с суперскалярными и конвейерными архитектурами, в которых вызов условного оператора может сбросить ветку предсказаний. Это объяснение лишь гипотетическое и зависит от машины, но алгоритм TwoSum, что будет описан ниже, избегает этого сравнения посредством трех дополнительных операций, что обычно на практике даже быстрее. Конечно же, FastTwoSum все же быстрее, если результат сравнения известен априори.

| Теорема (Knuth): |

Пусть и есть -битные числа, причем . Тогда следующий алгоритм вернет непересекающееся расширение такое, что , где - приближение (аппроксимация) суммы , а представляет собой ошибку округления при вычислении . |

Псевдокод:

TODO: add pictures

Суммирование расширений

Базируясь на алгоритмах сложения двух -битных чисел, описанных выше, можно предложить алгоритмы суммирования расширений. В этой статье их будет предложено три: ExpansionSum, LinearExpansionSum и FastExpansionSum. Первый алгоритм прибавляет к m-элементному расширению n-элементное расширение за время , в то время, как последние два алгоритма делают это за .

Несмотря на такое различие в асимптотике, первый алгоритм на практике может оказаться быстрее на расширениях, чей размер мал и фиксирован, потому что программные циклы могут быть полностью развернуты, а косвенные расходы времени исчезают, так как можно отказаться от использования массива). Линейные алгоритмы имеют определенные условия, при которых подобные оптимизации невозможны.

ExpansionSum и LinearExpansionSum имеют свойство, что если входные данные были неперекрывающимися (несмежными), то и на выходе мы получим расширения с соотв.свойством.

FastExpansionSum быстрее, чем LinearExpansionSum, используя шесть операций на компоненту вместо девяти, но имеет один важный недостаток: в расширении на выходе могут быть нулевые элементы, даже если в исходном расширении их не было.