Batch-normalization — различия между версиями

(→Описание метода) |

|||

| Строка 33: | Строка 33: | ||

Тогда, алгоритм нормализации батчей можно представить так: | Тогда, алгоритм нормализации батчей можно представить так: | ||

| − | |||

'''Вход''': значения <tex>x</tex> из батча <tex>B = \{x_{1,\ldots, m}\}</tex>; настраиваемые параметры <tex>\gamma, \beta</tex>; константа <tex>\epsilon</tex> для вычислительной устойчивости. | '''Вход''': значения <tex>x</tex> из батча <tex>B = \{x_{1,\ldots, m}\}</tex>; настраиваемые параметры <tex>\gamma, \beta</tex>; константа <tex>\epsilon</tex> для вычислительной устойчивости. | ||

'''Выход''': <tex>\{y_{i} = BN_{\gamma, \beta}(x_{i})\}</tex> | '''Выход''': <tex>\{y_{i} = BN_{\gamma, \beta}(x_{i})\}</tex> | ||

| − | <tex>\mu_{B} = \displaystyle \frac{1}{m} \sum_{i=1}^{m} x_{i}</tex> // математическое ожидание батча | + | <tex>\mu_{B} = \displaystyle \frac{1}{m} \sum_{i=1}^{m} x_{i}</tex> <font color="green">// математическое ожидание батча</font> |

| − | <tex>\sigma_{B}^{2} = \displaystyle \frac{1}{m} \sum_{i=1}^{m} (x_{i} - \mu_{B})^{2}</tex> // дисперсия батча | + | <tex>\sigma_{B}^{2} = \displaystyle \frac{1}{m} \sum_{i=1}^{m} (x_{i} - \mu_{B})^{2}</tex> <font color="green">// дисперсия батча</font> |

| − | <tex>\hat{x}_{i} = \displaystyle \frac{x_{i} - \mu_{B}}{\sqrt{\sigma_{B}^{2} + \epsilon}}</tex> // нормализация | + | <tex>\hat{x}_{i} = \displaystyle \frac{x_{i} - \mu_{B}}{\sqrt{\sigma_{B}^{2} + \epsilon}}</tex> <font color="green">// нормализация</font> |

| − | <tex>y_{i} = \gamma \hat{x}_{i} + \beta \equiv BN_{\gamma, \beta}(x_{i}) </tex> // сжатие и сдвиг | + | <tex>y_{i} = \gamma \hat{x}_{i} + \beta \equiv BN_{\gamma, \beta}(x_{i}) </tex> <font color="green">// сжатие и сдвиг</font> |

Заметим, что если <tex>\beta=\mu_{B}</tex> и <tex>\gamma=\sqrt{\sigma_{B}^{2} + \epsilon}</tex>, то <tex>y_{i}</tex> равен <tex>x_{i}</tex>, то есть <tex>BN_{\gamma, \beta}(\cdot)</tex> является тождественным отображением. | Заметим, что если <tex>\beta=\mu_{B}</tex> и <tex>\gamma=\sqrt{\sigma_{B}^{2} + \epsilon}</tex>, то <tex>y_{i}</tex> равен <tex>x_{i}</tex>, то есть <tex>BN_{\gamma, \beta}(\cdot)</tex> является тождественным отображением. | ||

Версия 17:12, 10 января 2019

Нормализация батчей (англ. batch-normalization) — это метод, который позволяет повысить производительность и стабилизировать работу искусственных нейронных сетей. Суть данного метода заключается в том, что некоторым слоям нейронной сети на вход подаются данные, предварительно обработанные и имеющие нулевое математическое ожидание и единичную дисперсию. Впервые данный метод был представлен в [1].

Содержание

Идея

Нормализация входного слоя обычно выполняется путем масштабирования данных, подаваемых в функции активации. Например, когда у нас есть признаки со значениями от 0 до 1 и некоторые признаки со значениями от 1 до 1000, то их необходимо нормализовать, чтобы ускорить обучение. То же самое можно сделать и для скрытых слоев нейронных сетей.

Нормализация батчей уменьшает величину, на которую смещаются значения узлов в скрытых слоях (т.н. смещение ковариации (англ. covariance shift)). Проиллюстрируем смещение ковариации примером. Пусть, есть глубокая нейронная сеть, которая обучена определять находится ли на изображении роза. И нейронная сеть была обучена на изображении только красных роз. Теперь, если попытаться использовать обученную модель для обнаружения цветных роз, то, очевидно, результат будет неудовлетворительный. Обучающая и тестовая выборки содержат изображения роз, но немного отличаются. Другими словами, если модель обучена отображению из множества в множество и если распределение элементов в изменяется, то появляется необходимость обучить модель заново, чтобы "выровнять" распределение элементов в и . Когда батчи содержат изображения, равномерно-распределенные на всем множестве, то смещение ковариации незначительно. Однако, когда батчи выбираются только из одного из двух подмножеств (в данном случае, красные розы и цветные розы), то смещение ковариации возрастает. Это довольно сильно замедляет процесс обучения модели. На Рисунке 1 изображена разница в распределениях.

Простой способ решить проблему смещения ковариации для входного слоя — это случайным образом перемешать данные перед созданием батчей. Но для скрытых слоев нейронной сети данный метод не подходит, так как распределение входных данных для каждого узла скрытых слоев изменяется каждый раз, когда происходит обновление параметров в предыдущем слое. Данная проблема называется внутренним смещением ковариации (англ. internal covariate shift). Для решения этой проблемы необходимо использовать маленький коэффициент скорости обучения и методы регуляризации. Но, для решения данной проблемы как раз и был придуман метод нормализация батчей.

Кроме того, использование нормализации батчей обладает еще несколькими дополнительными полезными свойствами:

- достигается более быстрая сходимость моделей, несмотря на выполнение дополнительных вычислений;

- нормализация батчей позволяет каждому слою сети обучатся более независимо от других слоев;

- становится возможным использование более высокого коэффициента скорости обучения, так как нормализация батчей гарантирует, что выходы узлов нейронной сети не будут иметь слишком больших или малых значений;

- нормализация батчей в каком-то смысле также является механизмом регуляризации: данный метод привносит в выходы узлов скрытых слоев некоторый шум, аналогично методу dropout;

- модели становятся менее чувствительны к начальной инициализации весов.

Описание метода

Опишем устройство метода нормализации батчей. Пусть, на вход некоторому слою нейронной сети поступает вектор размерности : . Нормализуем данный вектор по каждой размерности :

,

где математическое ожидание и дисперсия считаются по всей обучающей выборке. Такая нормализация входа слоя нейронной сети может изменить представление данных в слое. Чтобы избежать данной проблемы, вводятся два параметра сжатия и сдвига нормализованной величины для каждого : , — которые действуют следующим образом:

.

Данные параметры настраиваются в процессе обучения вместе с остальными гиперпараметрами модели.

Пусть, обучение модели производится с помощью батчей размера : . Здесь нормализация применяется к каждой компоненте входа с номером отдельно, поэтому в индекс опускается для ясности изложения. Пусть, были получены нормализованные значения батча . Далее, после применения операций сжатия и сдвига были получены . Обозначим данную функцию нормализации батчей следующим образом:

Тогда, алгоритм нормализации батчей можно представить так:

Вход: значения из батча ; настраиваемые параметры ; константа для вычислительной устойчивости. Выход: // математическое ожидание батча // дисперсия батча // нормализация // сжатие и сдвиг

Заметим, что если и , то равен , то есть является тождественным отображением. Таким образом, использование нормализации батчей не может привести к снижению точности, поскольку оптимизатор просто может использовать нормализацию как тождественное отображение.

Обучение нейронных сетей с нормализацией батчей

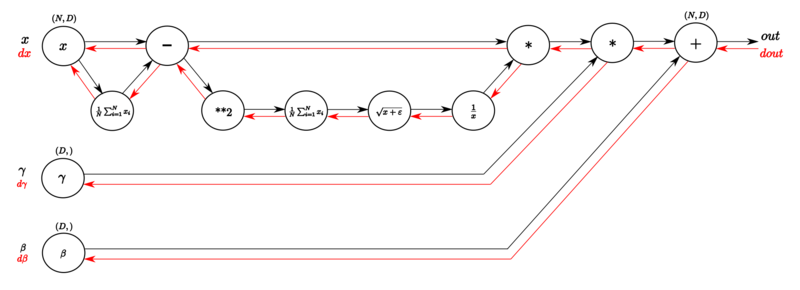

Для обучения нейронных сетей необходимо вычислять градиент функции потерь . В случае использования метода нормализации батчей градиент вычисляется следующим образом:

Нормализация батчей в свёрточных сетях

Нормализация батчей может быть применена к любой функции активации. Рассмотрим подробнее случай аффинного преобразования с некоторой нелинейной функцией:

,

где и — настраиваемые параметры модели, а — некоторая нелинейная функция, например cигмоида или ReLU. Данной функцией можно описать как обычные, так и сверточные слои нейронных сетей. Так, нормализация батчей применяется сразу перед нелинейной функцией к . Параметр может быть проигнорирован последующим вычитание математического ожидания (затем роль этого параметра будет играть ). Поэтому может быть записано так:

,

где применяется отдельно к каждой размерности с отдельной парой параметров и для каждой размерности.

В случае свёрточных сетей, дополнительно необходима нормализация, чтобы удовлетворить свойство свёрточных сетей, что различные элементы в разных местах одной карты признаков должны быть нормализованны одинаково. Чтобы этого добиться, нормализация выполняется совместно над всеми значениями в батче. Пусть, — множество всех значений в карте признаков по всему батчу и всем точкам в карте признаков. Тогда для батча размера и карты признаков размера размер равен . Тогда, параметры и настраиваются для каждой карты признаков отдельно.

Пример

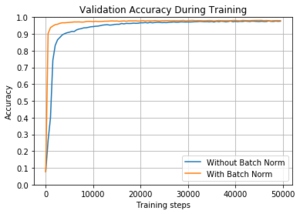

Приведем пример демонстрирующий работу нормализации батчей. Рассмотрим задачу распознавания рукописных цифр на известном датасете MNIST [2]. Для решения задачи будет использоваться обычная нейронная сеть с скрытыми полносвязными слоями по узлов в каждом. Функция активации — ReLU. Выходной слой содержит узлов. Размер батча равен . Сравнивается две одинаковые модели, но в первой перед каждым скрытым слоем используется нормализация батчей, а во второй — нет. Коэффициент скорости обучения равен . Веса инициализированы значениями с малой дисперсией.

На Рисунке 3 изображены два графика, показывающий разницу между моделями. Как видно, обе модели достигли высокой точности, но модель с использованием нормализации батчей достигла точности более быстрее, почти сразу, и достигла максимума, примерно, уже на итераций. Однако, модель без нормализации батчей достигла скорости обучения примерно батчей в секунда, а модель с использованием нормализации батчей — . Однако, как можно видеть, нормализация батчей позволяет выполнить меньшее количество итераций и, в итоге, сойтись за меньшее время.

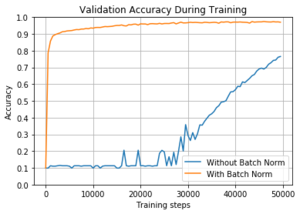

На Рисунке 4 изображен график, сравнивающий точно такие же модели, но с использованием сигмоиды в качестве функции активации. Использование сигмоиды в качестве функции активации требует большего времени, чтобы начать обучение модели. В итоге, модель обучается, но на это потребовалось более итераций, чтобы получить точность более . При использовании нормализации батчей получилось достичь точность более примерно за итераций.

Реализации

Механизм нормализации батчей реализован практически во всех современных инструментариях для машинного обучения, таких как: TensorFlow [3], Keras [4], CNTK [5], Theano [6], PyTorch [7] и т.д.

Приведем пример применения нормализации батчей с использованием библиотеки TensorFlow на языке программирования Python [8]:

import tensorflow as tf

# ...

is_train = tf.placeholder(tf.bool, name="is_train");

# ...

x_norm = tf.layers.batch_normalization(x, training=is_train)

# ...

update_ops = tf.get_collection(tf.GraphKeys.UPDATE_OPS)

with tf.control_dependencies(update_ops):

train_op = optimizer.minimize(loss)

Модификации

Существует несколько модификаций и вариаций метода нормализации батчей:

- В работе [9] был предложен способ применения нормализации батчей к рекуррентным нейронным сетям.

- Расширение метода нормализации батчей было предложено в [10]. Метод получил название декоррелированная нормализация батчей (англ. Decorrelated Batch Normalization). В данном методе кроме операций масштабирования и сдвига была предложено использование специальной функции затирания данных.

- В [11] был предложен метод нормализации слоев (англ. Layer Normalization), который решает проблему выбора размера батча.

- В работе [12] было представлено расширение метода нормализации батчей: ренормализация батчей (англ. Batch Renormalization). Данный метод улучшает нормализацию батчей, когда размер батчей мал и не состоит из независимых данных.

- Метод потоковой нормализации (англ. Streaming Normalization) был предложен в [13]. Данные метод убирает два ограничения нормализации батчей: использование при online-обучении и использование в рекуррентных нейронных сетях.

См. также

Примечания

- ↑ Ioffe S., Szegedy C. — Batch normalization: Accelerating deep network training by reducing internal covariate shift

- ↑ Датасет MNIST

- ↑ TensorFlow

- ↑ Keras

- ↑ CNTK

- ↑ Theano

- ↑ PyTorch

- ↑ Язык программирования Python

- ↑ Cooijmans T. — Recurrent batch normalization

- ↑ Huang L. — Decorrelated Batch Normalization

- ↑ Ba J. L., Kiros J. R., Hinton G. E. — Layer normalization

- ↑ Ioffe S. — Batch renormalization: Towards reducing minibatch dependence in batch-normalized models

- ↑ Liao Q., Kawaguchi K., Poggio T. — Streaming normalization: Towards simpler and more biologically-plausible normalizations for online and recurrent learning

Источники информации

- Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift

- Glossary of Deep Learning: Batch Normalisation

- Understanding the backward pass through Batch Normalization Layer

- Deeper Understanding of Batch Normalization with Interactive Code in Tensorflow

- Batch Normalization in Deep Networks