EM-алгоритм — различия между версиями

Dogzik (обсуждение | вклад) |

Egalkin (обсуждение | вклад) (Обновление части конспекта. Внесение информации из презентаций по курсу.) |

||

| Строка 1: | Строка 1: | ||

== Определение == | == Определение == | ||

| − | '''Алгоритм EM''' --- алгоритм поиска максимума правдоподобия | + | '''Алгоритм EM''' (англ: expectation-maximization) --- итеративный алгоритм поиска оценок максимума правдоподобия модели, в ситуации, когда она зависит от скрытых(ненаблюдаемых) переменных. |

Алгоритм ищет параметры модели итеративно, каждая итерация состоит из двух шагов: | Алгоритм ищет параметры модели итеративно, каждая итерация состоит из двух шагов: | ||

| − | '''E(Expectation''') шаг, в | + | '''E(Expectation)''' шаг --- поиск наиболее вероятных значений скрытых переменных. |

| + | |||

| + | '''M(Maximisation)''' шаг --- поиск наиболее вероятхын значений параметров, для полученных на шаге E значений скрытых переменных. | ||

| + | |||

| + | EM алгоритм подходит для решения задач двух типов: | ||

| + | |||

| + | # Задачи с неполными данными. | ||

| + | # Задачи, в которых удобно вводить скрытые переменные для упрощения подсчета функции правдободобия. Примером такой задачи может служить кластеризация | ||

| + | |||

| + | == Проблема восстановления распределения смеси == | ||

| + | |||

| + | === Постановка задачи === | ||

| + | |||

| + | Плотность распределения смеси имеет вид:<br/> | ||

| + | <tex>p(x) = \sum\limits_{i=1}^k \omega_j p_j(x)</tex><br/> | ||

| + | Где <tex> \sum\limits_{i=1}^k w_j = 1; w_j >= 0; p_j(x) = \phi(x;\theta_j)</tex> - функция правдоподобия <tex>j</tex>-ой компонеты смеси, <tex>\omega_j</tex> - априорная вероятность <tex>j</tex>-ой компоненты распределения.<br/> | ||

| + | |||

| + | Перед нами стоит две задачи:<br/> | ||

| + | |||

| + | # По заданной выборке <tex>X^m</tex> случайных и независимых наблюдений полученных из смеси <tex>p(x)</tex>, числу <tex>k</tex> и функцию <tex>\phi</tex>, оценить вектор параметров <tex>\Theta = (\omega_1,..,\omega_k,\theta_1,..,\theta_k)</tex> | ||

| + | # Найти <tex>k</tex> | ||

| + | |||

| + | === Проблема === | ||

| + | |||

| + | Задачи подобного рода мы умеем решать максимизируя логармиф правдоподобия:<br> | ||

| + | <tex> L(\Theta) = ln \prod\limits_{i=1}^mp(x_i) = \sum\limits_{i=1}^m ln\sum\limits_{j=1}^k w_j p_j(x_i; \theta_j) \longrightarrow max</tex><br/> | ||

| + | |||

| + | Но пробелма в том, что мы не знаем как аналитически посчитать логарифм суммы. Тут нам и поможет алгоритм EM. | ||

| + | |||

| + | === Решение === | ||

| + | |||

| + | Основная идея алгоритма EM заключается в том, что мы добавляме скрытые переменные такие, что:<br/> | ||

| + | |||

| + | # Они могут быть выражены через <tex>\Theta</tex> | ||

| + | # Они помогают разбить сумму так: <tex>p (X, H|\Theta) = \prod\limits_{i=1}^k p (X|H, \Theta) p(H|\Theta)</tex>, где <tex>H</tex> - матрица скрытых переменных. | ||

| + | |||

| + | Тогда алгоритм EM сводится к повторению шагов, указанных в [[#Определение|Определение]]. | ||

| + | |||

| + | === E-шаг === | ||

| + | |||

| + | <tex>p(x,\theta_j) = p(x)P(\theta_j | x) = w_jp_j(x)</tex> <br /> | ||

| + | |||

| + | Скрытые переменные представляют из себя матрицу <tex>H = (h_{ij})_{m \times k}</tex><br/> | ||

| + | где <tex>h_{ij} = P(\theta_j | x_i)</tex> - вероятность того, что <tex>x_i</tex> пренадлежит <tex>j</tex>-ой компоненте.<br/> | ||

| + | |||

| + | По формуле Байеса справедливо равенство:<br /> | ||

| + | <tex> h_{ij} = \frac{w_jp_j(x_i)}{p (x_i)} = \frac{w_jp_j(x_i)}{\sum\limits_{s=1}^k w_s p_s(x_i)}</tex><br/> | ||

| + | |||

| + | Также <tex>\sum\limits_{j=1}^k h_{ij} = 1</tex><br/> | ||

| + | |||

| + | Таким образом, зная значения вектора параметров <tex>\Theta</tex>, мы легко можем пересчитать значения скрытых переменных<br/> | ||

| + | |||

| + | === M-шаг === | ||

| + | |||

| + | {{Теорема | ||

| + | |statement= | ||

| + | Если известны скрытые переменные, то задача минимизации <tex>Q(\Theta)</tex> сводится к <tex>k</tex> независимым подзадачам:<br/> | ||

| + | <center><tex>\theta_j = argmax_{\theta} \sum\limits_{i=1}^m h_{ij}*ln \phi (x_i, \theta)</tex></center> | ||

| + | Оптимальные же веса считаются как:<br/> | ||

| + | <center><tex> w_j = \frac {1} {m} \sum\limits_{i=1}^m h_{ij}</tex></center> | ||

| + | }} | ||

| + | |||

| + | === Псевдокод === | ||

| + | |||

| + | Input:<tex>X^m, k, \theta^{(0)}</tex> | ||

| + | Repeat | ||

| + | '''E-step''': for all i = 1..m; j = 1..k: | ||

| + | <tex>h_{ij} = \frac{w_jp_j(x_i)}{\sum\limits_{s=1}^k w_s p_s(x_i)}</tex> | ||

| + | '''M-step''': for all j = 1..k: | ||

| + | <tex>\theta_j = argmax_{\theta} \sum\limits_{i=1}^m h_{ij}*ln \phi (x_i, \theta)</tex> | ||

| + | <tex>w_j = \frac {1} {m} \sum\limits_{i=1}^m h_{ij}</tex> | ||

| + | Until stopping criteria is satisfied | ||

| + | |||

| + | |||

| + | |||

| + | |||

| + | |||

| + | |||

| + | |||

| + | |||

| − | |||

== Задача разделения смеси распределений == | == Задача разделения смеси распределений == | ||

Версия 01:55, 17 марта 2020

Содержание

Определение

Алгоритм EM (англ: expectation-maximization) --- итеративный алгоритм поиска оценок максимума правдоподобия модели, в ситуации, когда она зависит от скрытых(ненаблюдаемых) переменных.

Алгоритм ищет параметры модели итеративно, каждая итерация состоит из двух шагов:

E(Expectation) шаг --- поиск наиболее вероятных значений скрытых переменных.

M(Maximisation) шаг --- поиск наиболее вероятхын значений параметров, для полученных на шаге E значений скрытых переменных.

EM алгоритм подходит для решения задач двух типов:

- Задачи с неполными данными.

- Задачи, в которых удобно вводить скрытые переменные для упрощения подсчета функции правдободобия. Примером такой задачи может служить кластеризация

Проблема восстановления распределения смеси

Постановка задачи

Плотность распределения смеси имеет вид:

Где - функция правдоподобия -ой компонеты смеси, - априорная вероятность -ой компоненты распределения.

Перед нами стоит две задачи:

- По заданной выборке случайных и независимых наблюдений полученных из смеси , числу и функцию , оценить вектор параметров

- Найти

Проблема

Задачи подобного рода мы умеем решать максимизируя логармиф правдоподобия:

Но пробелма в том, что мы не знаем как аналитически посчитать логарифм суммы. Тут нам и поможет алгоритм EM.

Решение

Основная идея алгоритма EM заключается в том, что мы добавляме скрытые переменные такие, что:

- Они могут быть выражены через

- Они помогают разбить сумму так: , где - матрица скрытых переменных.

Тогда алгоритм EM сводится к повторению шагов, указанных в Определение.

E-шаг

Скрытые переменные представляют из себя матрицу

где - вероятность того, что пренадлежит -ой компоненте.

По формуле Байеса справедливо равенство:

Также

Таким образом, зная значения вектора параметров , мы легко можем пересчитать значения скрытых переменных

M-шаг

| Теорема: |

Если известны скрытые переменные, то задача минимизации сводится к независимым подзадачам: Оптимальные же веса считаются как: |

Псевдокод

Input: Repeat E-step: for all i = 1..m; j = 1..k: M-step: for all j = 1..k: Until stopping criteria is satisfied

Задача разделения смеси распределений

Общий алгоритм

Необходимо описать плотность распределения функции на X как сумму k функций, которые можно рассматривать как элементы параметрического семейства функций . Плотность распределения будет выглядеть как

где - априорная вероятность j компоненты распределения.

Задача разделения смеси заключается в том, чтобы, имея выборку случайных и независимых наблюдений из смеси , зная число и функцию , оценить вектор параметров

E-шаг:

Введем обозначение: это и будут скрытые параметры данной задачи - апостериорная вероятность того, что обучающий объект получен из -й компоненты

По формуле Байеса справедливо равенство:

Таким образом при зная значение параметров легко найти скрытые переменные.

Перейдем к M-шагу.

Посчитаем для аддитивности логарифм правдоподобия:

при условии имеет смысл рассматривать лагранжиан задачи:

Умножим на и просуммируем уравнения для всех

Так как можно заменить порядок суммы: .

А так как и , из чего следует

Приравняв к нулю лагранжиан по схожим способом найдем:

Таким образом на M-шаге необходимо взять среднее значение и решить k независимых оптимизационных задач.

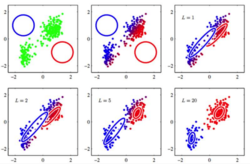

Разделение смеси гауссиан

Важным на практике примером является случай, когда параметрическое семейство - нормальные распределения. Параметрами функций будут являться матожидание и дисперсия.

— вектор параметров,

k-means как EM алгоритм

Скрытыми переменными в данной задаче являются классы, к которым относятся объекты для кластеризации. Сами же параметры это центры масс классов. На шаге E - распределяются все объекты по классам исходя из расстояния от центра, на шаге M находится оптимальное месторасположение центра.

Аналогично рассматривается и алгоритм c-means. Скрытые переменные здесь будут вероятности принадлежности к классам, которые находятся на E-шаге по расстоянию от центра. Центр так же рассчитывается на M-шаге исходя из скрытых переменных.

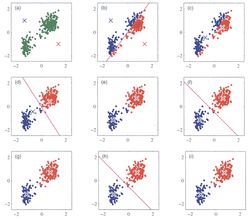

Реализация на python

import numpy as np

import matplotlib.pyplot as plt

from sklearn import cluster, datasets, mixture

from sklearn.preprocessing import StandardScaler

from itertools import cycle, islice

np.random.seed(12)

# Создаем datasets с использованием стандартных sklearn.datasets

n_samples = 2000

random_state = 170

noisy_circles = datasets.make_circles(n_samples=n_samples, factor=.5, noise=.05)

noisy_moons = datasets.make_moons(n_samples=n_samples, noise=.05)

blobs = datasets.make_blobs(n_samples=n_samples, random_state=8)

varied = datasets.make_blobs(n_samples=n_samples, cluster_std=[1.0, 2.5, 0.5], random_state=random_state)

# Создаем анизатропно разделенные данные

X, y = datasets.make_blobs(n_samples=n_samples, random_state=random_state)

transformation = [[0.6, -0.6], [-0.4, 0.8]]

X_aniso = np.dot(X, transformation)

aniso = (X_aniso, y)

# Выставляем параметры для matplotlib.pyplot

plt.figure(figsize=(9 * 2 + 3, 12.5))

plt.subplots_adjust(left=.02, right=.98, bottom=.001, top=.96, wspace=.05, hspace=.01)

plot_num = 1

defaul_n = 3

# Варьируем значение количества классов в зависимости от данных, ведь для нас это гиперпараметр

datasets = [

(varied, defaul_n),

(aniso, defaul_n),

(blobs, defaul_n),

(noisy_circles, 2)]

for i_dataset, (dataset, n_cluster) in enumerate(datasets):

X, y = dataset

# Нормализация данных

X = StandardScaler().fit_transform(X)

# Непосредственно наш алгоритм - Gaussian Mixture

gmm = mixture.GaussianMixture(n_components=n_cluster, covariance_type='full')

# Для сравнения берем алгоритм - K-means

two_means = cluster.KMeans(n_clusters=n_cluster)

clustering_algorithms = (

('GaussianMixture', gmm),

('KMeans', two_means)

)

for name, algorithm in clustering_algorithms:

# Этап обучения

algorithm.fit(X)

# Применяем алгоритм

y_pred = algorithm.predict(X)

# Рисуем результаты

plt.subplot(len(datasets), len(clustering_algorithms), plot_num)

if i_dataset == 0:

plt.title(name, size=18)

colors = np.array(list(islice(cycle(['#377eb8', '#ff7f00', '#4daf4a']), int(max(y_pred) + 1))))

plt.scatter(X[:, 0], X[:, 1], s=10, color=colors[y_pred])

plt.xlim(-2.5, 2.5)

plt.ylim(-2.5, 2.5)

plt.xticks(())

plt.yticks(())

plot_num += 1

plt.show()

Как и следовало ожидать, алгоритм работает на некоторых данных лучше чем k-means, однако есть данные, с которыми он не справляется без дополнительных преобразований.