Теорема о гигантской компоненте. Поиск в ширину в случайном графе — различия между версиями

Cuciev (обсуждение | вклад) (index fix) |

Cuciev (обсуждение | вклад) (index fix) |

||

| Строка 28: | Строка 28: | ||

Данный процесс очень похож на [[Обход в ширину|поиск в ширину]], этим свойством мы воспользуемся позднее.<br> | Данный процесс очень похож на [[Обход в ширину|поиск в ширину]], этим свойством мы воспользуемся позднее.<br> | ||

| − | Обозначим число активных вершин в момент времени <tex>t</tex> через <tex>Y_t</tex>, число нейтральных вершин {{---}} через <tex>N_t</tex>, а число соседей вершины, которую собираемся пометить как неактивную, {{---}} через <tex>Z_t</tex>. Тогда <tex>Y_0 = 1,Y_t = | + | Обозначим число активных вершин в момент времени <tex>t</tex> через <tex>Y_t</tex>, число нейтральных вершин {{---}} через <tex>N_t</tex>, а число соседей вершины, которую собираемся пометить как неактивную, {{---}} через <tex>Z_t</tex>. Тогда <tex>Y_0 = 1,Y_t = Y_{t − 1} + Z_t − 1</tex>. Все введенные величины зависят от графа <tex>G</tex> и от последовательности выбираемых вершин <tex>v_1,\dotsc</tex>. |

Если <tex>G</tex> посчитать случайным, то при любом выборе вершин <tex>v_1,\dotsc</tex> получатся случайные величины <tex>Y_t, N_t, Z_t</tex> на пространстве <tex>G(n, p)</tex>. | Если <tex>G</tex> посчитать случайным, то при любом выборе вершин <tex>v_1,\dotsc</tex> получатся случайные величины <tex>Y_t, N_t, Z_t</tex> на пространстве <tex>G(n, p)</tex>. | ||

Версия 00:05, 25 июня 2020

Содержание

Теорема о гигантской компоненте

Перед формулировкой основной теоремы данного раздела, дадим определение некоторых понятий, которые будут использованы в дальнейшем, а также приведем необходимые далее утверждения.

| Определение: |

| Простейший ветвящийся процесс. Пусть — независимые пуассоновские величины[1] с одним и тем же математическим ожиданием . Положим . |

Представлять себе описанный только что процесс можно так: в начальный момент времени есть одна активная частица. Затем она создает (может быть достигнуто, так как величина равна нулю с положительной вероятностью) активных потомков и перестает быть активной. На следующем шаге все повторяется: какая-то частица (порядок роли не играет) порождает новых частиц, а сама перестает быть активной, и так далее. Данный процесс может как завершиться (частицы перестанут быть активными), так и продолжаться бесконечно.

Говоря в терминах данного выше определения, и — количество активных и порожденных частиц в момент времени , соответственно.

| Теорема (1): |

Пусть . Тогда с вероятностью 1 процесс вырождается, т.е. . |

| Теорема (2): |

Пусть . Пусть — единственное решение уравнения . Тогда процесс вырождается с вероятностью , т.е. . |

| Определение: |

| Ветвящийся процесс на случайном графе. Пусть — независимые пуассоновские величины с одним и тем же математическим ожиданием . Положим . |

В произвольном графе зафиксируем . Пометим ее как активную, а все остальные вершины — нейтральными. Выберем среди нейтральных вершин всех соседей вершины . После этого пометим вершину как неактивную , а смежных с ней — как активных, а все остальные вершины — нейтральными.

Снова зафиксируем какую-нибудь активную вершину , и повторим процесс, не меняя статус остальных уже активных вершин.

Продолжая этот ветвящийся процесс, мы в конце концов получим лишь неактивные (образующие компоненту, содержащую ) и нейтральные вершины.

Данный процесс очень похож на поиск в ширину, этим свойством мы воспользуемся позднее.

Обозначим число активных вершин в момент времени через , число нейтральных вершин — через , а число соседей вершины, которую собираемся пометить как неактивную, — через . Тогда . Все введенные величины зависят от графа и от последовательности выбираемых вершин .

Если посчитать случайным, то при любом выборе вершин получатся случайные величины на пространстве .

Теорема о гигантской компоненте

| Теорема (о гигантской компоненте): |

Рассмотрим модель . Пусть .

|

| Доказательство: |

|

Приведем здесь идеи[2], изложенные А.М. Райгородским, основанные на доказательстве[3] Р. Карпа. Такой формат позволит понять основные идеи и логику рассуждений. Строгий вариант приведен в [4]. Здесь и далее: — биномиальное распределение. Случай . Положим , где — константа, которая будет подобрана далее. Нам хочется доказать, что с большой вероятностью каждая из компонент случайного графа имеет размер .

Но размер компоненты — это момент вырождения процесса на случайном графе. Значит, интересующее нас утверждение можно записать в следующем виде:

Поскольку , достаточно найти такое , при котором

Поскольку , нижний предел интегрирования имеет порядок . Таким образом, весь интеграл не превосходит величины

. Выберем таким, чтобы оказалось меньше, чем

, и в случае теорема доказана. Случай . В данном случае ветвящийся процесс на графе нужно «запускать» не один раз, а многократно. Только так удается доказать, что а.п.н. хотя бы в одном запуске возникнет гигантская компонента. Подробности можно найти в [4], мы же лишь поясним, откуда в текущей ситуации появляется из формулировки теоремы 2 и почему она совпадает с одноименной константой из той же теоремы. Чтобы доказать, что есть гигантская компонента, необходимо, чтобы ветвящийся процесс на графе не вырождался даже

при , то есть: Так как по условию , то при выполнено: Применим центральную предельную теорему к Пределы интегрирования в данном случае: от до . Если , то мы получим искомое стремление вероятности к нулю. Если , то вероятность, напротив, будет стремиться к единице. Таким образом, критическое значение , вплоть до которого есть именно стремление к нулю, — это решение уравнения или, что равносильно, . А это и есть уравнение из теоремы 2, если заменить на . |

Обход случайного графа

Приведем ряд утверждений, которые будут использованы а дальнейшем. Их доказательство, а также более детальный рассказ можно найти здесь[5].

| Лемма (1): |

Пусть . Тогда вероятность , что ( — компонента связности, содержащая ): — константа. |

| Доказательство: |

| Главная идея доказательства, которую мы будем использовать в дальнейшем — изменение алгоритма поиска в ширину таким образом, чтобы только что открытые вершины были выбраны из множества фиксированного размера. Такая модификация превращает поиск в ширину в ветвящийся процесс. |

| Теорема (4): |

Пусть . |

Поиск в ширину

Рассмотрим граф . Проанализируем его структуру по мере роста :

- граф состоит только из изолированных вершин. С ростом в нем появляются ребра, компоненты связности получающегося леса объединяются.

- граф а.п.н. является лесом;

- появляются циклы. При размер каждой из компонент связности равен . Число компонент связности, содержащих только один цикл — константа, зависящая от . Таким образом, граф состоит из леса и компонент, содержащих единственный цикл без компонент размера ;

- начинает образовываться гигантская компонента. Этот процесс происходит в два этапа:

- возникают компоненты из вершин, а.п.н. являющиеся деревьями;

- появляется гигантская компонента размером, пропорциональным количеству вершин во всем графе;

- возникают компоненты из вершин, а.п.н. являющиеся деревьями;

- все неизолированные вершины оказываются в гигантской компоненте;

- в графе остаются только изолированные плюс гигантская компонента;

- граф становится связным;

- — клика ;

Чтобы вычислить размер компоненты связности, пройдемся с помощью поиска в ширину по ней, стартуя из произвольной вершины и переходя к очередной неисследованной вершине, только если ребро между ними существует (данный факт необходимо установить независимо от других ребер, с вероятностью ). Если ребро существует, пометим следующую вершину как "открытую". Алгоритм закончит свою работу (обойдет всю компоненту связности), когда множество неисследованных "открытых" вершин станет пустым.

Проблема поиска в ширину

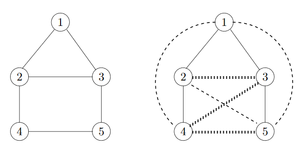

На данном изображении представлены результаты работы поиска в ширину , начавшемся в вершине на двух графах: в первом у всех ребер , во втором же факт существования ребра определялся по ходу работы алгоритма — ребра, отмеченные пунктиром, не существуют. Проблема возникает, когда алгоритм просто не доходит до каких-то ребер, не выясняя, существуют они или нет: находясь в вершине , алгоритм не делал запрос о ребре , так как у этому моменту вершина уже была исследована. Ребра, которые потенциально могли быть не изученными, помечены на рисунке точечным пунктиром.

Неоткрытые вершины

Будем считать шагом алгоритма поиска открытие новой вершины. После первых шагов алгоритма, любая из вершин, кроме стартовой, может быть неоткрытой с вероятностью . Пусть — число вершин, открытых за первые шагов алгоритма поиска. распределены как .

Вероятность исчезновения

От поиска в ширину к ветвящимся процессам

Пользуясь идеями, изложенными в доказательстве леммы 1, перейдем от модифицированного поиска в ширину к ветвящемуся процессу. Этот процесс используется для генерации случайных деревьев, возможно, бесконечного размера.

| Определение: |

| Вероятность исчезновения (extinction probability) — вероятность, того, что дерево ветвящегося процесса будет конечным (процесс завершится через конечное время). |

Рассмотрим натуральное случайное число , обозначающее количество потомков у очередной исследованной вершины. Каждый раз это значение выбирается случайно и независимо.

Процесс построения дерева заканчивается, образуя конечное дерево, когда у каждой вершины построены все ее потомки. Данный процесс может продолжаться бесконечно.

Пусть:

- .

- — вероятность того, что в модифицированном поиске в ширину.

- — вероятность окончания процесса.

Тогда , поскольку поиск в ширину, заканчивающийся с вершинами, приводит к окончанию построения дерева.

— вероятность, что производит потомков, а значит:

и .

Глубина дерева не меньше количества вершин, поэтому вероятность того, что процесс закончится с деревом глубины , вычисляется по следующей формуле:

Вычисление вероятности исчезновения

| Лемма (2): |

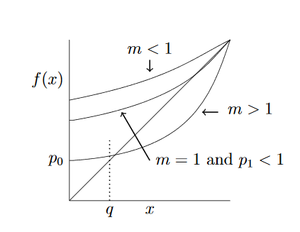

Пусть . Пусть — единственный корень на . Тогда для . |

| Теорема (5): |

Рассмотрим дерево, сгенерированное ветвящимся процессом. Пусть — производящая функция числа потомков каждой вершины, а — ожидаемое количество потомков в каждой вершине. Тогда верно следующее: . |

В данной статье нами рассматривается простой случай ветвящегося процесса, в котором распределение количества потомков одинаково для каждой вершины.

Обозначим:

- — вероятность исчезновения;

- — количество потомков у очередной исследованной вершины;

- — вероятность, что производит потомков.

Для того, чтобы вычислить вероятность исчезновения, воспользуемся производящей функцией:

где — вероятность того, что

Так как — вероятность конечности алгоритма, то, если у корневой вершины потомков, построение каждого из поддеревьев должно завершиться, и это произойдет с вероятностью :

Благодаря чему, является корнем уравнения:

Рассмотрим решение данного уравнения на .

— всегда решение данного уравнения, так как .

Введем обозначения: — количество потомков вершины, а , тогда .

Кажется, что при дерево будет расти вечно, так как каждая вершина в момент времени должна иметь потомков, однако при с положительной вероятностью у корня может вообще не быть потомков. В исходном играет роль , ввиду того, что .

Пользуясь леммой 2 и теоремой 5, можно доказать, что:

- — вероятность исчезновения ;

- — вероятность исчезновения ;

- — вероятность исчезновения , но, если , процесс не завершится, так как у каждой вершины найдется по крайней мере один потомок;

Подробное описание доказательства данного факта, а также самих утверждений можно найти здесь[5].

Вывод

Используя результаты, полученные в предыдущей части, сделаем вывод о вероятности окончания работы поиска в ширину на случайном графе . Рассчитав и , можно сделать следующие выводы:

См. также

Литература

- ↑ https://ru.wikipedia.org/wiki/Распределение_Пуассона

- ↑ Введение в математическое моделирование транспортных потоков: Учебное пособие/Издание 2-е, испр. и доп. А. В. Гасников и др. Под ред. А. В. Гасникова.— М.: МЦНМО, 2013 — C.330-339 — ISBN 978-5-4439-0040-7

- ↑ Karp R. The transitive closure of a random digraph//Random structures and algorithms. 1990. V. 1. P. 73–94.

- ↑ 4,0 4,1 Алон Н., Спенсер Дж. Вероятностный метод. М.: Бином. Лаборатория знаний, 2007.

- ↑ 5,0 5,1 Blum A. Random Graphs // CS 598 Topics in Algorithms (UIUC), 2015. URL: https://www.cs.cmu.edu/~avrim/598/chap4only.pdf